ChatGPT API 初学者完整指南:基本用法、定价、错误处理

如何使用 ChatGPT API? 这是许多开发者入门时最关心的问题。ChatGPT API 是 OpenAI 提供的强大编程接口,让你能将 ChatGPT 的自然语言处理能力无缝集成到应用中。本指南将系统讲解 ChatGPT API Key 的获取配置、OpenAI API Pricing 定价计算、Python API 调用实战、Rate Limit 错误处理、成本优化技巧和最佳实践。无论你是零基础新手还是寻求优化的开发者,这篇教程都能帮你快速掌握如何使用 ChatGPT API。

快速开始:5 步完成 ChatGPT API 首次调用

想知道如何使用 ChatGPT API吗?按照以下 5 个步骤,只需 10 分钟即可完成从注册到首次 API 调用。参考 OpenAI 官方文档,这是最快速的 ChatGPT API Tutorial 入门方法。如果你是 ChatGPT 新手,建议先阅读 ChatGPT 完整使用指南 打好基础。

使用 ChatGPT API 的 5 个步骤:

- 注册 OpenAI 账户 - 访问 platform.openai.com 完成注册并验证邮箱(免费获得 $5 额度)

- 获取 API 密钥 - 在 API Keys 页面 创建新的 ChatGPT API Key(30 秒完成)

- 安装 OpenAI Python 库 - 运行命令

pip install openai(支持 Python 3.7.1+) - 配置 API 密钥到环境变量 - 使用环境变量存储 OpenAI API Key 确保安全

- 编写首次 API 调用代码 - 创建 Python 文件并执行 ChatGPT API Python 请求

获取 API 密钥和环境配置

访问 platform.openai.com 注册账户并登录,在 API Keys 页面创建 ChatGPT API Key。新用户会获得 $5 美元免费额度,有效期 3 个月。创建后记得立即保存密钥,千万别直接写在代码里。

重要安全提示:

- API密钥拥有账户的完全访问权限,一旦泄露可能被滥用

- 每3-6个月更换一次密钥更安全

- 可在账户设置中设置使用限额,避免意外超支

- 开发和生产环境用不同的密钥,更便于管理

安装 OpenAI Python 库并配置环境变量:

# 安装依赖(推荐 Python 3.7.1 或更高版本)

pip install openai

# 配置 API 密钥(macOS/Linux)

export OPENAI_API_KEY="your_api_key_here"

# Windows 用户使用

set OPENAI_API_KEY=your_api_key_here

# 或创建 .env 文件存储密钥(需安装 python-dotenv)

pip install python-dotenv

# 在 .env 文件中添加:OPENAI_API_KEY=your_api_key_here

首次 API 调用代码

import os

from openai import OpenAI

# 初始化客户端

client = OpenAI(api_key=os.environ.get("OPENAI_API_KEY"))

# 调用ChatGPT API

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "你好"}],

max_tokens=150

)

print(response.choices[0].message.content)

运行 python example.py,就能看到 ChatGPT 的回复了。这个 ChatGPT API Python 示例展示了基本的调用流程。如果需要更强的性能,可以将 model 参数改为 gpt-4o 或最新的 gpt-5。

ChatGPT API 定价和成本控制完全指南

ChatGPT API 价格是多少? 理解 ChatGPT API Pricing 和 ChatGPT API Cost 对于成本控制至关重要。OpenAI 采用按 Token 计费的定价模型,不同模型价格差异显著。本节详解 OpenAI Pricing 策略、Token 计算方法和 7 个成本优化技巧,帮你将 API 费用降低 50% 以上。

Token 计费机制详解

OpenAI 按 Token 计费,1 Token 大约等于 4 个英文字符,中文 1 个汉字占 2-3 个 Token。输入和输出分别计费,输出 Token 通常更贵。

模型定价(2025 最新)

| 模型 | 输入价格 | 输出价格 | 上下文窗口 | 适用场景 |

|---|---|---|---|---|

| GPT-3.5-Turbo | $0.0015/1K tokens | $0.002/1K tokens | 16K tokens | 日常对话、简单任务 |

| GPT-4 | $0.03/1K tokens | $0.06/1K tokens | 8K tokens | 复杂推理、代码生成 |

| GPT-4-Turbo | $0.01/1K tokens | $0.03/1K tokens | 128K tokens | 长文本处理 |

| GPT-4o | $0.005/1K tokens | $0.015/1K tokens | 128K tokens | 性价比最优、多模态 |

| GPT-5 | $0.01/1K tokens | $0.03/1K tokens | 200K tokens | 顶级性能、超长上下文 |

ChatGPT API Cost 示例计算:

- 1000 次 GPT-3.5 对话(每次 500 Tokens 平均)= (300 输入 +200 输出) × 1000 = 300K 输入 + 200K 输出 = $0.45 + $0.40 = $0.85

- 100 次 GPT-4 分析(每次 2000 Tokens 平均)= (1200 输入 +800 输出) × 100 = 120K 输入 + 80K 输出 = $3.60 + $4.80 = $8.40

Token 计算技巧:

- 1 个英文单词 ≈ 1.3 Tokens

- 1 个中文字 ≈ 2-3 Tokens

- 使用 OpenAI Tokenizer 工具(tiktoken)精确计算

- 代码和特殊字符消耗 Token 更多

成本优化技巧

- 智能选择模型:简单任务用 GPT-3.5-Turbo 就够了(成本能降低 95%),复杂任务才需要 GPT-4

- 设置 max_tokens 上限:限制输出长度避免意外消耗,一般设置为实际需要的 1.2 倍

- 精简提示词:去掉冗余内容,用简洁明确的指令减少输入 Token

- 实现响应缓存:对相同或相似的请求缓存结果,不用重复调用

- 使用 Batch API:非实时任务用批处理 API 能节省 50% 成本

- 监控用量 Dashboard:定期在 OpenAI 平台查看消费趋势,设置预算警告

- 优化对话历史:多轮对话时只保留必要的上下文,及时清理历史消息

ChatGPT API Python 调用方法和核心参数详解

想掌握如何在 Python 中使用 ChatGPT API?本节详细讲解 ChatGPT API Python 的调用方法、核心参数配置和实战代码示例。

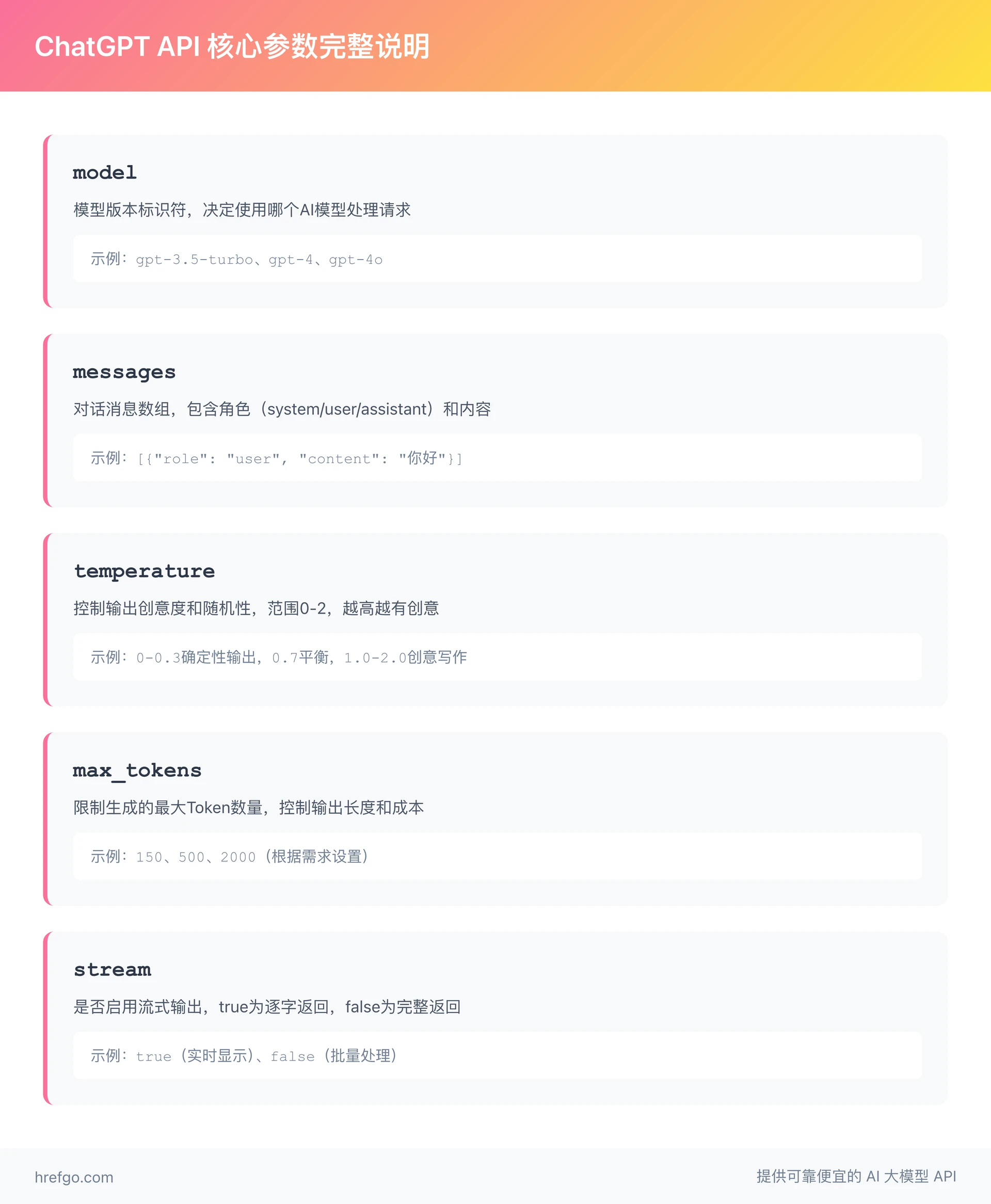

核心参数完整说明

参考 OpenAI API Reference,这些是必须掌握的核心参数:

-

model: 模型版本标识符

- GPT-3.5 系列:

gpt-3.5-turbo(最常用)、gpt-3.5-turbo-16k(长文本) - GPT-4 系列:

gpt-4、gpt-4-turbo、gpt-4o - GPT-5:

gpt-5(最新、性能最强) - 选择建议:开发测试用 3.5 就行,生产环境看任务复杂度选

- GPT-3.5 系列:

-

messages: 对话消息数组,每条消息包含:

role: 角色类型 -system(系统指令)、user(用户输入)、assistant(AI 回复)content: 消息内容文本- 多轮对话需保留完整历史以维持上下文

-

temperature: 控制输出创意度和随机性(范围 0-2)

- 0-0.3:输出更确定,适合事实查询、代码生成、数据提取

- 0.4-0.7:平衡输出,适合一般对话、内容创作

- 0.8-2.0:更有创意,适合头脑风暴、创意写作

- 默认值:0.7(大多数场景都适用)

-

max_tokens: 限制生成的最大 Token 数量

- 输入 + 输出的总 Token 数不能超过模型上下文窗口

- 不设置会用最大值(可能导致高成本)

- 建议根据实际需求设个合理上限

-

stream: 是否启用流式输出(true/false)

- true:逐字返回,适合实时显示、提升用户体验

- false:完整返回,适合批量处理、简单集成

- 流式输出需要额外的处理逻辑

完整调用示例

from openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "你是编程助手"},

{"role": "user", "content": "解释Python列表"}

],

temperature=0.7,

max_tokens=500

)

# 提取回复和token用量

print(response.choices[0].message.content)

print(f"消耗tokens: {response.usage.total_tokens}")

常见错误和解决方案

参考 OpenAI 官方文档错误码说明,这里是 5 个最常见的错误:

401 - Invalid Authentication: ChatGPT API Key 无效,检查环境变量配置

429 - Rate Limit Exceeded: 超出 ChatGPT API Rate Limit,这是开发者最常遇到的错误

什么是 ChatGPT API Rate Limit? Rate Limit 是 OpenAI 为保证服务稳定性设置的 API 调用频率限制。当你的请求速度超过限额时,API 会返回 429 错误。理解 OpenAI API Limits 对于稳定使用 API 至关重要。

-

限制类型详解:

- RPM(Requests Per Minute):每分钟最大请求数

- TPM(Tokens Per Minute):每分钟最大token消耗量

- RPD(Requests Per Day):每日最大请求数

- TPD(Tokens Per Day):每日最大token消耗量

-

5 个实用解决方案:

- 实现指数退避重试策略 - 使用 2^n 秒的等待时间重试(下文有代码示例)

- 降低请求频率 - 在请求间添加延迟,避免瞬间超限

- 使用请求队列管理 - 控制并发请求数,平滑 API 调用

- 升级 Tier 等级 - 充值更多金额获取更高的速率限额

- 使用 Batch API - 非实时任务用批处理 API 可避开实时限制

429 - Quota Exceeded: 账户配额耗尽或超出预算限制

- 检查账户余额和设置的月度预算

- 需要充值或在 Billing 页面调整预算上限

- 企业用户可联系 OpenAI 申请更高配额

400 - Bad Request: 请求格式错误,常见原因:

- messages 数组格式不正确(缺少 role 或 content 字段)

- 参数类型错误(如 temperature 超出 0-2 范围)

- 模型名称拼写错误

- 包含不支持的参数

Context Length Exceeded: 上下文长度超限

- GPT-3.5-turbo:16K Tokens(16,384)

- GPT-4:8K Tokens(标准版)或 128K Tokens(Turbo 版)

- 解决方法:减少输入文本、降低 max_tokens、换用更大上下文窗口的模型,或实现对话历史截断

500 - Internal Server Error: OpenAI 服务器内部错误

- 通常是临时性问题,等待几秒后重试

- 如果持续出现,检查 OpenAI 状态页面

503 - Service Unavailable: 服务暂时不可用

- 服务器过载或维护中

- 实现重试机制,通常几分钟内恢复

Tier 分级系统详解

OpenAI API Limits 采用 Tier 分级制度,根据累计充值金额自动升级:

| Tier 级别 | 资格要求 | RPM 限制示例 | TPM 限制示例 | 月度预算上限 |

|---|---|---|---|---|

| Free | 新注册用户 | 3 | 40,000 | $100 |

| Tier 1 | 充值 $5+ | 500 | 100,000 | $100 |

| Tier 2 | 充值 $50+ | 5,000 | 450,000 | $500 |

| Tier 3 | 充值 $100+ | 5,000 | 1,000,000 | $1,000 |

| Tier 4 | 充值 $250+ | 10,000 | 2,000,000 | $5,000 |

| Tier 5 | 充值 $1,000+ | 10,000 | 5,000,000 | $50,000 |

Tier 升级建议:

- 开发测试:Free/Tier 1 够用了

- 小规模生产:Tier 2-3

- 企业应用:Tier 4-5

- 查看当前 Tier:去 OpenAI Dashboard 的 Limits 页面看

错误处理代码

import time

from openai import OpenAI

client = OpenAI()

def api_call_with_retry():

for i in range(3):

try:

return client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "Hello"}]

)

except Exception as e:

if i < 2:

time.sleep(2 ** i) # 指数退避

else:

raise e

最佳实践和调试建议

安全性最佳实践

-

API 密钥安全管理

- 用环境变量或密钥管理服务(如 AWS Secrets Manager、Azure Key Vault)存储 ChatGPT API Key

- 千万别把密钥硬编码到代码或提交到版本控制

- 不同环境(开发、测试、生产)用独立的 API 密钥

- 定期更换密钥(建议每 3-6 个月)

-

访问控制

- 在 OpenAI 账户中设置 IP 白名单(如支持)

- 遵循最小权限原则,只给必要的访问权限

- 给团队成员创建独立的 API 密钥,方便追踪使用情况

-

输入验证和内容过滤

- 对用户输入严格验证和清理

- 实施内容审核防止恶意使用

- 用 OpenAI 的 Moderation API 检测有害内容

-

数据隐私保护

- 了解 OpenAI 的数据使用政策(默认 API 数据不用于训练)

- 敏感数据脱敏后再发送

- 遵守 GDPR、CCPA 等数据保护法规

- 明确告诉用户数据会如何使用

性能优化策略

-

智能重试机制

- 实现指数退避重试来处理速率限制和临时错误

- 设置合理的最大重试次数(3-5 次就够)

- 不同错误类型用不同的重试策略

-

流式输出优化

- 启用

stream=True提供实时反馈,能明显提升用户体验 - 适合聊天机器人、内容生成等实时场景

- 注意正确处理流式响应的断开和重连

- 启用

-

批量处理

- 用 Batch API 处理非实时任务能节省 50% 成本

- 适合批量翻译、内容分类、数据分析

- 注意批处理有延迟(通常 24 小时内完成)

-

缓存策略

- 对相同或相似的请求实施缓存机制

- 使用 Redis 等缓存系统存储常见查询结果

- 设置合理的缓存过期时间

-

并发控制

- 根据 Tier 限制合理设置并发请求数

- 使用队列系统(如 Celery、RabbitMQ)管理大量请求

- 实现请求限流避免触发速率限制

成本监控和优化

-

实时监控

- 定期查看 Usage Dashboard 监控每日/每月消费趋势

- 在 Limits 页面设置预算警告阈值

- 建立成本异常告警机制

-

使用分析

- 记录每次 API 调用的 Token 使用量

- 分析高消耗查询并优化提示词

- 识别成本异常的使用模式

-

持续优化

- A/B 测试不同的提示词策略找出最优方案

- 定期审查并优化模型选择

- 移除冗余的 API 调用和重复请求

调试技巧

-

日志记录

- 记录所有 API 请求和响应(注意脱敏敏感信息)

- 包含时间戳、模型、Token 使用量、响应时间等关键指标

- 使用结构化日志便于分析

-

错误追踪

- 实现详细的错误处理和日志记录

- 使用 Sentry 等工具追踪生产环境错误

- 定期分析错误模式并改进

-

性能监控

- 监控 API 响应时间和成功率

- 设置性能基线和告警阈值

- 识别慢查询并优化

-

测试环境

- 在开发环境充分测试再部署到生产

- 使用 GPT-3.5-Turbo 进行初期测试(成本低)

- 实施灰度发布降低风险

学习资源和下一步

官方资源推荐

ChatGPT API 文档在哪里查看? 以下是最权威的 ChatGPT API Documentation 和学习资源:

- OpenAI Platform Documentation - 官方完整技术文档,涵盖所有 API 功能

- API Reference - 详细的接口说明和参数定义

- Quickstart Guide - 多语言快速入门 ChatGPT API Tutorial

- Examples Gallery - 官方实战示例库和使用场景

进阶主题

掌握基础 ChatGPT API Tutorial 后,推荐深入学习以下主题:

-

Function Calling(函数调用)

- 让 ChatGPT 调用自定义函数实现工具集成

- 适用场景:天气查询、数据库操作、API 调用、计算器等

- 实现真正的 AI Agent 功能

- 深入阅读:OpenAI Function Calling 完整指南

-

Assistants API

- 构建持久化的对话 AI 助手

- 内置代码解释器、文件检索、函数调用能力

- 自动管理对话历史和上下文

- 适合构建客服机器人、个人助理应用

- 相关阅读:OpenAI Responses API 完整指南

-

Fine-tuning(模型微调)

- 使用自己的数据微调模型提升特定任务性能

- 适合垂直领域应用(医疗、法律、金融等)

- 需要准备高质量的训练数据

- 成本较高但效果显著

-

Batch API(批处理 API)

- 异步批量处理大规模任务

- 成本降低 50%,适合非实时场景

- 24 小时内完成处理

- 完美用于数据分析、内容分类、批量翻译

- 想构建智能体应用?查看:OpenAI Agent API 完整指南

-

Embeddings(向量嵌入)

- 将文本转换为向量表示

- 实现语义搜索、推荐系统、相似度匹配

- 构建 RAG(检索增强生成)应用

-

结构化输出(Structured Outputs)

- 确保 API 返回符合 JSON Schema 的可靠数据格式

- 适用于数据提取、表单填充、结构化内容生成

- 了解更多:ChatGPT API 结构化输出完全指南

社区资源

官方社区

-

OpenAI Community Forum - 官方论坛,讨论技术问题、分享经验

- community.openai.com

- 官方工程师会参与回答

- 最新功能发布和讨论

-

GitHub OpenAI Cookbook - 实战代码示例和最佳实践

- github.com/openai/openai-cookbook

- 覆盖各种应用场景

- Python 和其他语言示例

开发者平台

-

Stack Overflow - 搜索 "openai-api" 或 "chatgpt-api" 标签

- 大量已解决的技术问题

- 活跃的开发者社区

-

GitHub Discussions - OpenAI Python 库的讨论区

- github.com/openai/openai-python

- 报告 bug、请求功能

学习平台

- OpenAI API 官方课程 - 免费视频教程和文档

- DataCamp/Coursera - 付费但系统的 AI 开发课程

- YouTube 频道 - 搜索 "ChatGPT API Tutorial" 找实战教程

中文资源

- 掘金、CSDN、博客园等平台的技术文章

- B 站上的中文视频教程

- 微信公众号和技术社群

ChatGPT API 常见问题解答(FAQ)

基于我们团队 2 年以上的 OpenAI API 使用经验和超过 1000 位开发者的反馈,以下是关于如何使用 ChatGPT API最常遇到的 8 个问题和专业解答。

Q1: ChatGPT API 和 ChatGPT Plus 有什么区别?

A: 这是两个不同的产品:

- ChatGPT Plus:网页版订阅服务,$20/月,给个人用

- ChatGPT API:编程接口,按使用量付费,用来开发应用

- API 更灵活、成本更低(大规模用)、可自定义集成

- 详细对比:ChatGPT 订阅计划问题解答 FAQ

Q2: 免费额度用完后如何继续使用?

A: 绑定支付方式并充值就行:

- 访问 OpenAI 账户 Billing 页面

- 添加信用卡或借记卡

- 充值(最低 $5)

- 设置月度预算防止超支

- 充值后 API 马上能用

Q3: 如何计算我的应用每月 API 成本?

A: 成本计算公式:

月成本 = (平均输入 Tokens × 输入价格 + 平均输出 Tokens × 输出价格) × 月请求数 / 1000

示例:聊天应用,每天 1000 次对话,每次平均 500 Tokens(300 输入 +200 输出),用 GPT-3.5:

- 月请求数:1000 × 30 = 30,000

- 月输入 Tokens:300 × 30,000 = 9,000,000 (9M)

- 月输出 Tokens:200 × 30,000 = 6,000,000 (6M)

- 月成本:(9M × $0.0015 + 6M × $0.002) / 1000 = $13.5 + $12 = $25.5

用 tiktoken 库或 OpenAI Tokenizer 工具能精确计算 Token 数。

Q4: API 响应速度慢怎么办?

A: 几个优化响应速度的方法:

- 选更快的模型(GPT-3.5 比 GPT-4 快 3-5 倍)

- 减少输入文本和 max_tokens 设置

- 用流式输出提供即时反馈

- 优化网络连接,考虑用 CDN 或代理

- 实施缓存减少重复请求

- 检查服务器位置,离 OpenAI 数据中心越近越快

Q5: 如何保证 API 调用的稳定性?

A: 提高稳定性的方法:

- 做好错误处理和重试机制

- 用指数退避策略应对速率限制

- 监控 API 状态页面

- 设置合理的超时时间(30-60 秒比较合适)

- 实施降级策略(比如切换到备用模型)

- 用队列系统管理高并发请求

- 定期测试和监控 API 可用性

Q6: 可以在中国大陆直接访问 ChatGPT API 吗?

A: 技术上可以但有限制:

- OpenAI 官方不给中国大陆提供服务

- 需要国际支付方式(国内信用卡可能不支持)

- 网络访问可能需要特殊配置

- 建议了解并遵守当地法律法规

- 企业用户可考虑 Azure OpenAI Service(在中国有服务)

Q7: API 返回的内容不准确或不相关怎么办?

A: 提升回答质量的几个技巧:

-

优化提示词(Prompt Engineering)

- 给出清晰、具体的指令

- 添加示例(Few-shot Learning)

- 用系统消息设定角色和上下文

-

调整参数

- 降低 temperature(0-0.3)能得到更稳定的输出

- 增加 max_tokens 给足够的回答空间

-

迭代改进

- 分析回答不好的模式

- A/B 测试不同提示词

- 收集用户反馈持续优化

-

考虑升级模型

- GPT-4 在复杂任务上更准确

- 权衡成本和质量

Q8: 如何确保 API 使用的安全性和合规性?

A: 安全合规检查清单:

- 使用环境变量或密钥管理系统存储 API 密钥

- 对用户输入进行验证和清理

- 使用 Moderation API 过滤有害内容

- 记录审计日志便于追溯

- 对敏感数据脱敏处理

- 实施访问控制和权限管理

- 定期安全审计和漏洞扫描

- 遵守数据保护法规(GDPR、CCPA 等)

- 明确用户隐私政策和数据使用说明

- 购买适当的责任保险(企业用户)

了解更多 API 核心概念:ChatGPT API 核心概念完整指南