Google 的网站爬虫(或“机器人”)是 SEO 排名过程的重要组成部分。如果您希望您的网站排名,您的网站需要被编入索引。要被索引,网站爬虫需要能够找到您的网站并对其进行排名。

在本指南中,让我们探索网站爬虫的作用以及它们为何重要。

什么是站点爬虫?

把互联网想象成一个巨大的图书馆,里面装满了无组织的内容。网站爬虫是互联网的图书馆员,负责抓取网页并为有用的内容编制索引。

搜索引擎有自己的网站爬虫;例如,谷歌有它的“谷歌机器人”。这些机器人(也称为“爬虫”或“蜘蛛”)访问新的或更新的网站,分析内容和元数据,并将其找到的内容编入索引。

还有第三方网站爬虫,您可以将其用作 SEO 工作的一部分。这些网站爬虫可以分析您网站的健康状况或竞争对手的反向链接配置文件。

网站爬虫如何工作?

当您在搜索引擎中输入搜索查询并收到可能匹配的列表时,您已经从网站爬虫的工作中受益。

网站爬虫是由大量计算机程序创建的复杂算法。它们旨在扫描和理解大量信息,然后将发现的内容与您的搜索词联系起来。但是他们如何获得这些信息呢?

让我们将其分解为每个网站爬虫采取的 3 个步骤:

- 抓取您的网站

- 扫描您网站上的内容

- 访问您网站上的链接(URL)

所有这些信息都存储在一个庞大的数据库中,并根据关键字和相关性进行索引。

然后,谷歌将最佳、最可靠、最准确和最有趣的内容排在前列,而其他人则从列表中查询。

不幸的是,不是所有的网页都会被抓取,这就是第三方网站爬虫工具可以提供帮助的地方。网站审核工具会抓取您的网站,突出显示任何错误和任何您可以用来提高网站可抓取性的建议。

站点审核工具如何提供帮助

过去,SEO 专业人士会开玩笑说,如果您没有网站,您可能还不如做生意。这些天来,如果网站爬虫找不到您的网站,那您也可能没有!

如果您的网站没有被抓取,那么您将有机流量吸引到它的机会为零。

当然,您可以付费购买广告以获得最高位置,但是——正如任何 SEO 专业人士会告诉你的那样——自然流量是一个非常准确的网站质量指标。

为确保搜索引擎爬虫能够通过,您需要定期爬取自己的网站。添加新内容并优化页面和内容是实现此目的的一种可靠方法。链接到您的内容的人越多,您对 Google 的信任度就越高。

在现场审核工具可帮助:

- 使用专门的网站爬虫来检查您网站的健康状况

- 检查可能影响您网站的 120 多个问题

- 向您展示要在您的网站上修复的确切内容(以及为什么它很重要)

使用站点审核工具修复错误

如果您是 SEO 新手,看到您的报告时不要惊慌!不喜欢看到站点错误和警告,但尽快修复它们很重要。

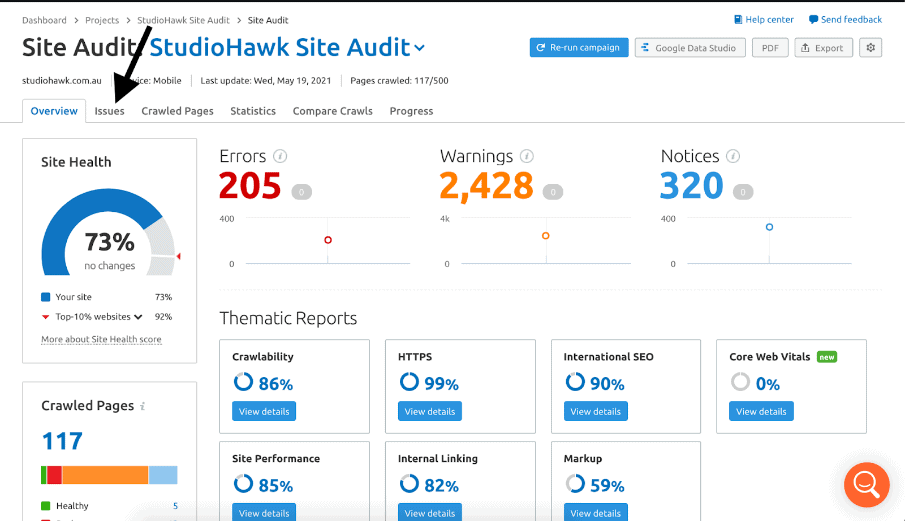

完成后,站点审核工具将返回它在您的站点上发现的错误列表。这些问题通常分为以下几类:

- 错误:这些是影响很大的问题,因此将它们视为优先事项。这些是阻止您的网站被抓取或索引的任何主要问题。

- 警告:这些问题仍然很重要,但不如错误重要。计划接下来解决这些问题。

- 注意:这些不是严重的问题,但它们可能会影响您的用户体验。当所有其他问题都得到解决时,请注意这些。

该工具解释了每个问题并提供了修复建议。您可以在“问题”选项卡中过滤或排序特定问题:

在概览页面上,您将看到您的可抓取性分数。该专题报告概述了索引页面以及阻止机器人抓取页面的任何问题。

逐步完成这些,直到完成列表中的每一项。如果您是 Trello 或 Zapier 用户,则可以将任何任务分配给看板或任务管理器。

完成站点更新后,再运行一次审核。完成后,您可以选择“比较爬网”以查看您的努力是否以及如何影响您网站的健康。

检查您网站的可抓取性

为确保您的网站被搜索引擎编入索引,请尽可能使您的网站可抓取。您需要确保有效地设置它以允许机器人探索他们可以探索的每个页面。

谷歌未来可能会改变排名因素,但我们知道用户体验和可抓取性将继续存在。

定期运行站点审核可帮助您掌握可能影响站点可抓取性的潜在错误。请记住:网站维护是一个专门的过程,所以不要害怕花费大量时间!