本篇文章讲解了一个更高级的搜索引擎优化概念:爬取配额规划。任何搜索引擎只能花有限的时间爬行您的网站,因此,如果您在索引方面有任何问题的话,这肯定会是一个您关心的话题。

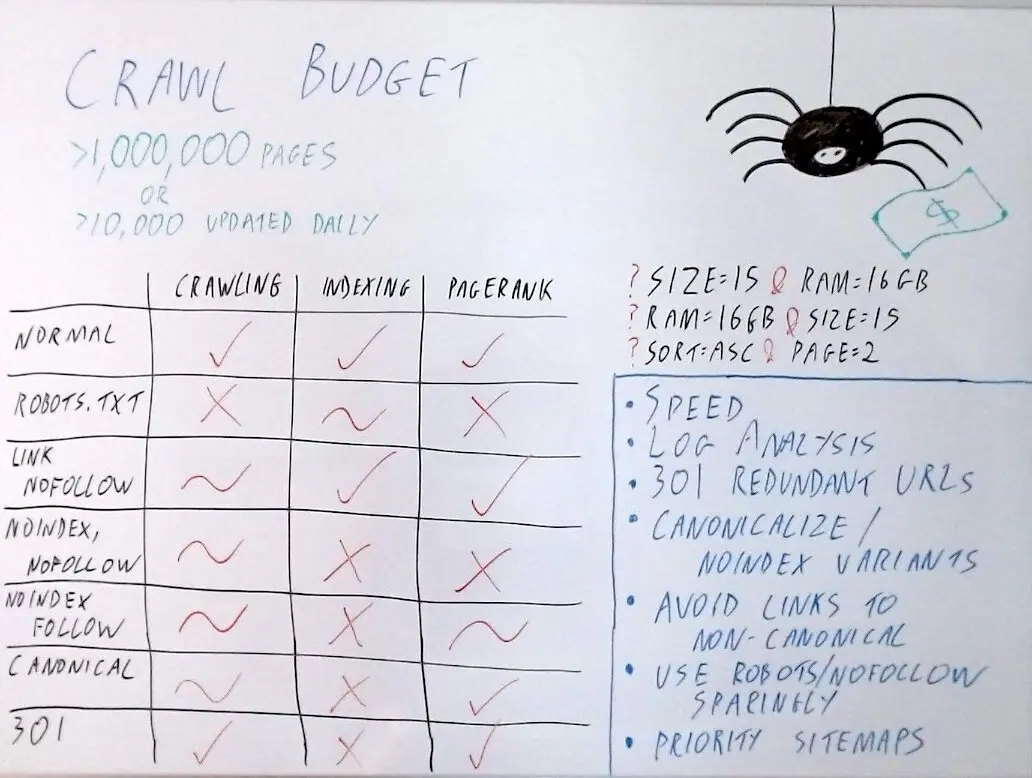

在谷歌自己的文档中,他们建议,如果您有超过一百万页或每天更新超过10,000多页,那么您应该关心一下爬取配额规划。又或者,网站上您想要的索引页面没有被索引,或者页面索引速度不够快时,那么在这些情况下,爬行预算都是您应该关心的问题。

什么是爬取配额规划?

那么,爬取配额规划到底是什么?爬取配额规划是指谷歌愿意花在指定网站上爬行的时间。虽然谷歌看起来强大,但他们的资源其实有限,而网络是巨大的。因此,他们必须以某种方式确定优先级,并分配一定时间或资源来抓取给定的网站。

现在,他们根据网站在用户间的受欢迎程度和网站内容的新鲜度进行优先排序,因为Google bot渴望新的、前所未有的URL。

爬取配额出现的原因

那么,爬行配额的问题实际上是怎么出现的呢?

分面

现在,我认为网站上可能导致爬行预算问题的主要问题首先是分面。

你可以想象在电子通信网站上有一个笔记本电脑页面。我们也许能够按大小过滤它。一个15英寸的屏幕和16G的RAM可能有很多不同的排列导致有非常多的URL,但实际上我们只有一页或一个类别——这只是个笔记本电脑页面。

同样,这些可以重新排序,以创建其他URL,这些URL执行完全相同的操作,但必须单独爬行。同样,它们可能会被不同的排序。可能会有分页等等。因此,您可以有一个类别页面生成大量URL。

搜索结果页面

其他会经常出现的事情来自内部网站搜索的搜索结果页面,特别是如果它们被分页就会生成许多不同的URL。

列表页面

列表页面。如果您允许用户上传自己的列表或内容,那么随着时间的推移,如果您制作招聘板或类似eBay的东西就会累积成大量URL,它可能会存在大量的页面。

修复爬行预算问题

您可以使用哪些工具来解决这些问题并充分利用您的爬行预算呢?

您可以使用哪些工具来解决这些问题并充分利用您的爬行预算呢?

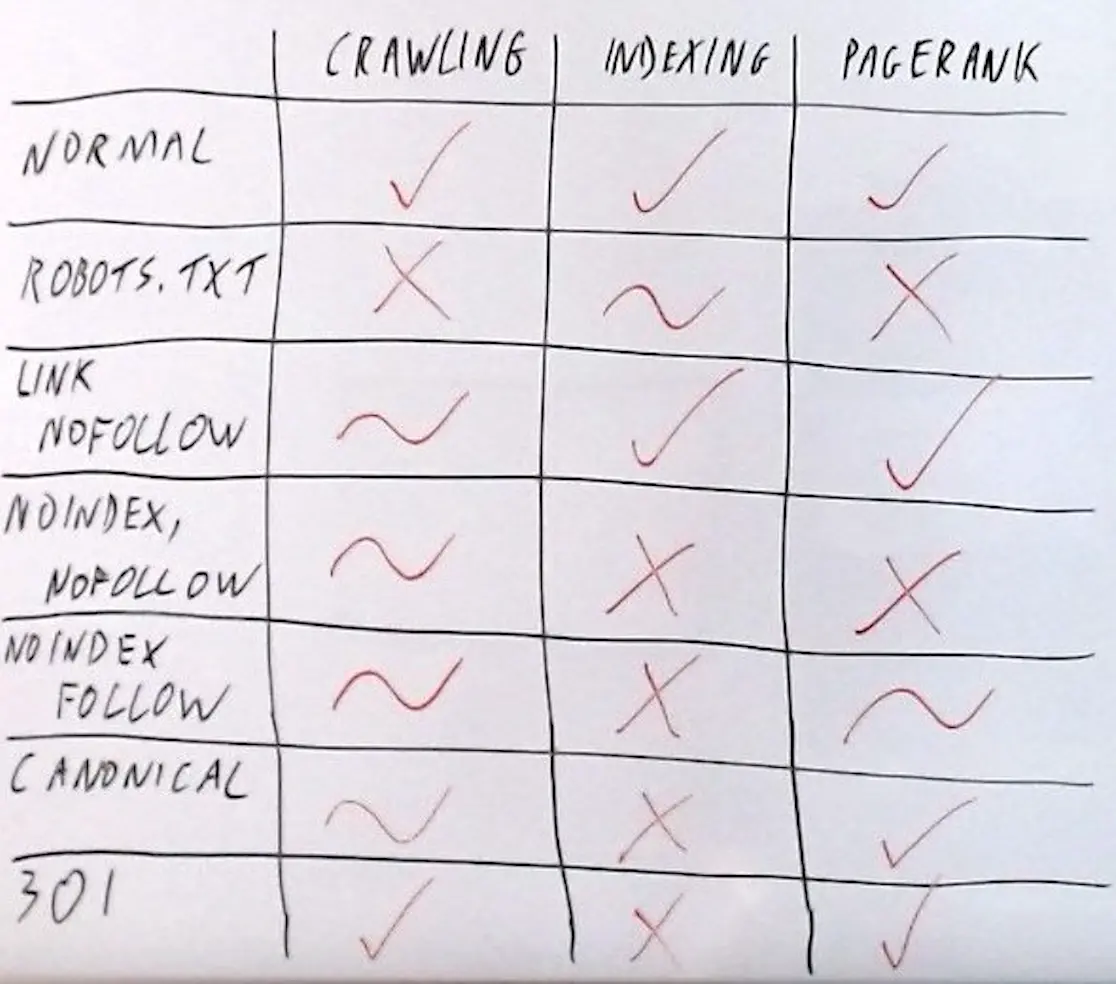

作为基准,如果我们考虑普通URL在Googlebot上的行为,一个链接可以被爬行、被索引,通过了PageRank的计算,而且,像这样的URL,也链接到我网站上的某个地方,然后谷歌关注该链接并索引这些页面,这些页面可能仍然有顶部导航和全网站导航。实际上传递到这些页面的链接的过程有点循环。当我们链接这么多不同的页面和这么多不同的过滤器时,网页权重就会带来一些损失。但最终我们其实在循环利用它,权重就会像黑洞似的损失。

Robots.txt

另一方面,您可以使用的爬行预算的最极端解决方案是利用robots.txt文件。

如果您在robots.txt中屏蔽页面,则无法爬行。那问题解决了!事实上没有。因为这里有一些妥协。从技术上讲,robots.txt中阻止的网站和页面可以进行索引。您有时会看到带有此元描述的SERP中显示的网站或页面无法显示,因为页面在robots.txt或此类消息中被阻止。

从技术上讲,他们可以被索引,但在功能上,它们不会对任何或至少任何有效的东西进行排名。从技术上讲。他们并没有通过PageRank。当我们链接到这样的页面时,我们仍在传递PageRank。但如果它随后被robots.txt阻止,PageRank就不再进一步了。

最终我们制造了漏洞。这是一个相当笨拙的解决方案,尽管它很容易实现。

链接级别nofollow

链接级别的nofollow,这里我的意思是,如果我们在笔记本电脑主类别页面上链接指向这些方面,并在这些链接上内部放置nofollow属性,这有利有弊。

我认为更好的用例实际上是在列表中。想象一下,如果我们运营一个二手车网站,在那里我们有数百万种不同的二手车个人产品列表。现在,我们真的不希望谷歌在这些单独的列表上浪费时间,这也许取决于我们网站的规模。

但偶尔知名人士可能会上传他们的汽车或类似的东西,我们不想在 robots.txt 中屏蔽该页面,因为在这种情况下会浪费这些外部链接。我们可能会做的是链接到该页面的内部链接上,在内部不跟随该链接。这意味着它可以爬行,但前提是当谷歌通过外部链接或类似的东西找到了它。

我们有一个折中办法。目前技术nofollow就是暗示。根据我的经验,谷歌不会抓取仅通过内部nofollow链接到的页面。如果它以其他方式找到页面,显然它仍然会爬行它。但总的来说这作为限制爬行配额的一种方式,可能是有效的。您通过这个nofollow链接丢失了一些PageRank。这仍然算作链接。

noindex,nofollow

noindex 和 nofollow无,这显然是电商网站上此类页面非常常见的解决方案。

在这种情况下,页面可以爬行。但一旦谷歌进入该页面,它将发现它是无索引的,随着时间的推移,它会更少地抓取它,因为爬行无索引页面的意义会降低。

显然,它无法索引。无索引不会向外传递PageRank。但PageRank仍然传递到此页面,由于有一个nofollow,它不会向外传递PageRank。这不是一个很好的解决方案。为了节省爬行配额,我们必须在这里达成一些妥协。

noindex,follow

过去许多人认为解决这个问题的办法是使用无索引但跟随作为两者的最佳选择。您在其中一个页面的顶部部分放置了一个无索引单跟随标签,我们每个人仍然从中获得同样的爬行好处。

几年前,谷歌公开表示:“我们自己没有意识到这一点,但实际上随着时间的推移,我们越来越少地爬行这个页面,会不再看到链接,然后它就不算数了。”因此,他们暗示这不再是一种仍然会传递PageRank的方式,最终它将被视为无索引和无关注。因此,我们再次得到了一种略微妥协的解决方案。

canonical 标签

canonical规范标签会被爬行,只是随着时间的推移会减少一点爬行。它仍然不会被索引,它仍然能传递PageRank。

这看起来很棒,在大多数情况下很完美。但只有当页面接近足够重复,以至于谷歌愿意将其视为重复并尊重规范时,这才有效。如果他们不愿意视它们是重复的,那么你可能不得不回到使用noindex。

301

我们可以将301作为一种方式,在节省爬行预算方面,这甚至比规范和无索引更好,因为谷歌甚至不必在少数的情况下查看页面,因为它只是遵循了301。这也解决我们的索引问题,并将传递PageRank。

实施爬行配额策略

综上所述,我们实际上将如何使用这些策略?

有一个不太直观的因素是速度。正如我之前所说,谷歌正在分配大量时间或资源来抓取给定的网站。因此,如果您的网站速度很快,服务器响应时间很短,或者如果您有轻量级HTML,它们会在相同的时间内浏览更多页面。

所以这个反常规的方法很不错。日志分析更传统一些。通常来说,您网站上的哪些页面或哪些参数实际上正在消耗您所有的爬行预算是不直观的。在大型网站上进行日志分析通常会产生令人惊讶的结果,所以你可以考虑这一点。然后实际使用其中一些工具。

冗余的URL我们认为用户甚至不需要查看,我们可以采用301。用户确实需要查看的变量,我们可以使用规范或无索引标签。但我们可能还希望从一开始就避免链接到它们,这样我们就不会稀释权重。

Robots.txt和nofollow是您需要非常谨慎使用的策略。事实证明,如果您的网站上有一个仅用于最近URL的网站地图,由于因为谷歌机器人非常渴望新鲜内容,他们会开始经常爬行此网站导航。因此,您可以使用这种策略将爬行预算导向新的URL。

Googlebot只想查看新的URL。您可能只想让Googlebot看到新的URL。因此,如果您有一个只用于此目的的网站地图,这可能是一个相当不错且易于实现的技巧。