Detalhes de Run:ai

Informação do Produto

Website

https://www.run.aiCategoria

Chatbot de conversaçãoLocalização

Nova York, NY, EUA Telavive, Israel

Descrição do Produto

Executar:ai Dev

Acelere o desenvolvimento da IA e o tempo de lançamento no mercado

- Inicie espaços de trabalho personalizados com suas ferramentas e estruturas favoritas.

- Enfileirar jobs em lote e executar treinamento distribuído com uma única linha de comando.

- Implante e gerencie seus modelos de inferência em um só lugar.

Ecossistema

Aumente a disponibilidade da GPU e multiplique o retorno do seu investimento em IA

- Cargas de trabalho

- Recursos

- Métricas

- Administrador

- Autenticação e Autorização

Executar:API ai

- Cargas de trabalho

- Recursos

- Métricas

- Administrador

- Autenticação e Autorização

Executar: Avião de Controle AI

Implante em sua própria infraestrutura; Nuvem. No local. Sem ar.

- Gerenciamento de vários clusters

- Painéis e relatórios

- Gerenciamento de carga de trabalho

- Política de acesso a recursos

- Política de carga de trabalho

- Autorização e controle de acesso

Executar:ai Cluster Engine

Conheça seu novo cluster de IA; Utilizado. Escalável. Sob controle.

- Agendador de carga de trabalho de IA

- Pooling de nós

- Orquestração de contêineres

- Fracionamento de GPU

- Nós GPU

- Nós da CPU

- Armazenamento

- Rede

CLI e GUI

Run:ai fornece uma interface de linha de comando (CLI) amigável e uma interface gráfica de usuário (GUI) abrangente para gerenciar suas cargas de trabalho e infraestrutura de IA. A CLI oferece recursos avançados de controle e script, enquanto a GUI fornece uma experiência visual intuitiva para monitorar, configurar e interagir com a plataforma.

Espaços de trabalho

Espaços de trabalho são ambientes isolados onde profissionais de IA podem trabalhar em seus projetos. Esses espaços de trabalho são pré-configurados com as ferramentas, bibliotecas e dependências necessárias, simplificando o processo de configuração e garantindo consistência entre as equipes. Os espaços de trabalho podem ser personalizados para atender aos requisitos específicos do projeto e podem ser facilmente clonados ou compartilhados com os colaboradores.

Ferramentas

Run:ai fornece um conjunto de ferramentas projetadas para aumentar a eficiência e a produtividade dos Desenvolvimento de IA. As ferramentas oferecem recursos como integração do Jupyter Notebook, visualização do TensorBoard e rastreamento de modelo. Essas ferramentas agilizam fluxos de trabalho, simplificam a análise de dados e melhoram a colaboração entre os membros da equipe.

Estruturas de código aberto

Run:ai oferece suporte a uma ampla variedade de estruturas de IA de código aberto populares, incluindo TensorFlow , PyTorch, JAX e Keras. Isso permite que os desenvolvedores aproveitem suas ferramentas e bibliotecas preferidas sem a necessidade de adaptar sua base de código existente a uma plataforma especializada.

Catálogo LLM

Run:ai oferece um Catálogo LLM, uma coleção com curadoria de populares Large Language Models (LLMs) e suas configurações correspondentes. Este catálogo facilita a implantação e a experimentação de LLMs de última geração, acelerando o desenvolvimento de aplicativos de IA que aproveitam recursos avançados de processamento de linguagem.

Cargas de trabalho

A execução: ai permite o gerenciamento eficaz de diversas cargas de trabalho de IA, incluindo:

* **Treinamento:** Run:ai otimiza trabalhos de treinamento distribuídos, permitindo treinar modelos de forma eficaz em grandes conjuntos de dados em várias GPUs.

* **Inferência:** Run:ai agiliza a implantação e a inferência de modelos, permitindo implantar modelos para previsões em tempo real ou processamento em lote.

* **Notebook Farms:** Run:ai suporta a criação e o gerenciamento de notebooks escalonáveis, fornecendo um ambiente colaborativo para exploração de dados e prototipagem de modelos.

* **Projetos de Pesquisa:** Run:ai foi desenvolvido para facilitar atividades de pesquisa, oferecendo uma plataforma para experimentação de novos modelos, algoritmos e técnicas.

Ativos

Run:ai permite que os usuários gerenciem e compartilhem ativos de IA, incluindo:

* **Modelos:** armazene e versione modelos treinados para fácil acesso e implantação.

* **Conjuntos de dados:** armazene e gerencie grandes conjuntos de dados para uso eficiente em trabalhos de treinamento.

* **Código:** Compartilhe e colabore em códigos relacionados a projetos de IA.

* **Experimentos:** Acompanhe e compare os resultados de diferentes experimentos de IA.

Métricas

Run:ai fornece recursos abrangentes de monitoramento e relatórios, permitindo que os usuários rastreiem as principais métricas relacionadas às suas cargas de trabalho e infraestrutura de IA. Isso inclui:

* **Utilização de GPU:** monitore a utilização de GPUs em todo o cluster, garantindo uma alocação eficiente de recursos.

* **Desempenho da carga de trabalho:** Acompanhe o desempenho dos trabalhos de treinamento e inferência, identificando gargalos e oportunidades de otimização.

* **Consumo de recursos:** Monitore o uso de CPU, memória e rede, fornecendo insights sobre a utilização de recursos e possíveis estratégias de otimização.

Admin

Run:ai oferece ferramentas administrativas para gerenciar a plataforma e seus usuários, incluindo:

* **Gerenciamento de usuários:** Controlar direitos e permissões de acesso para diferentes usuários ou grupos.

* **Configuração de cluster:** Configure os recursos de hardware e software no cluster de IA.

* **Aplicação de políticas:** Definir e aplicar políticas de alocação de recursos para garantir justiça e eficiência.

Autenticação e Autorização

Run:ai fornece mecanismos seguros de autenticação e autorização para controlar o acesso a recursos e dados confidenciais. Isso inclui:

* **Logon único (SSO):** Integração com provedores de identidade existentes para autenticação de usuário perfeita.

* **Controle de acesso baseado em funções (RBAC):** Defina funções com permissões específicas, garantindo controle granular sobre o acesso aos recursos.

* **Autenticação multifator (MFA):** Aumente a segurança exigindo vários fatores para login do usuário.

Gerenciamento de vários clusters

Run:ai permite o gerenciamento de vários clusters de IA a partir de um plano de controle central. Isso permite que as organizações:

* **Consolidar recursos:** Agregar recursos em diferentes clusters, fornecendo uma visão unificada da capacidade disponível.

* **Padronize fluxos de trabalho:** aplique políticas e configurações consistentes em vários clusters.

* **Otimize a utilização:** equilibre a distribuição da carga de trabalho entre clusters para obter a alocação ideal de recursos.

Painéis e relatórios

Run:ai fornece painéis poderosos e ferramentas de relatórios para visualizar as principais métricas, monitorar o desempenho da carga de trabalho e obter insights sobre a utilização de recursos. Esses recursos incluem:

* **Monitoramento em tempo real:** rastreie a utilização da GPU, o progresso da carga de trabalho e o uso de recursos em tempo real.

* **Análise histórica:** analise dados históricos para identificar tendências, otimizar a alocação de recursos e melhorar o desempenho da carga de trabalho.

* **Painéis personalizáveis:** Crie painéis personalizados adaptados a necessidades e perspectivas específicas.

Gerenciamento de carga de trabalho

Run:ai simplifica o gerenciamento de cargas de trabalho de IA, incluindo:

* **Agendamento:** automatiza o agendamento e a execução de trabalhos de treinamento e inferência.

* **Priorização:** atribua prioridades às cargas de trabalho para garantir que as tarefas críticas sejam concluídas primeiro.

* **Alocação de recursos:** Aloque recursos (GPUs, CPUs, memória) para cargas de trabalho com base em suas necessidades e prioridades.

Política de acesso a recursos

Run:ai oferece um mecanismo flexível de política de acesso a recursos que permite que as organizações definam e apliquem regras que regem como os usuários podem acessar e utilizar os recursos do cluster. Isso permite:

* **Alocação de compartilhamento justo:** Garanta que os recursos sejam alocados de forma justa entre usuários e equipes.

* **Gerenciamento de cotas:** defina limites de uso de recursos para evitar o consumo excessivo e garantir uma alocação eficiente.

* **Aplicação de prioridade:** Priorize o acesso aos recursos com base nas funções do usuário ou na importância da carga de trabalho.

Política de carga de trabalho

Run:ai oferece suporte à criação de políticas de carga de trabalho, definindo regras e diretrizes para gerenciar cargas de trabalho de IA. Isso permite que as organizações:

* **Padronizem fluxos de trabalho:** estabeleçam fluxos de trabalho consistentes e práticas recomendadas para executar cargas de trabalho de IA.

* **Automatize tarefas:** automatize operações comuns de gerenciamento de carga de trabalho, como alocação e agendamento de recursos.

* **Melhore a segurança:** Aplique políticas para garantir a conformidade com padrões e regulamentações de segurança.

Autorização e controle de acesso

Run:ai emprega mecanismos robustos de autorização e controle de acesso para proteger o acesso a recursos e dados, incluindo:

* **Permissões refinadas:* * Conceda permissões específicas a usuários ou grupos, fornecendo controle granular sobre o acesso aos recursos.

* **Auditoria e registro:** Rastreie as ações do usuário e os padrões de acesso, fornecendo uma trilha de auditoria para fins de segurança e conformidade.

* **Integração com ferramentas de segurança existentes:** Integre o Run:ai com sistemas de segurança existentes para gerenciamento e controle centralizados.

AI Workload Scheduler

O AI Workload Scheduler da Run:ai foi projetado especificamente para otimizar o gerenciamento de recursos para todo o ciclo de vida da IA, permitindo que você:

* **Programação dinâmica:* * Aloque recursos dinamicamente para cargas de trabalho com base nas necessidades e prioridades atuais.

* **Pooling de GPU:** consolide os recursos de GPU em pools, permitindo a alocação flexível para diversas cargas de trabalho.

* **Programação prioritária:** Garanta que tarefas críticas recebam recursos primeiro, otimizando o rendimento geral do cluster de IA.

Node Pooling

Run:ai apresenta o conceito de Node Pooling, permitindo que as organizações gerenciem clusters de IA heterogêneos com facilidade. Este recurso fornece:

* **Configuração de cluster:** define cotas, prioridades e políticas no nível do pool de nós para gerenciar a alocação de recursos.

* **Gerenciamento de recursos:** garanta a alocação justa e eficiente de recursos dentro do cluster, considerando fatores como tipo de GPU, memória e núcleos de CPU.

* **Distribuição de carga de trabalho:** aloque cargas de trabalho para pools de nós apropriados com base em seus requisitos de recursos.

Container Orchestration

Run:ai integra-se perfeitamente com plataformas de orquestração de contêineres, como Kubernetes, permitindo a implantação e o gerenciamento de cargas de trabalho de IA em contêineres distribuídas. Isso fornece:

* **Escalonamento automatizado:** Aumente ou diminua as cargas de trabalho de IA de maneira contínua com base na demanda.

* **Alta disponibilidade:** Garanta que as cargas de trabalho de IA permaneçam disponíveis mesmo se nós individuais falharem.

* **Implantação simplificada:** implante e gerencie cargas de trabalho de IA usando imagens em contêineres, promovendo portabilidade e reprodutibilidade.

GPU Fractioning

A tecnologia GPU Fractioning da Run:ai permite dividir uma única GPU em múltiplas frações, fornecendo uma maneira econômica de executar cargas de trabalho que exigem apenas uma parte de uma GPU. recursos. Este recurso:

* **Aumenta a eficiência de custos:** permite executar mais cargas de trabalho na mesma infraestrutura compartilhando recursos de GPU.

* **Simplifica o gerenciamento de recursos:** Simplifica a alocação de recursos de GPU para diversas cargas de trabalho com requisitos variados.

* **Melhora a utilização:** Maximiza a utilização das GPUs, reduzindo o tempo ocioso e aumentando a eficiência.

Nós de GPU

Run:ai oferece suporte a uma ampla variedade de nós de GPU dos principais fornecedores, incluindo NVIDIA, AMD e Intel. Isso garante compatibilidade com uma variedade de configurações de hardware e permite que as organizações utilizem a infraestrutura existente ou selecionem as GPUs mais adequadas para suas necessidades específicas.

Nós de CPU

Além dos nós de GPU, Run :ai também oferece suporte a nós de CPU para tarefas que não requerem aceleração de GPU. Isso permite que as organizações aproveitem a infraestrutura de CPU existente ou utilizem recursos de CPU mais econômicos para tarefas específicas.

Armazenamento

Run:ai integra-se a várias soluções de armazenamento, incluindo NFS, GlusterFS, ceph e discos locais. Essa flexibilidade permite que as organizações escolham uma solução de armazenamento que melhor atenda aos seus requisitos de desempenho, escalabilidade e custos.

Rede

Run:ai foi projetado para funcionar de forma eficiente em redes de alta largura de banda, permitindo a transmissão eficiente de dados entre nós e a execução de cargas de trabalho de IA distribuídas. Run:ai também pode ser implantado em ambientes isolados, onde não há conectividade com a Internet, garantindo a segurança e o isolamento de dados confidenciais.

Notebooks on Demand

Run:ai's Notebooks O recurso on Demand permite que os usuários iniciem espaços de trabalho pré-configurados com suas ferramentas e estruturas favoritas, incluindo Jupyter Notebook, PyCharm e VS Code. Isto:

* **Simplifica a configuração:** Inicie espaços de trabalho rapidamente sem a necessidade de instalar dependências manualmente.

* **Garante consistência:** Fornece ambientes consistentes entre equipes e projetos.

* **Melhora a colaboração:** compartilhe e colabore em espaços de trabalho de forma integrada com os membros da equipe.

Treinamento e ajuste fino

Run:ai simplifica o processo de treinamento e ajuste fino de modelos de IA:

* **Enfileirar trabalhos em lote:** Agendar e executar em lote trabalhos de treinamento com uma única linha de comando.

* **Treinamento distribuído:** treine modelos de maneira eficaz em grandes conjuntos de dados em várias GPUs.

* **Otimização do modelo:** otimize parâmetros e hiperparâmetros de treinamento para melhorar o desempenho.

LLMs privados

Run:ai permite que os usuários implantem e gerenciem seus próprios LLMs privados, modelos treinados de forma personalizada que podem ser usados para aplicações específicas. Isso permite:

* **Implantação de modelo:** implantar modelos LLM para inferência e gerar respostas personalizadas.

* **Gerenciamento de modelos:** armazene, versione e gerencie modelos LLM para fácil acesso e atualizações.

* **Privacidade de dados:** Mantenha os dados do usuário confidenciais e seguros dentro da infraestrutura da organização.

NVIDIA e pacote Run:ai

Run:ai e NVIDIA formaram uma parceria para oferecer uma solução totalmente integrada para sistemas DGX, fornecendo a solução full-stack de melhor desempenho para cargas de trabalho de IA. Este pacote:

* **Otimiza o desempenho do DGX:** Aproveita os recursos do Run:ai para maximizar a utilização e o desempenho do hardware DGX.

* **Simplifica o gerenciamento:** Fornece uma plataforma única para gerenciar recursos DGX e cargas de trabalho de IA.

* **Acelera o desenvolvimento de IA:** capacita as organizações a acelerarem suas iniciativas de IA com uma solução coesa.

Implante em sua própria infraestrutura; Nuvem. No local. Air-Gapped.

Run:ai oferece suporte a uma ampla variedade de ambientes de implantação, oferecendo opções flexíveis para organizações com diferentes requisitos de infraestrutura. Isso inclui:

* **Implantações em nuvem:** Implante o Run:ai nos principais provedores de nuvem, como AWS, Azure e Google Cloud, permitindo que você aproveite seus serviços e recursos.

* **Implantações locais:** implante o Run:ai em sua própria infraestrutura de hardware, fornecendo controle completo sobre seu ambiente de IA.

* **Implantações air-gapped:** Implante o Run:ai em ambientes isolados sem conectividade com a Internet, garantindo a segurança e a integridade dos seus dados.

Qualquer ferramenta e estrutura de ML

Run:ai foi projetado para funcionar com uma ampla variedade de ferramentas e estruturas de aprendizado de máquina, incluindo:

* **TensorFlow:** Run e gerencie cargas de trabalho do TensorFlow de maneira eficaz.

* **PyTorch:** implante e otimize modelos PyTorch para treinamento e inferência.

* **JAX:** Utilize JAX para cálculos de IA de alto desempenho.

* **Keras:** Crie e treine modelos Keras perfeitamente.

* **Scikit-learn:** Utilize o Scikit-learn para tarefas de aprendizado de máquina.

* **XGBoost:** Aproveite o XGBoost para algoritmos de aumento de gradiente.

* **LightGBM:** implemente o LightGBM para um aumento de gradiente eficiente.

* **CatBoost:** Utilize CatBoost para um aumento robusto de gradiente.

Qualquer Kubernetes

Run:ai integra-se perfeitamente ao Kubernetes, a plataforma líder de orquestração de contêineres. Isso garante compatibilidade com ambientes Kubernetes existentes e permite que as organizações aproveitem seus benefícios, incluindo:

* **Escalonamento automatizado:** dimensione cargas de trabalho de IA dinamicamente com base na demanda.

* **Alta disponibilidade:** Garanta que as cargas de trabalho de IA permaneçam disponíveis mesmo se nós individuais falharem.

* **Implantações em contêineres:** implante cargas de trabalho de IA como contêineres, promovendo portabilidade e reprodutibilidade.

Em qualquer lugar

O Run:ai foi projetado para ser implantado em qualquer lugar, proporcionando flexibilidade para organizações com diversas necessidades de infraestrutura. Isso inclui:

* **Data centers:** Implante o Run:ai em seus próprios data centers para obter máximo controle e segurança.

* **Provedores de nuvem:** Implemente o Run:ai nos principais provedores de nuvem para obter escalabilidade e flexibilidade.

* **Dispositivos de borda:** implante o Run:ai em dispositivos de borda para aplicações de IA em tempo real.

Qualquer infraestrutura

Run:ai oferece suporte a uma ampla variedade de componentes de infraestrutura, permitindo que você crie seu ambiente de IA ideal:

* **GPUs:** Aproveite o alto desempenho GPUs dos principais fornecedores, como NVIDIA, AMD e Intel.

* **CPUs:** utilize CPUs para tarefas que não exigem aceleração de GPU.

* **ASICs:** integra ASICs para tarefas especializadas, como inferência de aprendizado de máquina.

* **Armazenamento:** escolha soluções de armazenamento que melhor atendam aos seus requisitos de desempenho, escalabilidade e custo.

* **Rede:** implante o Run:ai em redes de alta largura de banda para transmissão de dados eficiente e cargas de trabalho distribuídas.

FAQFAQ

// * **Cloud:** Run:ai pode ser implantado em qualquer grande provedor de nuvem, incluindo AWS, Azure e GCP.

// * **On-Prem:** Run:ai também pode ser implantado no local, o que permite que as organizações mantenham seus dados e cargas de trabalho seguros em seus próprios data centers.

// * **Air-gapped:** Run:ai também pode ser implantado em ambientes air-gapped, que são ambientes que não estão conectados à Internet. Isso permite que as organizações implantem cargas de trabalho de IA em ambientes onde há requisitos rígidos de segurança.//

// * **Inferência:** Run: ai pode ser usado para executar cargas de trabalho de inferência em GPUs, o que pode ajudar a melhorar o desempenho de aplicativos de IA.//

// * **Pesquisa e desenvolvimento:** Run:ai pode ser usado para apoiar esforços de pesquisa e desenvolvimento fornecendo uma plataforma poderosa para gerenciar e implantar cargas de trabalho de IA.//

// * **Aprendizado profundo:** Run:ai pode ser usado para treinar e implantar modelos de aprendizado profundo, que estão se tornando cada vez mais populares para uma ampla gama de aplicativos.//

//

Para mais informações, entre em contato com nossa equipe [email protected] Teremos prazer em responder suas perguntas e ajudá-lo a obter começou com Executar:ai.//

Tráfego do Site

Sem Dados

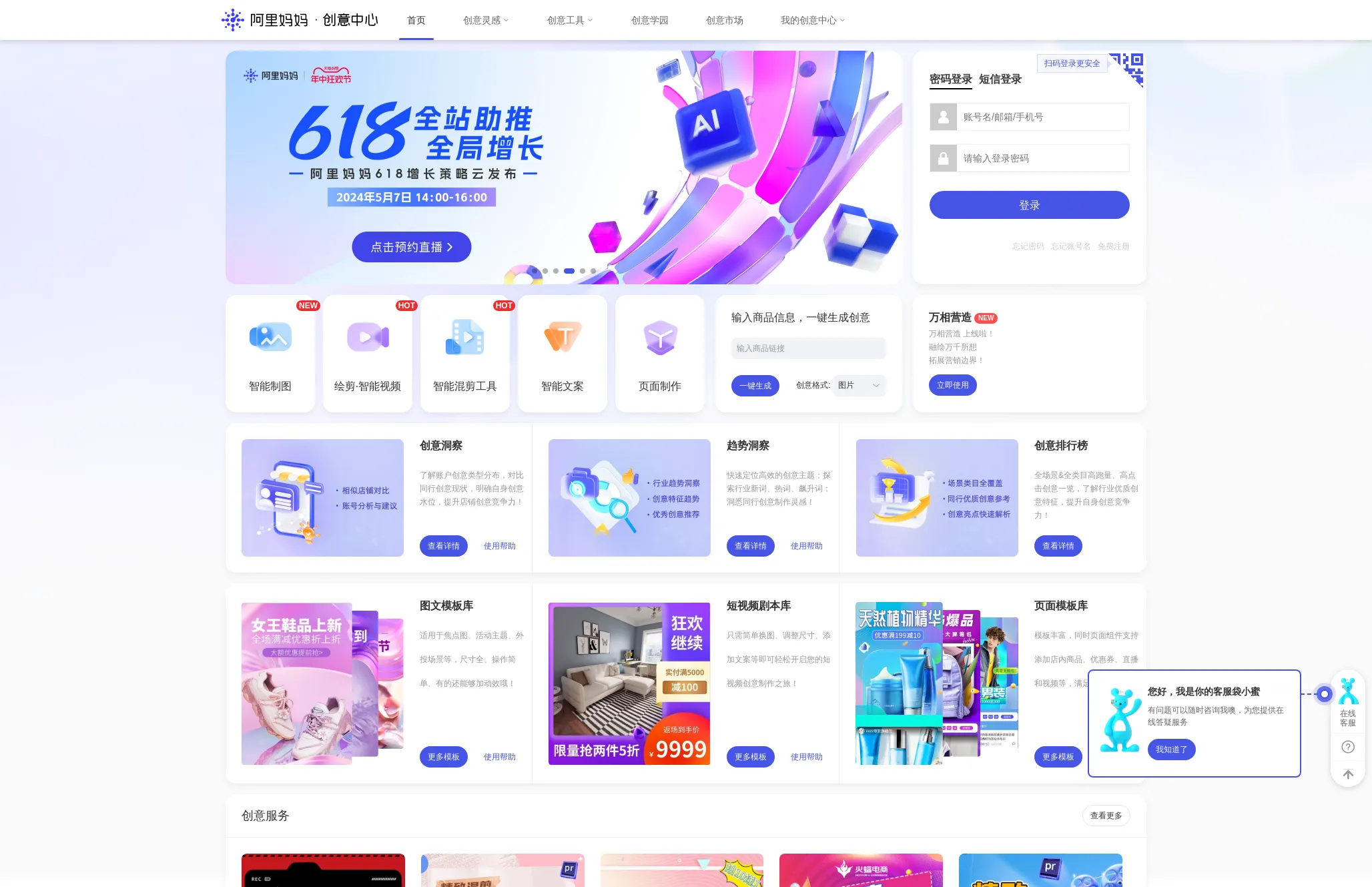

Produtos Alternativos

Alimama Creative

Assistência de design

Alimama Creative Center - Capacitando sua criatividade de marketing

绘AI

Geração de imagens

Ai Drawing

AI Art

Geração de imagens

Plataforma de criação gráfica AI

Stockimg AI

Geração de imagens

Pare de perder tempo com produção de conteúdo. Experimente gratuitamente agora mesmo e gerencie suas mídias sociais com IA!

6pen Art

Geração de imagens

Transforme sua imaginação em arte

MoDao AI

Assistência de design

Mockingbot AI: Duplique sua eficiência de prototipagem