Run:ai Detaljer

Produktinformasjon

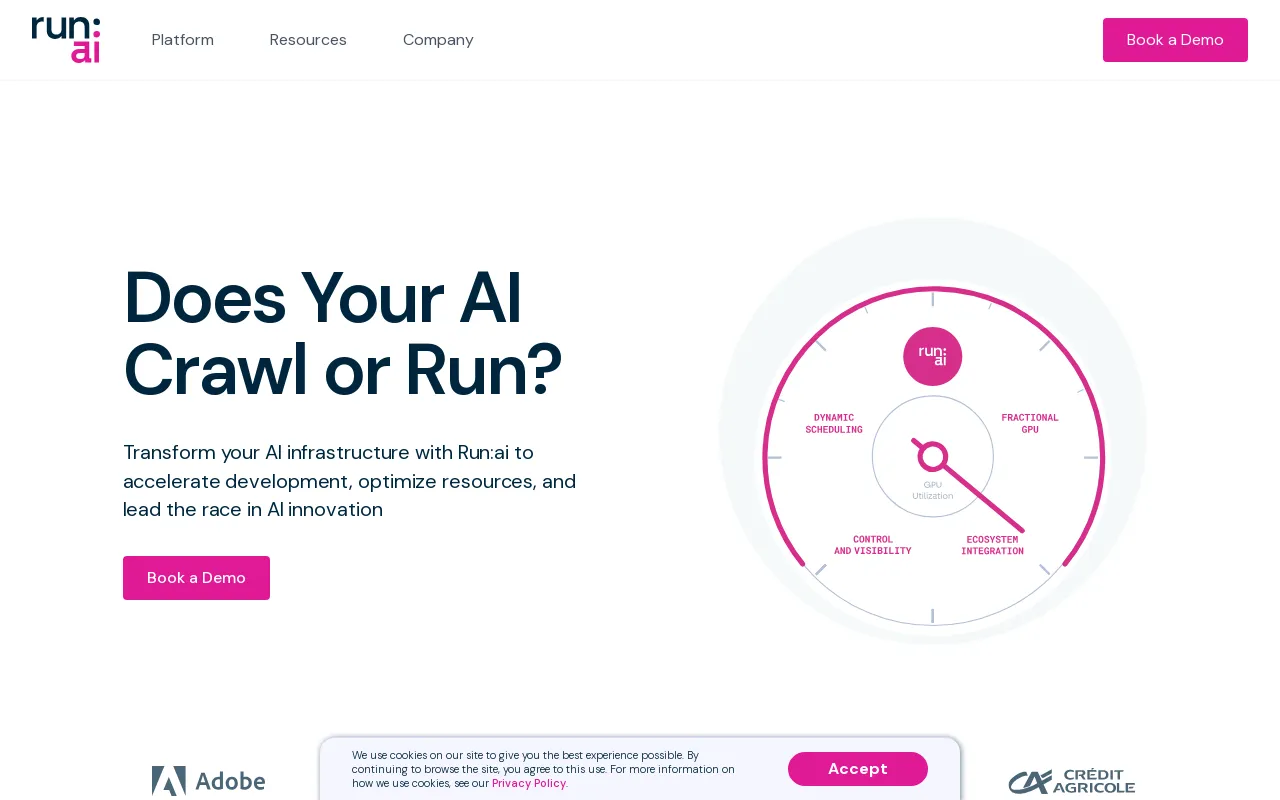

Produktbeskrivelse

Kjør:ai Dev

Fremskynd AI-utvikling og time-to-market

- Lanser tilpassede arbeidsområder med favorittverktøyene og -rammeverket.

- Sett batchjobber i kø og kjør distribuert opplæring med én enkelt kommandolinje.

- Distribuer og administrer slutningsmodellene dine fra ett sted.

Økosystem

Øk GPU-tilgjengeligheten og multipliser avkastningen på AI-investeringen din

- Arbeidsbelastning

- Eiendeler

- Beregninger

- Administrator

- Autentisering og autorisasjon

Kjør:ai API

- Arbeidsbelastning

- Eiendeler

- Beregninger

- Administrator

- Autentisering og autorisasjon

Kjør:ai kontrollplan

Distribuer på din egen infrastruktur; Sky. On-Prem. Air-Gapped.

- Multi-Cluster Management

- Dashboards og rapportering

- Administrasjon av arbeidsbelastning

- Retningslinjer for ressurstilgang

- Retningslinjer for arbeidsbelastning

- Autorisasjon og tilgangskontroll

Kjør:ai Cluster Engine

Møt din nye AI-klynge; Utnyttet. Skalerbar. Under kontroll.

- AI Workload Scheduler

- Nodepooling

- Beholderorkestering

- GPU-fraksjonering

- GPU-noder

- CPU-noder

- Lagring

- Nettverk

CLI & GUI

Run:ai gir et brukervennlig kommandolinjegrensesnitt (CLI) og et omfattende grafisk brukergrensesnitt (GUI) for administrasjon av AI-arbeidsbelastninger og infrastruktur. CLI tilbyr avanserte kontroll- og skriptfunksjoner, mens GUI gir en intuitiv visuell opplevelse for overvåking, konfigurering og interaksjon med plattformen.

Arbeidsområder

Arbeidsområder er isolerte miljøer der AI-utøvere kan jobbe med sine prosjekter. Disse arbeidsområdene er forhåndskonfigurert med nødvendige verktøy, biblioteker og avhengigheter, noe som forenkler oppsettprosessen og sikrer konsistens på tvers av team. Arbeidsområder kan tilpasses for å møte spesifikke prosjektkrav og kan enkelt klones eller deles med samarbeidspartnere.

Verktøy

Run:ai tilbyr en pakke med verktøy utviklet for å øke effektiviteten og produktiviteten til AI utvikling. Verktøyene tilbyr funksjoner som Jupyter Notebook-integrasjon, TensorBoard-visualisering og modellsporing. Disse verktøyene strømlinjeformer arbeidsflytene, forenkler dataanalysen og forbedrer samarbeidet mellom teammedlemmer.

Open Source Frameworks

Run:ai støtter et bredt spekter av populære åpen kildekode AI-rammeverk, inkludert TensorFlow , PyTorch, JAX og Keras. Dette lar utviklere utnytte sine foretrukne verktøy og biblioteker uten å måtte tilpasse sin eksisterende kodebase til en spesialisert plattform.

LLM Catalog

Run:ai tilbyr en LLM Catalog, en kuratert samling av populære store språkmodeller (LLM) og deres tilsvarende konfigurasjoner. Denne katalogen gjør det enklere å distribuere og eksperimentere med toppmoderne LLM-er, og akselererer utviklingen av AI-applikasjoner som utnytter avanserte språkbehandlingsevner.

Arbeidsbelastninger

The Run: ai-plattformen tillater effektiv administrasjon av ulike AI-arbeidsbelastninger, inkludert:

* **Opplæring:** Run:ai optimerer distribuerte treningsjobber, slik at du effektivt kan trene modeller på store datasett på tvers av flere GPUer.

* **Inferens:** Run:ai strømlinjeformer modelldistribusjon og inferens, slik at du kan distribuere modeller for sanntidsprediksjoner eller batchbehandling.

* **Notebook Farms:** Run:ai støtter oppretting og administrasjon av skalerbare notebookfarmer, og gir et samarbeidsmiljø for datautforskning og modellprototyping.

* **Forskningsprosjekter:** Run:ai er designet for å lette forskningsaktiviteter, og tilbyr en plattform for eksperimentering med nye modeller, algoritmer og teknikker.

Eiendeler

Run:ai lar brukere administrere og dele AI-ressurser, inkludert:

* **Modeller:** Lagre og versjonstrene modeller for enkel tilgang og distribusjon.

* **Datasett:** Lagre og administrer store datasett for effektiv bruk i opplæringsjobber.

* **Kode:** Del og samarbeid om kode relatert til AI-prosjekter.

* **Eksperimenter:** Spor og sammenlign resultatene fra forskjellige AI-eksperimenter.

Beregninger

Run:ai gir omfattende overvåkings- og rapporteringsfunksjoner, slik at brukere kan spore nøkkelberegninger knyttet til deres AI-arbeidsbelastninger og infrastruktur. Dette inkluderer:

* **GPU-bruk:** Overvåk bruken av GPUer på tvers av klyngen, og sikrer effektiv ressursallokering.

* **Arbeidsbelastningsytelse:** Spor ytelsen til trenings- og slutningsjobber, identifiser flaskehalser og muligheter for optimalisering.

* **Ressursforbruk:** Overvåk CPU-, minne- og nettverksbruk, og gir innsikt i ressursutnyttelse og potensielle optimaliseringsstrategier.

Admin

Run:ai tilbyr administrative verktøy for å administrere plattformen og dens brukere, inkludert:

* **Brukeradministrasjon:** Kontroller tilgangsrettigheter og tillatelser for forskjellige brukere eller grupper.

* **Klyngekonfigurasjon:** Konfigurer maskinvare- og programvareressursene i AI-klyngen.

* **Handhevelse av retningslinjer:** Definer og håndhev retningslinjer for ressursallokering for å sikre rettferdighet og effektivitet.

Autentisering og autorisasjon

Run:ai gir sikre autentiserings- og autorisasjonsmekanismer for å kontrollere tilgang til ressurser og sensitive data. Dette inkluderer:

* **Enkeltpålogging (SSO):** Integrer med eksisterende identitetsleverandører for sømløs brukerautentisering.

* **Rollebasert tilgangskontroll (RBAC):** Definer roller med spesifikke tillatelser, og sikrer detaljert kontroll over tilgang til ressurser.

* **Multi-faktor autentisering (MFA):** Forbedre sikkerheten ved å kreve flere faktorer for brukerpålogging.

Multi-Cluster Management

Run:ai gjør det mulig å administrere flere AI-klynger fra et sentralt kontrollplan. Dette tillater organisasjoner å:

* **Konsolidere ressurser:** Samle ressurser på tvers av ulike klynger, og gir en enhetlig oversikt over tilgjengelig kapasitet.

* **Standardiser arbeidsflyter:** Bruk konsistente retningslinjer og konfigurasjoner på tvers av flere klynger.

* **Optimaliser bruken:** Balanser arbeidsbelastningsfordeling på tvers av klynger for optimal ressursallokering.

Dashboards og rapportering

Run:ai gir kraftige instrumentbord og rapporteringsverktøy for å visualisere nøkkelberegninger, spore arbeidsbelastningsytelse og få innsikt i ressursutnyttelse. Disse egenskapene inkluderer:

* **Sanntidsovervåking:** Spor GPU-bruk, arbeidsbelastningsfremgang og ressursbruk i sanntid.

* **Historisk analyse:** Analyser historiske data for å identifisere trender, optimalisere ressursallokering og forbedre arbeidsbelastningsytelsen.

* **Tilpassbare dashboards:** Lag tilpassede dashboards skreddersydd for spesifikke behov og perspektiver.

Workload Management

Run:ai forenkler administrasjonen av AI-arbeidsbelastninger, inkludert:

* **Planlegging:** Automatiser planlegging og utførelse av opplærings- og inferensjobber.

* **Prioritering:** Tilordne prioriteringer til arbeidsbelastninger for å sikre at kritiske oppgaver fullføres først.

* **Ressursallokering:** Tildel ressurser (GPUer, CPUer, minne) til arbeidsbelastninger basert på deres behov og prioriteringer.

Retningslinjer for ressurstilgang

Run:ai tilbyr en fleksibel policymotor for ressurstilgang som lar organisasjoner definere og håndheve regler som styrer hvordan brukere kan få tilgang til og bruke klyngeressurser. Dette muliggjør:

* **Fair-share allokering:** Sikre at ressursene fordeles rettferdig mellom brukere og team.

* **Kvotestyring:** Sett grenser for ressursbruk for å forhindre overforbruk og sikre effektiv fordeling.

* **Prioritetshåndhevelse:** Prioriter tilgang til ressurser basert på brukerroller eller arbeidsbelastning.

Arbeidsbelastningspolicy

Run:ai støtter oppretting av arbeidsbelastningspolicyer, definerer regler og retningslinjer for administrasjon av AI-arbeidsbelastninger. Dette gjør organisasjoner i stand til å:

* **Standardisere arbeidsflyter:** Etablere konsistente arbeidsflyter og beste praksis for å kjøre AI-arbeidsbelastninger.

* **Automatiser oppgaver:** Automatiser vanlige arbeidsbelastningsadministrasjonsoperasjoner, for eksempel ressursallokering og planlegging.

* **Forbedre sikkerheten:** Håndheve retningslinjer for å sikre samsvar med sikkerhetsstandarder og forskrifter.

Autorisasjon og tilgangskontroll

Run:ai bruker robuste autorisasjons- og tilgangskontrollmekanismer for å sikre tilgang til ressurser og data, inkludert:

* **Finkorrekte tillatelser:* * Gi spesifikke tillatelser til brukere eller grupper, og gir detaljert kontroll over tilgang til ressurser.

* **Revisjon og logging:** Spor brukerhandlinger og tilgangsmønstre, og gir et revisjonsspor for sikkerhets- og samsvarsformål.

* **Integrasjon med eksisterende sikkerhetsverktøy:** Integrer Run:ai med eksisterende sikkerhetssystemer for sentralisert administrasjon og kontroll.

AI Workload Scheduler

Run:ai sin AI Workload Scheduler er spesielt utviklet for å optimalisere ressursadministrasjon for hele AI-livssyklusen, slik at du kan:

* **Dynamisk planlegging:* * Dynamisk allokere ressurser til arbeidsbelastninger basert på nåværende behov og prioriteringer.

* **GPU-pooling:** Konsolider GPU-ressurser i bassenger, slik at du får fleksibel allokering til ulike arbeidsbelastninger.

* **Prioritetsplanlegging:** Sørg for at kritiske oppgaver blir tildelt ressurser først, og optimaliserer den totale gjennomstrømningen til AI-klyngen.

Node Pooling

Run:ai introduserer konseptet Node Pooling, som lar organisasjoner administrere heterogene AI-klynger med letthet. Denne funksjonen gir:

* **Klyngekonfigurasjon:** Definer kvoter, prioriteringer og policyer på Node Pool-nivå for å administrere ressursallokering.

* **Ressursadministrasjon:** Sikre rettferdig og effektiv allokering av ressurser i klyngen, med tanke på faktorer som GPU-type, minne og CPU-kjerner.

* **Fordeling av arbeidsbelastning:** Tildel arbeidsbelastninger til passende nodepooler basert på ressurskravene deres.

Container Orchestration

Run:ai integreres sømløst med containerorkestreringsplattformer som Kubernetes, og muliggjør distribusjon og administrasjon av distribuerte containeriserte AI-arbeidsmengder. Dette gir:

* **Automatisk skalering:** Skaler AI-arbeidsbelastninger opp eller ned sømløst basert på etterspørsel.

* **Høy tilgjengelighet:** Sørg for at AI-arbeidsbelastninger forblir tilgjengelige selv om individuelle noder svikter.

* **Forenklet distribusjon:** Distribuer og administrer AI-arbeidsbelastninger ved å bruke containeriserte bilder, fremme portabilitet og reproduserbarhet.

GPU-fraksjonering

Run:ai sin GPU-fraksjoneringsteknologi lar deg dele en enkelt GPU i flere fraksjoner, og gir en kostnadseffektiv måte å kjøre arbeidsbelastninger som krever bare en del av en GPU-er ressurser. Denne funksjonen:

* **Øker kostnadseffektiviteten:** Lar deg kjøre flere arbeidsbelastninger på samme infrastruktur ved å dele GPU-ressurser.

* **Forenkler ressursadministrasjon:** Effektiviserer allokeringen av GPU-ressurser til ulike arbeidsbelastninger med varierende krav.

* **Forbedrer utnyttelsen:** Maksimerer utnyttelsen av GPUer, reduserer inaktiv tid og øker effektiviteten.

GPU-noder

Run:ai støtter et bredt utvalg av GPU-noder fra ledende leverandører, inkludert NVIDIA, AMD og Intel. Dette sikrer kompatibilitet med en rekke maskinvarekonfigurasjoner og lar organisasjoner bruke eksisterende infrastruktur eller velge de best egnede GPU-ene for deres spesifikke behov.

CPU-noder

I tillegg til GPU-noder, Kjør :ai støtter også CPU-noder for oppgaver som ikke krever GPU-akselerasjon. Dette lar organisasjoner utnytte eksisterende CPU-infrastruktur eller bruke mer kostnadseffektive CPU-ressurser for spesifikke oppgaver.

Lagring

Run:ai integreres med ulike lagringsløsninger, inkludert NFS, GlusterFS, ceph , og lokale disker. Denne fleksibiliteten gjør at organisasjoner kan velge en lagringsløsning som best oppfyller deres ytelses-, skalerbarhets- og kostnadskrav.

Nettverk

Run:ai er designet for å fungere effektivt på nettverk med høy båndbredde, muliggjør effektiv overføring av data mellom noder og utførelse av distribuerte AI-arbeidsbelastninger. Run:ai kan også distribueres i miljøer med lufthull, der det ikke er internettforbindelse, noe som sikrer sikkerhet og isolering av sensitive data.

Notatbøker på forespørsel

Run:ai's Notebooks on Demand-funksjonen lar brukere starte forhåndskonfigurerte arbeidsområder med sine favorittverktøy og rammeverk, inkludert Jupyter Notebook, PyCharm og VS Code. Dette:

* **Forenkler oppsettet:** Start arbeidsområder raskt uten å måtte installere avhengigheter manuelt.

* **Sikrer konsistens:** Gir konsistente miljøer på tvers av team og prosjekter.

* **Forbedrer samarbeidet:** Del og samarbeid sømløst på arbeidsområder med teammedlemmer.

Opplæring og finjustering

Run:ai forenkler prosessen med å trene og finjustere AI-modeller:

* **Kø batchjobber:** Planlegg og kjør batch treningsjobber med en enkelt kommandolinje.

* **Distribuert opplæring:** Tren effektivt modeller på store datasett på tvers av flere GPUer.

* **Modelloptimalisering:** Optimaliser treningsparametere og hyperparametre for forbedret ytelse.

Private LLM-er

Run:ai lar brukere distribuere og administrere sine egne private LLM-er, spesialtrente modeller som kan brukes til spesifikke applikasjoner. Dette muliggjør:

* **Modellimplementering:** Distribuer LLM-modeller for slutninger og generer personlige svar.

* **Modelladministrasjon:** Lagre, versjoner og administrer LLM-modeller for enkel tilgang og oppdateringer.

* **Datapersonvern:** Hold brukerdata konfidensiell og sikker innenfor organisasjonens infrastruktur.

NVIDIA & Run:ai Bundle

Run:ai og NVIDIA har inngått partnerskap for å tilby en fullt integrert løsning for DGX Systems, som leverer den mest ytelsesfulle fullstackløsningen for AI-arbeidsbelastninger. Denne pakken:

* **Optimaliserer DGX-ytelsen:** Utnytter Run:ai sine muligheter for å maksimere utnyttelsen og ytelsen til DGX-maskinvaren.

* **Forenkler administrasjonen:** Gir én enkelt plattform for administrasjon av DGX-ressurser og AI-arbeidsbelastninger.

* **Akselererer AI-utvikling:** Gir organisasjoner mulighet til å akselerere sine AI-initiativer med en sammenhengende løsning.

Distribuer på din egen infrastruktur; Sky. On-Prem. Air-Gapped.

Run:ai støtter et bredt spekter av distribusjonsmiljøer, og tilbyr fleksible alternativer for organisasjoner med ulike infrastrukturkrav. Dette inkluderer:

* **Skyimplementeringer:** Implementer Run:ai på store skyleverandører, som AWS, Azure og Google Cloud, slik at du kan dra nytte av deres tjenester og ressurser.

* **Distribusjoner på stedet:** Implementer Run:ai på din egen maskinvareinfrastruktur, og gir full kontroll over AI-miljøet ditt.

* **Utplasseringer med lufthull:** Implementer Run:ai i isolerte miljøer uten Internett-tilkobling, og sikrer sikkerheten og integriteten til dataene dine.

Alle ML-verktøy og rammeverk

Run:ai er utviklet for å fungere med et bredt spekter av maskinlæringsverktøy og rammeverk, inkludert:

* **TensorFlow:** Run og administrere TensorFlow-arbeidsbelastninger effektivt.

* **PyTorch:** Distribuer og optimaliser PyTorch-modeller for trening og slutninger.

* **JAX:** Bruk JAX for høyytelses AI-beregninger.

* **Keras:** Bygg og tren Keras-modeller sømløst.

* **Scikit-learn:** Bruk Scikit-learn for maskinlæringsoppgaver.

* **XGBoost:** Utnytt XGBoost for gradientforsterkende algoritmer.

* **LightGBM:** Distribuer LightGBM for effektiv gradientforsterkning.

* **CatBoost:** Bruk CatBoost for robust gradientforsterkning.

Alle Kubernetes

Run:ai integreres sømløst med Kubernetes, den ledende containerorkestreringsplattformen. Dette sikrer kompatibilitet med eksisterende Kubernetes-miljøer og lar organisasjoner utnytte fordelene, inkludert:

* **Automatisk skalering:** Skaler AI-arbeidsbelastninger dynamisk basert på etterspørsel.

* **Høy tilgjengelighet:** Sørg for at AI-arbeidsbelastninger forblir tilgjengelige selv om individuelle noder svikter.

* **Containeriserte distribusjoner:** Distribuer AI-arbeidsbelastninger som containere, fremme portabilitet og reproduserbarhet.

Hvor som helst

Run:ai er designet for å kunne distribueres hvor som helst, og gir fleksibilitet til organisasjoner med ulike infrastrukturbehov. Dette inkluderer:

* **Datasentre:** Implementer Run:ai i dine egne datasentre for maksimal kontroll og sikkerhet.

* **Skyleverandører:** Implementer Run:ai på store skyleverandører for skalerbarhet og fleksibilitet.

* **Edge-enheter:** Implementer Run:ai på edge-enheter for sanntids AI-applikasjoner.

Enhver infrastruktur

Run:ai støtter et bredt spekter av infrastrukturkomponenter, slik at du kan bygge ditt ideelle AI-miljø:

* **GPUer:** Utnytt høy ytelse GPUer fra ledende leverandører, som NVIDIA, AMD og Intel.

* **CPUer:** Bruk CPUer for oppgaver som ikke krever GPU-akselerasjon.

* **ASIC-er:** Integrer ASIC-er for spesialiserte oppgaver, for eksempel maskinlæringsinferens.

* **Lagring:** Velg lagringsløsninger som best oppfyller dine krav til ytelse, skalerbarhet og kostnad.

* **Nettverk:** Implementer Run:ai på nettverk med høy båndbredde for effektiv dataoverføring og distribuert arbeidsbelastning.

FAQFAQ

// * **Cloud:** Run:ai kan distribueres på alle større skyleverandører, inkludert AWS, Azure , og GCP.

// * **On-Prem:** Run:ai kan også distribueres på stedet, noe som lar organisasjoner holde dataene og arbeidsbelastningene sine sikre i sine egne datasentre.

// * **Air-Gapped:** Run:ai kan også distribueres i air-gapped-miljøer, som er miljøer som ikke er koblet til internett. Dette lar organisasjoner distribuere AI-arbeidsbelastninger i miljøer der det er strenge sikkerhetskrav.//

// * **Inferens:** Kjør: ai kan brukes til å kjøre inferensarbeidsbelastninger på GPUer, noe som kan bidra til å forbedre ytelsen til AI-applikasjoner.//

// * **Forskning og utvikling:** Run:ai kan brukes til å støtte forsknings- og utviklingsarbeid ved å tilby en kraftig plattform for å administrere og distribuere AI-arbeidsbelastninger.//

// * **Dyplæring:** Run:ai kan brukes til å trene og distribuere dyplæringsmodeller, som blir stadig mer populære for et bredt spekter av applikasjoner.//

//

For mer informasjon, vennligst kontakt teamet vårt [email protected] Vi svarer gjerne på spørsmålene dine og hjelper deg med å få startet med Run:ai.//

Nettstedstrafikk

Ingen data