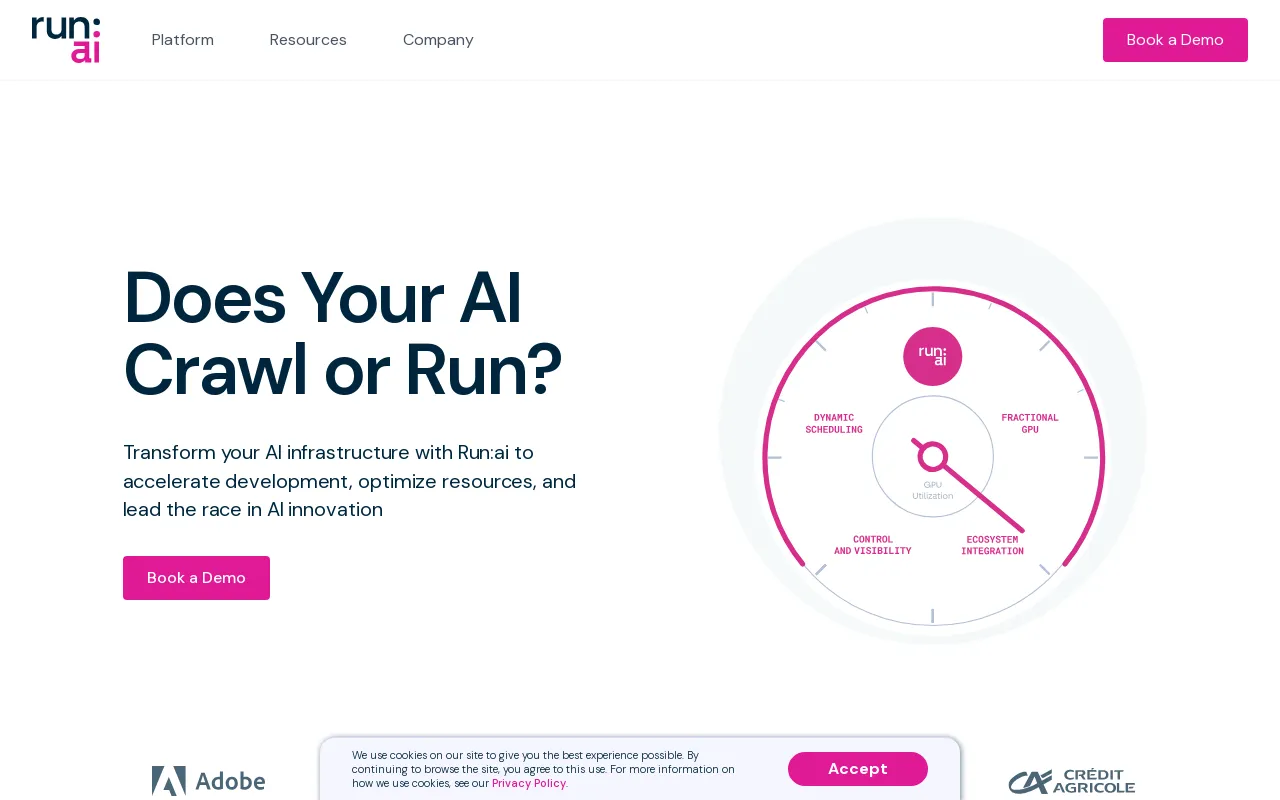

Details van Run:ai

Productinformatie

Product Beschrijving

Run:ai ontwikkelaar

Versnel de AI-ontwikkeling en time-to-market

- Start aangepaste werkruimten met uw favoriete tools en frameworks.

- Zet batchtaken in de wachtrij en voer gedistribueerde training uit met één enkele opdrachtregel.

- Implementeer en beheer uw inferentiemodellen vanaf één plek.

Ecosysteem

Vergroot de GPU-beschikbaarheid en vermenigvuldig het rendement op uw AI-investering

- Werklasten

- Items

- Statistieken

- Beheerder

- Authenticatie en autorisatie

Voer:ai API uit

- Werklasten

- Items

- Statistieken

- Beheerder

- Authenticatie en autorisatie

Run:ai-besturingsvlak

Implementeer op uw eigen infrastructuur; Wolk. Op locatie. Luchtopening.

- Multiclusterbeheer

- Dashboards en rapportage

- Werklastbeheer

- Beleid voor toegang tot bronnen

- Werklastbeleid

- Autorisatie en toegangscontrole

Voer:ai Cluster Engine uit

Maak kennis met uw nieuwe AI-cluster; Gebruikt. Schaalbaar. Onder controle.

- AI-werklastplanner

- Node-pooling

- Containerorkestratie

- GPU-fractionering

- GPU-knooppunten

- CPU-knooppunten

- Opslag

- Netwerk

CLI & GUI

Run:ai biedt een gebruiksvriendelijke opdrachtregelinterface (CLI) en een uitgebreide grafische gebruikersinterface (GUI) voor het beheren van uw AI-workloads en infrastructuur. De CLI biedt geavanceerde besturings- en scriptingmogelijkheden, terwijl de GUI een intuïtieve visuele ervaring biedt voor het monitoren, configureren en communiceren met het platform.

Werkruimtes

Werkruimtes zijn geïsoleerde omgevingen waar AI-beoefenaars aan hun projecten kunnen werken. Deze werkruimten zijn vooraf geconfigureerd met de benodigde tools, bibliotheken en afhankelijkheden, waardoor het installatieproces wordt vereenvoudigd en consistentie tussen teams wordt gegarandeerd. Werkruimten kunnen worden aangepast om aan specifieke projectvereisten te voldoen en kunnen eenvoudig worden gekloond of gedeeld met medewerkers.

Tools

Run:ai biedt een reeks tools die zijn ontworpen om de efficiëntie en productiviteit van AI-ontwikkeling. De tools bieden functies zoals Jupyter Notebook-integratie, TensorBoard-visualisatie en modeltracking. Deze tools stroomlijnen workflows, vereenvoudigen data-analyse en verbeteren de samenwerking tussen teamleden.

Open Source Frameworks

Run:ai ondersteunt een breed scala aan populaire open-source AI-frameworks, waaronder TensorFlow , PyTorch, JAX en Keras. Hierdoor kunnen ontwikkelaars hun favoriete tools en bibliotheken gebruiken zonder hun bestaande codebase aan te passen aan een gespecialiseerd platform.

LLM Catalog

Run:ai biedt een LLM Catalog, een samengestelde verzameling van populaire Large Language Models (LLM's) en hun bijbehorende configuraties. Deze catalogus maakt het gemakkelijker om geavanceerde LLM's te implementeren en ermee te experimenteren, waardoor de ontwikkeling van AI-applicaties wordt versneld die gebruik maken van geavanceerde taalverwerkingsmogelijkheden.

Werklasten

The Run: ai-platform maakt effectief beheer van diverse AI-workloads mogelijk, waaronder:

* **Training:** Run:ai optimaliseert gedistribueerde trainingstaken, waardoor u modellen effectief kunt trainen op grote datasets over meerdere GPU's.

* **Inferentie:** Run:ai stroomlijnt de implementatie en inferentie van modellen, waardoor u modellen kunt inzetten voor realtime voorspellingen of batchverwerking.

* **Notebook Farms:** Run:ai ondersteunt de creatie en het beheer van schaalbare notebookfarms en biedt een samenwerkingsomgeving voor gegevensverkenning en modelprototyping.

* **Onderzoeksprojecten:** Run:ai is ontworpen om onderzoeksactiviteiten te vergemakkelijken en biedt een platform voor experimenten met nieuwe modellen, algoritmen en technieken.

Assets

Met Run:ai kunnen gebruikers AI-middelen beheren en delen, waaronder:

* **Modellen:** Modellen opslaan en versieleren voor eenvoudige toegang en implementatie.

* **Datasets:** Bewaar en beheer grote datasets voor efficiënt gebruik bij trainingstaken.

* **Code:** Deel en werk samen aan code gerelateerd aan AI-projecten.

* **Experimenten:** Volg en vergelijk de resultaten van verschillende AI-experimenten.

Metrische gegevens

Run:ai biedt uitgebreide monitoring- en rapportagemogelijkheden, waardoor gebruikers belangrijke statistieken met betrekking tot hun AI-workloads en infrastructuur kunnen volgen. Dit omvat:

* **GPU-gebruik:** Bewaak het gebruik van GPU's in het hele cluster en zorg voor een efficiënte toewijzing van bronnen.

* **Werklastprestaties:** Volg de prestaties van trainings- en inferentietaken, en identificeer knelpunten en mogelijkheden voor optimalisatie.

* **Bronnenverbruik:** Houd het CPU-, geheugen- en netwerkgebruik bij en bied inzicht in het gebruik van bronnen en potentiële optimalisatiestrategieën.

Admin

Run:ai biedt administratieve tools voor het beheer van het platform en zijn gebruikers, waaronder:

* **Gebruikersbeheer:** Beheer toegangsrechten en machtigingen voor verschillende gebruikers of groepen.

* **Clusterconfiguratie:** Configureer de hardware- en softwarebronnen binnen het AI-cluster.

* **Beleidshandhaving:** Definieer en handhaaf het toewijzingsbeleid voor middelen om eerlijkheid en efficiëntie te garanderen.

Authenticatie en autorisatie

Run:ai biedt veilige authenticatie- en autorisatiemechanismen om de toegang tot bronnen en gevoelige gegevens te controleren. Dit omvat:

* **Single sign-on (SSO):** Integreer met bestaande identiteitsproviders voor naadloze gebruikersauthenticatie.

* **Op rollen gebaseerde toegangscontrole (RBAC):** Definieer rollen met specifieke machtigingen, waardoor gedetailleerde controle over de toegang tot bronnen wordt gegarandeerd.

* **Multi-factor authenticatie (MFA):** Verbeter de beveiliging door meerdere factoren te vereisen voor het inloggen van gebruikers.

Multiclusterbeheer

Run:ai maakt het beheer van meerdere AI-clusters mogelijk vanaf een centraal besturingsvlak. Hierdoor kunnen organisaties:

* **Bronnen consolideren:** Middelen over verschillende clusters samenvoegen, waardoor een uniform beeld ontstaat van de beschikbare capaciteit.

* **Standaardiseer workflows:** Pas consistent beleid en configuraties toe op meerdere clusters.

* **Optimaliseer het gebruik:** Verdeel de werklast over clusters voor een optimale toewijzing van resources.

Dashboards en rapportage

Run:ai biedt krachtige dashboards en rapportagetools om belangrijke statistieken te visualiseren, de werklastprestaties bij te houden en inzicht te krijgen in het gebruik van resources. Deze mogelijkheden omvatten:

* **Realtime monitoring:** Houd het GPU-gebruik, de voortgang van de werklast en het resourcegebruik in realtime bij.

* **Historische analyses:** Analyseer historische gegevens om trends te identificeren, de toewijzing van middelen te optimaliseren en de prestaties van de werklast te verbeteren.

* **Aanpasbare dashboards:** Creëer aangepaste dashboards die zijn afgestemd op specifieke behoeften en perspectieven.

Werklastbeheer

Run:ai vereenvoudigt het beheer van AI-werklasten, waaronder:

* **Planning:** Automatiseer de planning en uitvoering van trainings- en inferentietaken.

* **Prioritisering:** Wijs prioriteiten toe aan werklasten om ervoor te zorgen dat kritieke taken als eerste worden voltooid.

* **Toewijzing van bronnen:** Wijs bronnen (GPU's, CPU's, geheugen) toe aan workloads op basis van hun behoeften en prioriteiten.

Beleid voor toegang tot bronnen

Run:ai biedt een flexibele beleidsengine voor toegang tot bronnen waarmee organisaties regels kunnen definiëren en afdwingen die bepalen hoe gebruikers toegang krijgen tot clusterbronnen en deze kunnen gebruiken. Dit maakt het volgende mogelijk:

* **Eerlijke toewijzing:** Zorg ervoor dat middelen eerlijk worden verdeeld tussen gebruikers en teams.

* **Quotabeheer:** Stel limieten in voor het gebruik van hulpbronnen om overconsumptie te voorkomen en een efficiënte toewijzing te garanderen.

* **Prioriteitsafdwinging:** Geef prioriteit aan de toegang tot bronnen op basis van gebruikersrollen of het belang van de werklast.

Werklastbeleid

Run:ai ondersteunt het creëren van werklastbeleid, waarbij regels en richtlijnen worden gedefinieerd voor het beheren van AI-werklasten. Hierdoor kunnen organisaties:

* **Workflows standaardiseren:** Consistente workflows en best practices opzetten voor het uitvoeren van AI-workloads.

* **Taken automatiseren:** Automatiseer algemene bewerkingen voor werklastbeheer, zoals het toewijzen en plannen van middelen.

* **Verbeter de beveiliging:** Handhaaf beleid om naleving van beveiligingsnormen en -regelgeving te garanderen.

Autorisatie en toegangscontrole

Run:ai maakt gebruik van robuuste autorisatie- en toegangscontrolemechanismen om de toegang tot bronnen en gegevens te beveiligen, waaronder:

* **Fijnmazige machtigingen:* * Verleen specifieke machtigingen aan gebruikers of groepen, waardoor gedetailleerde controle wordt geboden over de toegang tot bronnen.

* **Controle en registratie:** Houd gebruikersacties en toegangspatronen bij en zorg voor een audittrail voor beveiligings- en nalevingsdoeleinden.

* **Integratie met bestaande beveiligingstools:** Integreer Run:ai met bestaande beveiligingssystemen voor gecentraliseerd beheer en controle.

AI Workload Scheduler

Run:ai's AI Workload Scheduler is speciaal ontworpen om het resourcebeheer voor de gehele AI-levenscyclus te optimaliseren, waardoor u:

* **Dynamische planning:* * Wijs middelen dynamisch toe aan werklasten op basis van de huidige behoeften en prioriteiten.

* **GPU-pooling:** Consolideer GPU-bronnen in pools, waardoor flexibele toewijzing aan diverse workloads mogelijk is.

* **Prioriteitsplanning:** Zorg ervoor dat kritieke taken eerst resources toegewezen krijgen, waardoor de algehele doorvoer van het AI-cluster wordt geoptimaliseerd.

Node Pooling

Run:ai introduceert het concept van Node Pooling, waardoor organisaties met gemak heterogene AI-clusters kunnen beheren. Deze functie biedt:

* **Clusterconfiguratie:** Definieer quota's, prioriteiten en beleid op knooppuntpoolniveau om de toewijzing van bronnen te beheren.

* **Bronnenbeheer:** Zorg voor een eerlijke en efficiënte toewijzing van bronnen binnen het cluster, rekening houdend met factoren als GPU-type, geheugen en CPU-kernen.

* **Werklastverdeling:** Wijs werklasten toe aan de juiste knooppuntpools op basis van hun resourcevereisten.

Containerorkestratie

Run:ai kan naadloos worden geïntegreerd met containerorkestratieplatforms zoals Kubernetes, waardoor de implementatie en het beheer van gedistribueerde AI-workloads in containers mogelijk wordt. Dit biedt:

* **Geautomatiseerd schalen:** Schaal AI-workloads naadloos omhoog of omlaag op basis van de vraag.

* **Hoge beschikbaarheid:** Zorg ervoor dat AI-workloads beschikbaar blijven, zelfs als individuele knooppunten uitvallen.

* **Vereenvoudigde implementatie:** Implementeer en beheer AI-workloads met behulp van gecontaineriseerde images, waardoor draagbaarheid en reproduceerbaarheid wordt bevorderd.

GPU-fractionering

Met de GPU-fractioneringstechnologie van Run:ai kunt u een enkele GPU in meerdere fracties verdelen, wat een kosteneffectieve manier biedt om werklasten uit te voeren die slechts een deel van die van een GPU vereisen bronnen. Deze functie:

* **Verhoogt de kostenefficiëntie:** Hiermee kunt u meer werklasten uitvoeren op dezelfde infrastructuur door GPU-bronnen te delen.

* **Vereenvoudigt resourcebeheer:** Stroomlijnt de toewijzing van GPU-bronnen aan diverse workloads met verschillende vereisten.

* **Verbetert het gebruik:** Maximaliseert het gebruik van GPU's, vermindert de inactieve tijd en verhoogt de efficiëntie.

GPU-nodes

Run:ai ondersteunt een breed scala aan GPU-nodes van toonaangevende leveranciers, waaronder NVIDIA, AMD en Intel. Dit zorgt voor compatibiliteit met een verscheidenheid aan hardwareconfiguraties en stelt organisaties in staat de bestaande infrastructuur te gebruiken of de meest geschikte GPU's voor hun specifieke behoeften te selecteren.

CPU-nodes

Naast GPU-nodes biedt Run :ai ondersteunt ook CPU-nodes voor taken waarvoor geen GPU-versnelling nodig is. Hierdoor kunnen organisaties de bestaande CPU-infrastructuur benutten of kosteneffectievere CPU-bronnen gebruiken voor specifieke taken.

Opslag

Run:ai kan worden geïntegreerd met verschillende opslagoplossingen, waaronder NFS, GlusterFS, ceph en lokale schijven. Dankzij deze flexibiliteit kunnen organisaties een opslagoplossing kiezen die het beste aansluit bij hun prestatie-, schaalbaarheids- en kostenvereisten.

Netwerk

Run:ai is ontworpen om efficiënt te werken op netwerken met hoge bandbreedte, waardoor de efficiënte overdracht van gegevens tussen knooppunten en de uitvoering van gedistribueerde AI-werklasten mogelijk wordt. Run:ai kan ook worden ingezet in omgevingen met luchtspleten, waar er geen internetverbinding is, waardoor de veiligheid en isolatie van gevoelige gegevens wordt gegarandeerd.

Notebooks on Demand

Run:ai's Notebooks Met de on Demand-functie kunnen gebruikers vooraf geconfigureerde werkruimten starten met hun favoriete tools en frameworks, waaronder Jupyter Notebook, PyCharm en VS Code. Dit:

* **Vereenvoudigt de installatie:** Start snel werkruimten zonder de noodzaak om afhankelijkheden handmatig te installeren.

* **Zorgt voor consistentie:** Biedt consistente omgevingen voor teams en projecten.

* **Verbetert de samenwerking:** Deel en werk naadloos samen aan werkruimten met teamleden.

Training en verfijning

Run:ai vereenvoudigt het proces van training en verfijning van AI-modellen:

* **Batchtaken in wachtrij plaatsen:** Batch plannen en uitvoeren trainingstaken met één enkele opdrachtregel.

* **Gedistribueerde training:** Effectief modellen trainen op grote datasets over meerdere GPU's.

* **Modeloptimalisatie:** Optimaliseer trainingsparameters en hyperparameters voor betere prestaties.

Privé LLM's

Run:ai stelt gebruikers in staat hun eigen privé LLM's in te zetten en te beheren, op maat getrainde modellen die voor specifieke toepassingen kunnen worden gebruikt. Dit maakt het volgende mogelijk:

* **Modelimplementatie:** Implementeer LLM-modellen voor gevolgtrekking en genereer gepersonaliseerde antwoorden.

* **Modelbeheer:** Bewaar, versie en beheer LLM-modellen voor gemakkelijke toegang en updates.

* **Gegevensprivacy:** Houd gebruikersgegevens vertrouwelijk en veilig binnen de infrastructuur van de organisatie.

NVIDIA & Run:ai Bundle

Run:ai en NVIDIA zijn een partnerschap aangegaan om een volledig geïntegreerde oplossing voor DGX Systems aan te bieden, waarmee de meest performante full-stack oplossing voor AI-workloads wordt geleverd. Deze bundel:

* **Optimaliseert DGX-prestaties:** Maakt gebruik van de mogelijkheden van Run:ai om het gebruik en de prestaties van DGX-hardware te maximaliseren.

* **Vereenvoudigt het beheer:** Biedt één platform voor het beheren van DGX-bronnen en AI-workloads.

* **Versnelt de ontwikkeling van AI:** Stelt organisaties in staat hun AI-initiatieven te versnellen met een samenhangende oplossing.

Implementeer op uw eigen infrastructuur; Wolk. Op locatie. Air-Gapped.

Run:ai ondersteunt een breed scala aan implementatieomgevingen en biedt flexibele opties voor organisaties met verschillende infrastructuurvereisten. Dit omvat:

* **Cloud-implementaties:** Implementeer Run:ai op grote cloudproviders, zoals AWS, Azure en Google Cloud, zodat u hun services en bronnen kunt benutten.

* **On-premises implementaties:** Implementeer Run:ai op uw eigen hardware-infrastructuur, waardoor u volledige controle krijgt over uw AI-omgeving.

* **Air-gapped implementaties:** Implementeer Run:ai in geïsoleerde omgevingen zonder internetverbinding, waardoor de veiligheid en integriteit van uw gegevens worden gewaarborgd.

Elke ML-tool en -framework

Run:ai is ontworpen om te werken met een breed scala aan machine learning-tools en -frameworks, waaronder:

* **TensorFlow:** Run en beheer de TensorFlow-workloads effectief.

* **PyTorch:** Implementeer en optimaliseer PyTorch-modellen voor training en gevolgtrekking.

* **JAX:** Gebruik JAX voor krachtige AI-berekeningen.

* **Keras:** Bouw en train Keras-modellen naadloos.

* **Scikit-learn:** Gebruik Scikit-learn voor machine learning-taken.

* **XGBoost:** Maak gebruik van XGBoost voor algoritmen voor het verhogen van de gradiënt.

* **LightGBM:** Implementeer LightGBM voor efficiënte gradiëntverbetering.

* **CatBoost:** Gebruik CatBoost voor robuuste gradiëntversterking.

Elke Kubernetes

Run:ai kan naadloos worden geïntegreerd met Kubernetes, het toonaangevende containerorkestratieplatform. Dit garandeert compatibiliteit met bestaande Kubernetes-omgevingen en stelt organisaties in staat de voordelen ervan te benutten, waaronder:

* **Geautomatiseerde schaling:** Schaal AI-workloads dynamisch op basis van de vraag.

* **Hoge beschikbaarheid:** Zorg ervoor dat AI-workloads beschikbaar blijven, zelfs als individuele knooppunten uitvallen.

* **Container-implementaties:** Implementeer AI-workloads als containers, wat portabiliteit en reproduceerbaarheid bevordert.

Overal

Run:ai is ontworpen om overal te worden ingezet en biedt flexibiliteit aan organisaties met uiteenlopende infrastructuurbehoeften. Dit omvat:

* **Datacenters:** Implementeer Run:ai in uw eigen datacenters voor maximale controle en beveiliging.

* **Cloudproviders:** Implementeer Run:ai op grote cloudproviders voor schaalbaarheid en flexibiliteit.

* **Edge-apparaten:** Implementeer Run:ai op edge-apparaten voor realtime AI-toepassingen.

Elke infrastructuur

Run:ai ondersteunt een breed scala aan infrastructuurcomponenten, waardoor u uw ideale AI-omgeving kunt bouwen:

* **GPU's:** Maak gebruik van hoge prestaties GPU's van toonaangevende leveranciers, zoals NVIDIA, AMD en Intel.

* **CPU's:** Gebruik CPU's voor taken waarvoor geen GPU-versnelling nodig is.

* **ASIC's:** Integreer ASIC's voor gespecialiseerde taken, zoals machine learning-inferentie.

* **Opslag:** Kies opslagoplossingen die het beste aansluiten bij uw vereisten op het gebied van prestaties, schaalbaarheid en kosten.

* **Netwerken:** Implementeer Run:ai op netwerken met hoge bandbreedte voor efficiënte gegevensoverdracht en gedistribueerde werklasten.

FAQFAQ

// * **Cloud:** Run:ai kan worden geïmplementeerd op elke grote cloudprovider, waaronder AWS, Azure en GCP.

// * **On-Prem:** Run:ai kan ook on-premise worden geïmplementeerd, waardoor organisaties hun gegevens en workloads veilig kunnen houden in hun eigen datacenters.

// * **Air-Gapped:** Run:ai kan ook worden ingezet in air-gapped-omgevingen, dit zijn omgevingen die niet met internet zijn verbonden. Hierdoor kunnen organisaties AI-workloads implementeren in omgevingen waar strenge beveiligingsvereisten gelden.//

// * **Gevolgtrekking:** Run: ai kan worden gebruikt om inferentiewerklasten op GPU's uit te voeren, wat kan helpen de prestaties van AI-applicaties te verbeteren.//

// * **Onderzoek en ontwikkeling:** Run:ai kan worden gebruikt om onderzoeks- en ontwikkelingsinspanningen te ondersteunen door een krachtig platform te bieden voor het beheren en inzetten van AI-workloads.//

// * **Deep learning:** Run:ai kan worden gebruikt om deep learning-modellen te trainen en in te zetten, die voor een breed scala steeds populairder worden van toepassingen.//

//

Neem voor meer informatie contact op met ons team [email protected] We beantwoorden graag uw vragen en helpen u bij het verkrijgen begonnen met Run:ai.//

Websiteverkeer

Geen Gegevens

Alternatieve Producten

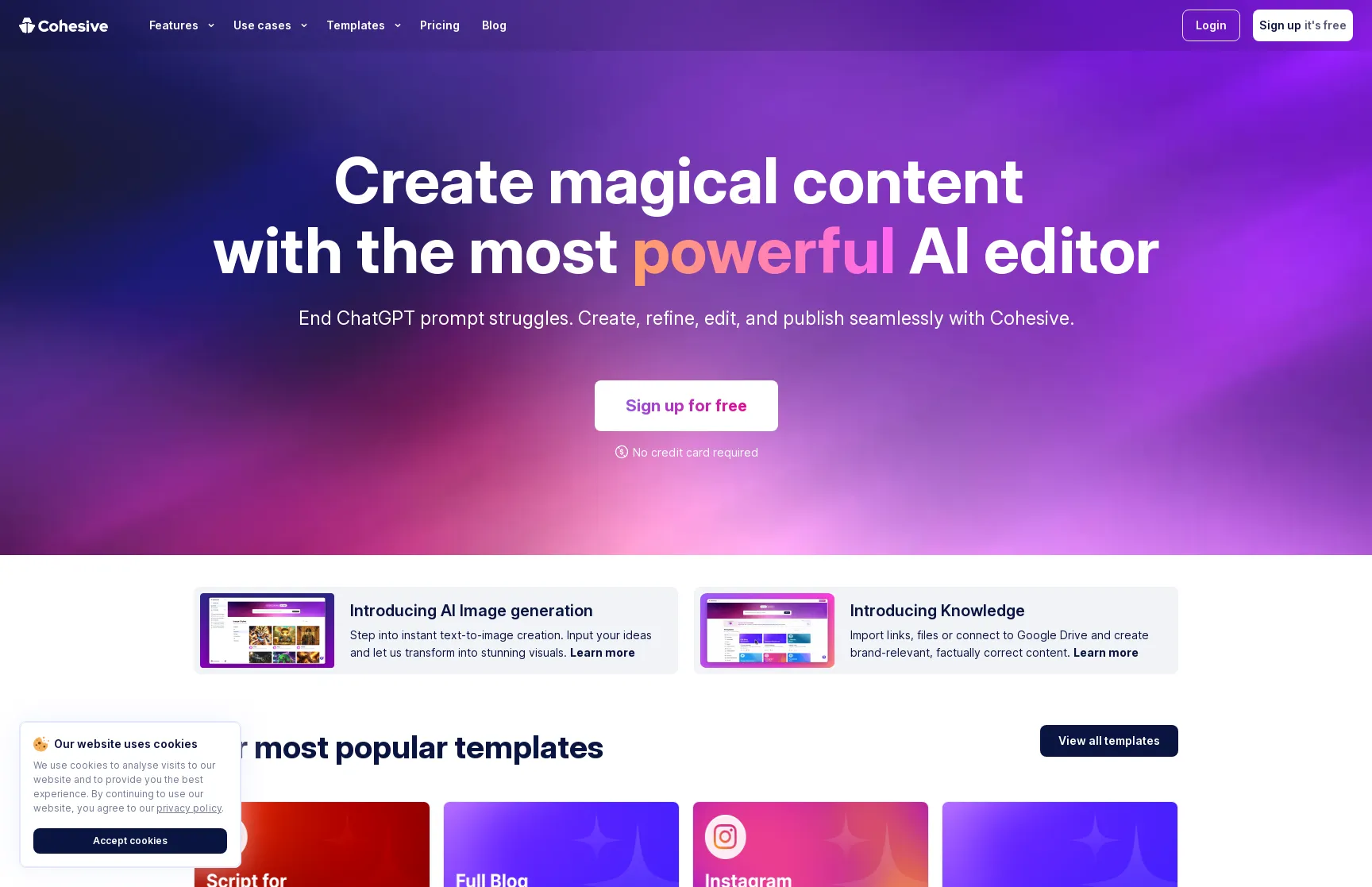

Cohesive

Blog & artikel schrijven

Creëer magische inhoud met de krachtigste AI-editor

AI改写

Blog & artikel schrijven

Welkom bij Aigaixie, een door AI aangedreven hulpmiddel voor het maken van inhoud

绘AI

Beeld generatie

Ai-tekenen

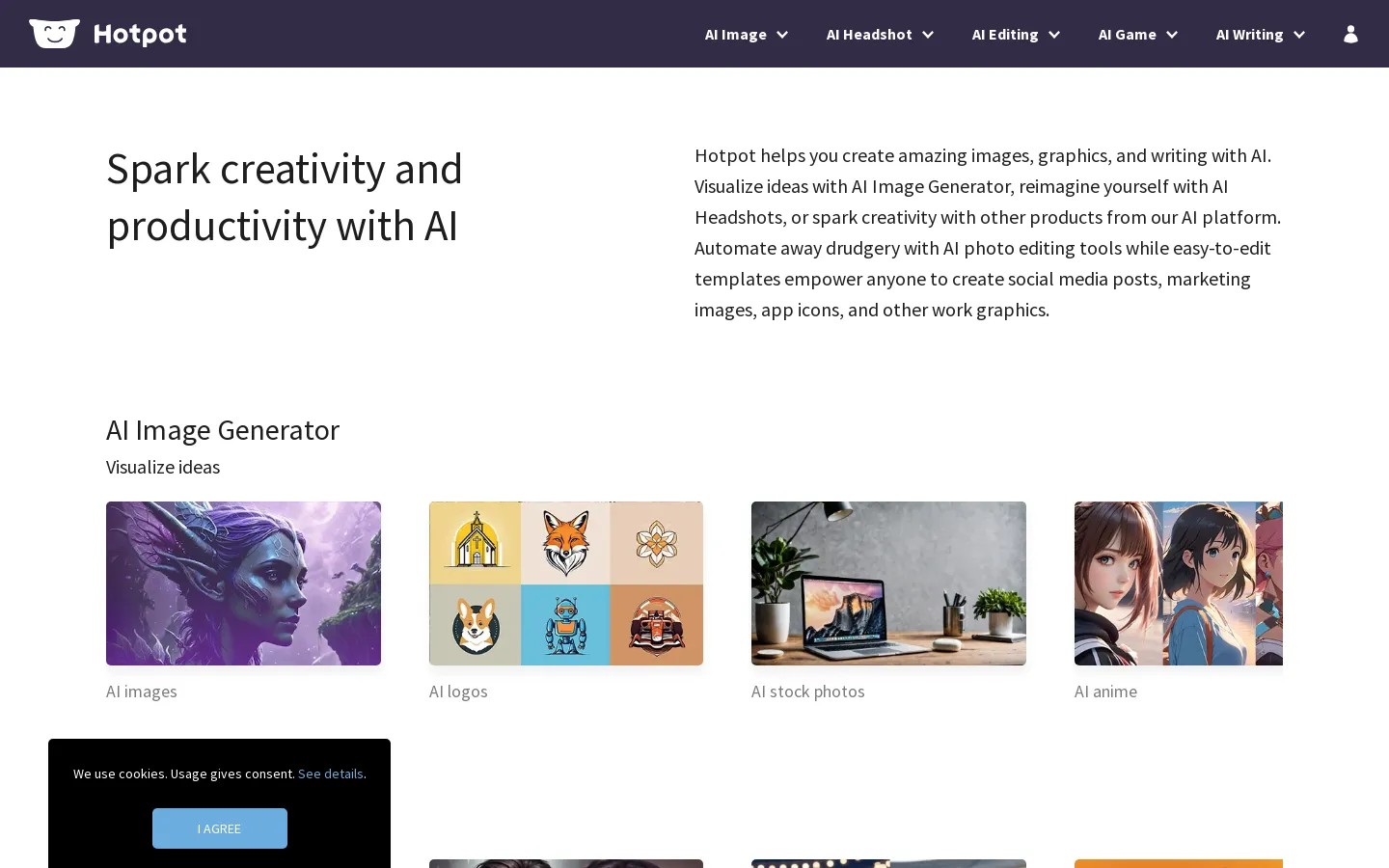

Hotpot AI

Beeld generatie

Stimuleer creativiteit en productiviteit met AI

AI Art

Beeld generatie

AI Graphic Creation Platform

360 AI

Beeld generatie

AI creëert verbluffende kunstwerken