Run:ai 상세 정보

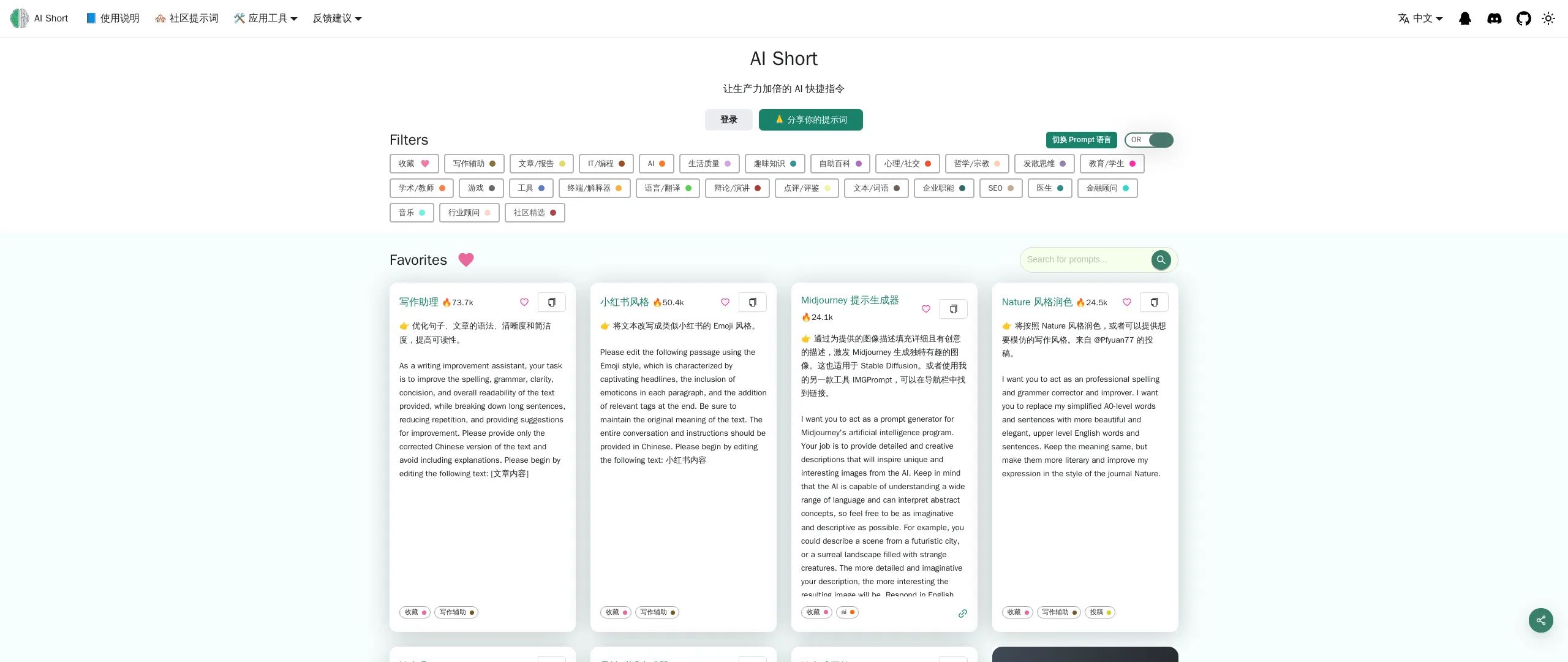

제품 정보

제품 설명

런:ai 개발

AI 개발 및 출시 기간 가속화

- 원하는 도구와 프레임워크를 사용하여 맞춤형 작업공간을 시작하세요.

- 일괄 작업을 대기열에 추가하고 단일 명령줄로 분산 학습을 실행합니다.

- 한 곳에서 추론 모델을 배포하고 관리하세요.

생태계

GPU 가용성을 높이고 AI 투자 수익을 배가하세요

- 워크로드

- 자산

- 측정항목

- 관리자

- 인증 및 승인

실행:ai API

- 워크로드

- 자산

- 측정항목

- 관리자

- 인증 및 승인

Run:ai 제어 플레인

자신의 인프라에 배포하세요. 구름. 온프레미스. 에어 갭.

- 멀티 클러스터 관리

- 대시보드 및 보고

- 작업량 관리

- 리소스 액세스 정책

- 작업 부하 정책

- 승인 및 액세스 제어

Run:ai 클러스터 엔진

새로운 AI 클러스터를 만나보세요. 활용. 확장 가능. 통제하에 있습니다.

- AI 워크로드 스케줄러

- 노드 풀링

- 컨테이너 오케스트레이션

- GPU 분할

- GPU 노드

- CPU 노드

- 저장

- 네트워크

CLI 및 GUI

Run:ai는 AI 워크로드 및 인프라 관리를 위한 사용자 친화적인 명령줄 인터페이스(CLI)와 포괄적인 그래픽 사용자 인터페이스(GUI)를 제공합니다. CLI는 고급 제어 및 스크립팅 기능을 제공하는 반면, GUI는 플랫폼 모니터링, 구성 및 상호 작용을 위한 직관적인 시각적 경험을 제공합니다.

작업 공간

작업 공간은 AI 실무자가 작업하는 격리된 환경입니다. 그들의 프로젝트를 수행할 수 있습니다. 이러한 작업 영역은 필요한 도구, 라이브러리 및 종속성으로 사전 구성되어 설정 프로세스를 단순화하고 팀 전체의 일관성을 보장합니다. 작업 공간은 특정 프로젝트 요구 사항에 맞게 사용자 정의할 수 있으며 쉽게 복제하거나 공동 작업자와 공유할 수 있습니다.

도구

Run:ai는 작업의 효율성과 생산성을 향상하도록 설계된 도구 모음을 제공합니다. AI 개발. 이 도구는 Jupyter Notebook 통합, TensorBoard 시각화 및 모델 추적과 같은 기능을 제공합니다. 이러한 도구는 워크플로를 간소화하고 데이터 분석을 단순화하며 팀 구성원 간의 협업을 향상시킵니다.

오픈 소스 프레임워크

Run:ai는 TensorFlow를 포함하여 널리 사용되는 광범위한 오픈 소스 AI 프레임워크를 지원합니다. , PyTorch, JAX 및 Keras. 이를 통해 개발자는 기존 코드베이스를 특수 플랫폼에 맞게 조정할 필요 없이 선호하는 도구와 라이브러리를 활용할 수 있습니다.

LLM 카탈로그

Run:ai는 엄선된 컬렉션인 LLM 카탈로그를 제공합니다. 널리 사용되는 LLM(대형 언어 모델) 및 해당 구성. 이 카탈로그를 사용하면 최첨단 LLM을 더 쉽게 배포하고 실험할 수 있으므로 고급 언어 처리 기능을 활용하는 AI 애플리케이션 개발을 가속화할 수 있습니다.

워크로드

실행: ai 플랫폼을 사용하면 다음을 포함한 다양한 AI 워크로드를 효과적으로 관리할 수 있습니다.

* **교육:** Run:ai는 분산 교육 작업을 최적화하여 여러 GPU에 걸쳐 대규모 데이터 세트에 대한 모델을 효과적으로 교육할 수 있습니다.

* **추론:** Run:ai는 모델 배포 및 추론을 간소화하여 실시간 예측 또는 일괄 처리를 위한 모델을 배포할 수 있도록 해줍니다.

* **노트북 팜:** Run:ai는 확장 가능한 노트북 팜의 생성 및 관리를 지원하여 데이터 탐색 및 모델 프로토타이핑을 위한 협업 환경을 제공합니다.

* **연구 프로젝트:** Run:ai는 연구 활동을 촉진하고 새로운 모델, 알고리즘 및 기술을 실험할 수 있는 플랫폼을 제공하도록 설계되었습니다.

자산

Run:ai를 사용하면 사용자는 다음을 포함한 AI 자산을 관리하고 공유할 수 있습니다.

* **모델:** 쉬운 액세스 및 배포를 위해 훈련된 모델을 저장하고 버전을 지정합니다.

* **데이터세트:** 학습 작업에서 효율적으로 사용할 수 있도록 대규모 데이터세트를 저장하고 관리합니다.

* **코드:** AI 프로젝트와 관련된 코드를 공유하고 협업하세요.

* **실험:** 다양한 AI 실험 결과를 추적하고 비교합니다.

측정항목

Run:ai는 포괄적인 모니터링 및 보고 기능을 제공하여 사용자가 AI 워크로드 및 인프라와 관련된 주요 측정항목을 추적할 수 있도록 합니다. 여기에는 다음이 포함됩니다.

* **GPU 활용도:** 클러스터 전체의 GPU 활용도를 모니터링하여 효율적인 리소스 할당을 보장합니다.

* **워크로드 성능:** 훈련 및 추론 작업의 성능을 추적하여 병목 현상과 최적화 기회를 식별합니다.

* **리소스 소비:** CPU, 메모리, 네트워크 사용량을 모니터링하여 리소스 활용도와 잠재적인 최적화 전략에 대한 통찰력을 제공합니다.

관리

Run:ai는 다음을 포함하여 플랫폼과 사용자를 관리하기 위한 관리 도구를 제공합니다.

* **사용자 관리:** 다양한 사용자에 대한 액세스 권한 및 권한 제어 또는 그룹.

* **클러스터 구성:** AI 클러스터 내의 하드웨어 및 소프트웨어 리소스를 구성합니다.

* **정책 시행:** 공정성과 효율성을 보장하기 위해 자원 할당 정책을 정의하고 시행합니다.

인증 및 권한 부여

Run:ai는 리소스 및 민감한 데이터에 대한 액세스를 제어하기 위한 안전한 인증 및 권한 부여 메커니즘을 제공합니다. 여기에는 다음이 포함됩니다.

* **싱글 사인온(SSO):** 원활한 사용자 인증을 위해 기존 ID 제공업체와 통합합니다.

* **역할 기반 액세스 제어(RBAC):** 특정 권한이 있는 역할을 정의하여 리소스에 대한 액세스를 세부적으로 제어할 수 있습니다.

* **다단계 인증(MFA):** 사용자 로그인에 여러 요소를 요구하여 보안을 강화합니다.

멀티 클러스터 관리

Run:ai를 사용하면 중앙 제어 플레인에서 여러 AI 클러스터를 관리할 수 있습니다. 이를 통해 조직은 다음을 수행할 수 있습니다.

* **리소스 통합:** 다양한 클러스터의 리소스를 집계하여 사용 가능한 용량에 대한 통합 보기를 제공합니다.

* **워크플로 표준화:** 여러 클러스터에 걸쳐 일관된 정책과 구성을 적용합니다.

* **활용도 최적화:** 최적의 리소스 할당을 위해 클러스터 전체에 워크로드 분산의 균형을 맞춥니다.

대시보드 및 보고

Run:ai는 주요 지표를 시각화하고, 워크로드 성능을 추적하고, 리소스 활용도에 대한 통찰력을 얻을 수 있는 강력한 대시보드와 보고 도구를 제공합니다. 이러한 기능에는 다음이 포함됩니다.

* **실시간 모니터링:** GPU 활용도, 작업 부하 진행 상황, 리소스 사용량을 실시간으로 추적합니다.

* **기록 분석:** 기록 데이터를 분석하여 추세를 파악하고 리소스 할당을 최적화하며 워크로드 성능을 개선합니다.

* **맞춤형 대시보드:** 특정 요구 사항과 관점에 맞는 맞춤 대시보드를 만듭니다.

워크로드 관리

Run:ai는 다음을 포함하여 AI 워크로드 관리를 단순화합니다.

* **스케줄링:** 훈련 및 추론 작업의 예약 및 실행을 자동화합니다.

* **우선순위 지정:** 중요한 작업이 먼저 완료되도록 작업 부하에 우선순위를 할당합니다.

* **리소스 할당:** 요구사항과 우선순위에 따라 워크로드에 리소스(GPU, CPU, 메모리)를 할당합니다.

리소스 액세스 정책

Run:ai는 조직이 사용자가 클러스터 리소스에 액세스하고 활용하는 방법을 관리하는 규칙을 정의하고 시행할 수 있는 유연한 리소스 액세스 정책 엔진을 제공합니다. 이를 통해 다음이 가능합니다.

* **공정한 공유 할당:** 리소스가 사용자와 팀 간에 공정하게 할당되도록 합니다.

* **할당량 관리:** 리소스 사용량에 제한을 설정하여 과소비를 방지하고 효율적인 할당을 보장합니다.

* **우선순위 적용:** 사용자 역할이나 워크로드 중요성에 따라 리소스에 대한 액세스 우선순위를 지정합니다.

워크로드 정책

Run:ai는 AI 워크로드 관리를 위한 규칙과 지침을 정의하는 워크로드 정책 생성을 지원합니다. 이를 통해 조직은 다음을 수행할 수 있습니다.

* **워크플로 표준화:** AI 워크로드 실행을 위한 일관된 워크플로와 모범 사례를 확립합니다.

* **작업 자동화:** 리소스 할당 및 예약과 같은 일반적인 작업 부하 관리 작업을 자동화합니다.

* **보안 강화:** 보안 표준 및 규정을 준수하도록 정책을 시행합니다.

승인 및 액세스 제어

Run:ai는 강력한 승인 및 액세스 제어 메커니즘을 사용하여 다음을 포함하여 리소스 및 데이터에 대한 액세스를 보호합니다.

* **세분화된 권한:* * 사용자 또는 그룹에 특정 권한을 부여하여 리소스에 대한 액세스를 세부적으로 제어할 수 있습니다.

* **감사 및 로깅:** 사용자 작업 및 액세스 패턴을 추적하여 보안 및 규정 준수 목적으로 감사 추적을 제공합니다.

* **기존 보안 도구와의 통합:** 중앙 집중식 관리 및 제어를 위해 Run:ai를 기존 보안 시스템과 통합합니다.

AI Workload Scheduler

Run:ai의 AI Workload Scheduler는 전체 AI 수명 주기에 대한 리소스 관리를 최적화하도록 특별히 설계되어 다음을 수행할 수 있습니다.

* **동적 일정:* * 현재 요구사항과 우선순위에 따라 워크로드에 리소스를 동적으로 할당합니다.

* **GPU 풀링:** GPU 리소스를 풀로 통합하여 다양한 워크로드에 유연하게 할당할 수 있습니다.

* **우선순위 예약:** 중요한 작업에 리소스가 먼저 할당되어 AI 클러스터의 전체 처리량을 최적화합니다.

노드 풀링

Run:ai는 노드 풀링 개념을 도입하여 조직이 이기종 AI 클러스터를 쉽게 관리할 수 있도록 해줍니다. 이 기능은 다음을 제공합니다.

* **클러스터 구성:** 노드 풀 수준에서 할당량, 우선순위 및 정책을 정의하여 리소스 할당을 관리합니다.

* **리소스 관리:** GPU 유형, 메모리, CPU 코어 등의 요소를 고려하여 클러스터 내에서 리소스를 공정하고 효율적으로 할당합니다.

* **워크로드 분산:** 리소스 요구 사항에 따라 적절한 노드 풀에 워크로드를 할당합니다.

컨테이너 오케스트레이션

Run:ai는 Kubernetes와 같은 컨테이너 오케스트레이션 플랫폼과 원활하게 통합되어 분산된 컨테이너화된 AI 워크로드의 배포 및 관리를 지원합니다. 이는 다음을 제공합니다.

* **자동 확장:** 수요에 따라 AI 워크로드를 원활하게 확장하거나 축소합니다.

* **고가용성:** 개별 노드에 장애가 발생하더라도 AI 워크로드를 계속 사용할 수 있도록 보장합니다.

* **간소화된 배포:** 컨테이너화된 이미지를 사용하여 AI 워크로드를 배포 및 관리하여 이식성과 재현성을 향상합니다.

GPU 분할

Run:ai의 GPU 분할 기술을 사용하면 단일 GPU를 여러 부분으로 나눌 수 있어 GPU의 일부만 필요한 작업 부하를 실행하는 비용 효율적인 방법을 제공합니다. 자원. 이 기능은 다음과 같습니다.

* **비용 효율성 증가:** GPU 리소스를 공유하여 동일한 인프라에서 더 많은 워크로드를 실행할 수 있습니다.

* **리소스 관리 단순화:** 다양한 요구 사항이 있는 다양한 워크로드에 대한 GPU 리소스 할당을 간소화합니다.

* **활용도 향상:** GPU 활용도를 최대화하여 유휴 시간을 줄이고 효율성을 높입니다.

GPU 노드

Run:ai는 NVIDIA, AMD 및 Intel을 포함한 주요 공급업체의 광범위한 GPU 노드를 지원합니다. 이를 통해 다양한 하드웨어 구성과의 호환성이 보장되며 조직은 기존 인프라를 활용하거나 특정 요구 사항에 가장 적합한 GPU를 선택할 수 있습니다.

CPU 노드

GPU 노드 외에도 다음을 실행합니다. :ai는 GPU 가속이 필요하지 않은 작업을 위해 CPU 노드도 지원합니다. 이를 통해 조직은 기존 CPU 인프라를 활용하거나 특정 작업에 보다 비용 효과적인 CPU 리소스를 활용할 수 있습니다.

스토리지

Run:ai는 NFS, GlusterFS, ceph를 포함한 다양한 스토리지 솔루션과 통합됩니다. 및 로컬 디스크. 이러한 유연성을 통해 조직은 성능, 확장성 및 비용 요구 사항을 가장 잘 충족하는 스토리지 솔루션을 선택할 수 있습니다.

네트워크

Run:ai는 고대역폭 네트워크에서 효율적으로 작동하도록 설계되었습니다. 노드 간 효율적인 데이터 전송과 분산 AI 워크로드 실행을 가능하게 합니다. Run:ai는 인터넷 연결이 없는 에어갭 환경에도 배포할 수 있어 민감한 데이터의 보안과 격리를 보장합니다.

주문형 노트북

Run:ai의 노트북 온디맨드 기능을 통해 사용자는 Jupyter Notebook, PyCharm 및 VS Code를 포함하여 선호하는 도구 및 프레임워크를 사용하여 사전 구성된 작업 공간을 시작할 수 있습니다.

* **설정 단순화:** 수동으로 종속성을 설치할 필요 없이 작업공간을 빠르게 시작합니다.

* **일관성 보장:** 팀과 프로젝트 전반에 걸쳐 일관된 환경을 제공합니다.

* **공동작업 강화:** 팀 구성원과 작업 공간을 원활하게 공유하고 공동작업합니다.

훈련 및 미세 조정

Run:ai는 AI 모델 훈련 및 미세 조정 프로세스를 단순화합니다.

* **일괄 작업 대기열:** 일괄 작업 예약 및 실행 단일 명령줄로 작업을 훈련합니다.

* **분산 교육:** 여러 GPU의 대규모 데이터 세트에서 모델을 효과적으로 교육합니다.

* **모델 최적화:** 성능 향상을 위해 훈련 매개변수와 하이퍼 매개변수를 최적화합니다.

비공개 LLM

Run:ai를 통해 사용자는 특정 애플리케이션에 사용할 수 있는 맞춤형 학습 모델인 자신만의 비공개 LLM을 배포하고 관리할 수 있습니다. 이를 통해 다음이 가능합니다.

* **모델 배포:** 추론을 위해 LLM 모델을 배포하고 맞춤형 응답을 생성합니다.

* **모델 관리:** 간편한 액세스 및 업데이트를 위해 LLM 모델을 저장, 버전 관리 및 관리합니다.

* **데이터 개인정보 보호:** 조직 인프라 내에서 사용자 데이터를 기밀로 안전하게 유지합니다.

NVIDIA 및 Run:ai 번들

Run:ai와 NVIDIA는 DGX 시스템을 위한 완전히 통합된 솔루션을 제공하기 위해 제휴하여 AI 워크로드를 위한 가장 성능이 뛰어난 풀 스택 솔루션을 제공합니다. 이 번들:

* **DGX 성능 최적화:** Run:ai의 기능을 활용하여 DGX 하드웨어의 활용도와 성능을 극대화합니다.

* **관리 단순화:** DGX 리소스 및 AI 워크로드를 관리하기 위한 단일 플랫폼을 제공합니다.

* **AI 개발 가속화:** 조직이 응집력 있는 솔루션을 통해 AI 이니셔티브를 가속화할 수 있도록 지원합니다.

자체 인프라에 배포; 구름. 온프레미스. Air-Gapped.

Run:ai는 광범위한 배포 환경을 지원하여 다양한 인프라 요구 사항을 가진 조직에 유연한 옵션을 제공합니다. 여기에는 다음이 포함됩니다.

* **클라우드 배포:** AWS, Azure, Google Cloud 등 주요 클라우드 제공업체에 Run:ai를 배포하여 서비스와 리소스를 활용할 수 있습니다.

* **온프레미스 배포:** 자체 하드웨어 인프라에 Run:ai를 배포하여 AI 환경을 완벽하게 제어할 수 있습니다.

* **Air-gapped 배포:** 인터넷 연결이 없는 격리된 환경에 Run:ai를 배포하여 데이터의 보안과 무결성을 보장합니다.

모든 ML 도구 및 프레임워크

Run:ai는 다음을 포함한 광범위한 기계 학습 도구 및 프레임워크와 작동하도록 설계되었습니다.

* **TensorFlow:** Run TensorFlow 워크로드를 효과적으로 관리합니다.

* **PyTorch:** 훈련 및 추론을 위해 PyTorch 모델을 배포하고 최적화합니다.

* **JAX:** 고성능 AI 계산을 위해 JAX를 활용합니다.

* **Keras:** Keras 모델을 원활하게 구축하고 학습시킵니다.

* **Scikit-learn:** 기계 학습 작업에 Scikit-learn을 활용합니다.

* **XGBoost:** 그래디언트 부스팅 알고리즘에 XGBoost를 활용합니다.

* **LightGBM:** 효율적인 그래디언트 부스팅을 위해 LightGBM을 배포합니다.

* **CatBoost:** 강력한 그래디언트 부스팅을 위해 CatBoost를 활용하세요.

모든 Kubernetes

Run:ai는 최고의 컨테이너 오케스트레이션 플랫폼인 Kubernetes와 원활하게 통합됩니다. 이를 통해 기존 Kubernetes 환경과의 호환성을 보장하고 조직에서 다음과 같은 이점을 활용할 수 있습니다.

* **자동 확장:** 수요에 따라 AI 워크로드를 동적으로 확장합니다.

* **고가용성:** 개별 노드에 장애가 발생하더라도 AI 워크로드를 계속 사용할 수 있도록 보장합니다.

* **컨테이너화된 배포:** AI 워크로드를 컨테이너로 배포하여 이동성과 재현성을 향상합니다.

어디서나

Run:ai는 어디에나 배포할 수 있도록 설계되어 다양한 인프라 요구 사항을 가진 조직에 유연성을 제공합니다. 여기에는 다음이 포함됩니다.

* **데이터 센터:** 최대 제어 및 보안을 위해 자체 데이터 센터에 Run:ai를 배포합니다.

* **클라우드 제공업체:** 확장성과 유연성을 위해 주요 클라우드 제공업체에 Run:ai를 배포하세요.

* **엣지 장치:** 실시간 AI 애플리케이션을 위해 엣지 장치에 Run:ai를 배포합니다.

모든 인프라

Run:ai는 광범위한 인프라 구성 요소를 지원하므로 이상적인 AI 환경을 구축할 수 있습니다.

* **GPU:** 고성능 활용 NVIDIA, AMD, Intel 등 주요 공급업체의 GPU.

* **CPU:** GPU 가속이 필요하지 않은 작업에 CPU를 활용합니다.

* **ASIC:** 기계 학습 추론과 같은 특수 작업을 위해 ASIC을 통합합니다.

* **스토리지:** 성능, 확장성 및 비용 요구 사항을 가장 잘 충족하는 스토리지 솔루션을 선택하세요.

* **네트워킹:** 효율적인 데이터 전송과 작업 부하 분산을 위해 고대역폭 네트워크에 Run:ai를 배포합니다.

FAQFAQ

// * **클라우드:** Run:ai는 AWS, Azure를 포함한 모든 주요 클라우드 공급자에 배포할 수 있습니다. 및 GCP.

// * **온프레미스:** Run:ai는 온프레미스에도 배포할 수 있으므로 조직은 자체 데이터 센터 내에서 데이터와 워크로드를 안전하게 유지할 수 있습니다.

// * **Air-Gapped:** Run:ai는 인터넷에 연결되지 않은 환경인 Air-Gapped 환경에도 배포할 수 있습니다. 이를 통해 조직은 엄격한 보안 요구 사항이 있는 환경에서 AI 워크로드를 배포할 수 있습니다.//

// * **추론:** 실행: ai는 GPU에서 추론 워크로드를 실행하는 데 사용될 수 있으며, 이는 AI 애플리케이션의 성능을 향상하는 데 도움이 될 수 있습니다.//

// * **연구 및 개발:** Run:ai는 연구 및 개발 노력을 지원하는 데 사용될 수 있습니다. AI 워크로드 관리 및 배포를 위한 강력한 플랫폼을 제공함으로써.//

// * **딥 러닝:** Run:ai는 광범위한 분야에서 점점 인기를 얻고 있는 딥 러닝 모델을 훈련하고 배포하는 데 사용할 수 있습니다. //

//

자세한 내용은 저희 팀 [email protected]에 문의하세요. 귀하의 질문에 기꺼이 답변하고 도움을 드리겠습니다. Run:ai로 시작되었습니다.//

웹사이트 트래픽

데이터 없음