Dettagli di Run:ai

Informazioni sul Prodotto

Sito Web

https://www.run.aiCategoria

Chatbot conversazionaleUbicazione

New York, New York, Stati Uniti Tel Aviv, Israele

Descrizione del Prodotto

Esegui:ai Dev

Accelerare lo sviluppo dell'intelligenza artificiale e il time-to-market

- Lancia aree di lavoro personalizzate con i tuoi strumenti e framework preferiti.

- Accoda lavori batch ed esegui training distribuito con un'unica riga di comando.

- Distribuisci e gestisci i tuoi modelli di inferenza da un unico posto.

Ecosistema

Aumenta la disponibilità della GPU e moltiplica il ritorno sull'investimento in IA

- Carichi di lavoro

- Risorse

- Metriche

- Amministratore

- Autenticazione e autorizzazione

Esegui:ai API

- Carichi di lavoro

- Risorse

- Metriche

- Amministratore

- Autenticazione e autorizzazione

Esegui:ai Control Plane

Implementa sulla tua infrastruttura; Nuvola. In sede. Con gap d'aria.

- Gestione multi-cluster

- Dashboard e report

- Gestione del carico di lavoro

- Politica di accesso alle risorse

- Politica sul carico di lavoro

- Autorizzazione e controllo degli accessi

Esegui:ai Cluster Engine

Ti presentiamo il tuo nuovo cluster AI; Utilizzato. Scalabile. Sotto controllo.

- Pianificazione del carico di lavoro AI

- Pool di nodi

- Orchestrazione dei contenitori

- Frazionamento della GPU

- Nodi GPU

- Nodi CPU

- Archiviazione

- Rete

CLI e GUI

Run:ai fornisce un'interfaccia a riga di comando (CLI) intuitiva e un'interfaccia utente grafica (GUI) completa per la gestione dei carichi di lavoro e dell'infrastruttura AI. La CLI offre funzionalità avanzate di controllo e scripting, mentre la GUI fornisce un'esperienza visiva intuitiva per il monitoraggio, la configurazione e l'interazione con la piattaforma.

Aree di lavoro

Le aree di lavoro sono ambienti isolati in cui i professionisti dell'intelligenza artificiale possono lavorare sui loro progetti. Queste aree di lavoro sono preconfigurate con gli strumenti, le librerie e le dipendenze necessarie, semplificando il processo di configurazione e garantendo coerenza tra i team. Gli spazi di lavoro possono essere personalizzati per soddisfare requisiti specifici del progetto e possono essere facilmente clonati o condivisi con i collaboratori.

Strumenti

Run:ai fornisce una suite di strumenti progettati per migliorare l'efficienza e la produttività dei dipendenti. Sviluppo dell'intelligenza artificiale. Gli strumenti offrono funzionalità come l'integrazione di Jupyter Notebook, la visualizzazione di TensorBoard e il monitoraggio dei modelli. Questi strumenti semplificano i flussi di lavoro, semplificano l'analisi dei dati e migliorano la collaborazione tra i membri del team.

Framework open source

Run:ai supporta un'ampia gamma di popolari framework IA open source, incluso TensorFlow , PyTorch, JAX e Keras. Ciò consente agli sviluppatori di sfruttare i propri strumenti e librerie preferiti senza dover adattare la base di codice esistente a una piattaforma specializzata.

Catalogo LLM

Run:ai offre un catalogo LLM, una raccolta curata di popolari Large Language Models (LLM) e le loro configurazioni corrispondenti. Questo catalogo semplifica l'implementazione e la sperimentazione di LLM all'avanguardia, accelerando lo sviluppo di applicazioni IA che sfruttano capacità avanzate di elaborazione del linguaggio.

Carichi di lavoro

The Run: La piattaforma ai consente una gestione efficace di diversi carichi di lavoro IA, tra cui:

* **Formazione:** Run:ai ottimizza i processi di formazione distribuiti, consentendoti di addestrare in modo efficace modelli su set di dati di grandi dimensioni su più GPU.

* **Inferenza:** Run:ai semplifica la distribuzione e l'inferenza dei modelli, consentendoti di distribuire modelli per previsioni in tempo reale o elaborazione batch.

* **Notebook Farm:** Run:ai supporta la creazione e la gestione di notebook farm scalabili, fornendo un ambiente collaborativo per l'esplorazione dei dati e la prototipazione di modelli.

* **Progetti di ricerca:** Run:ai è progettato per facilitare le attività di ricerca, offrendo una piattaforma per la sperimentazione di nuovi modelli, algoritmi e tecniche.

Risorse

Run:ai consente agli utenti di gestire e condividere risorse IA, tra cui:

* **Modelli:** archivia modelli con training sulla versione per un facile accesso e implementazione.

* **Set di dati:** archivia e gestisci set di dati di grandi dimensioni per un utilizzo efficiente nei processi di formazione.

* **Codice:** Condividi e collabora al codice relativo ai progetti IA.

* **Esperimenti:** Tieni traccia e confronta i risultati di diversi esperimenti di intelligenza artificiale.

Metriche

Run:ai fornisce funzionalità complete di monitoraggio e reporting, consentendo agli utenti di tenere traccia delle metriche chiave relative ai carichi di lavoro e all'infrastruttura AI. Ciò include:

* **Utilizzo della GPU:** monitora l'utilizzo delle GPU nel cluster, garantendo un'allocazione efficiente delle risorse.

* **Prestazioni del carico di lavoro:** monitora le prestazioni dei lavori di formazione e inferenza, identificando i colli di bottiglia e le opportunità di ottimizzazione.

* **Consumo di risorse:** monitora l'utilizzo di CPU, memoria e rete, fornendo approfondimenti sull'utilizzo delle risorse e sulle potenziali strategie di ottimizzazione.

Amministrazione

Run:ai offre strumenti amministrativi per la gestione della piattaforma e dei suoi utenti, tra cui:

* **Gestione utenti:** controlla i diritti di accesso e le autorizzazioni per diversi utenti o gruppi.

* **Configurazione del cluster:** Configura le risorse hardware e software all'interno del cluster AI.

* **Applicazione delle politiche:** definire e applicare le politiche di allocazione delle risorse per garantire equità ed efficienza.

Autenticazione e autorizzazione

Run:ai fornisce meccanismi di autenticazione e autorizzazione sicuri per controllare l'accesso alle risorse e ai dati sensibili. Ciò include:

* **Single Sign-On (SSO):** Integrazione con i provider di identità esistenti per un'autenticazione utente senza problemi.

* **Controllo degli accessi basato sui ruoli (RBAC):** definisci i ruoli con autorizzazioni specifiche, garantendo un controllo granulare sull'accesso alle risorse.

* **Autenticazione a più fattori (MFA):** Migliora la sicurezza richiedendo più fattori per l'accesso dell'utente.

Gestione multi-cluster

Run:ai consente la gestione di più cluster AI da un piano di controllo centrale. Ciò consente alle organizzazioni di:

* **Consolidare le risorse:** aggregare le risorse tra diversi cluster, fornendo una visione unificata della capacità disponibile.

* **Standardizza i flussi di lavoro:** applica policy e configurazioni coerenti su più cluster.

* **Ottimizza l'utilizzo:** Bilancia la distribuzione del carico di lavoro tra i cluster per un'allocazione ottimale delle risorse.

Dashboard e reporting

Run:ai fornisce potenti dashboard e strumenti di reporting per visualizzare le metriche chiave, monitorare le prestazioni del carico di lavoro e ottenere informazioni dettagliate sull'utilizzo delle risorse. Queste funzionalità includono:

* **Monitoraggio in tempo reale:** monitora l'utilizzo della GPU, l'avanzamento del carico di lavoro e l'utilizzo delle risorse in tempo reale.

* **Analisi storica:** analizza i dati storici per identificare tendenze, ottimizzare l'allocazione delle risorse e migliorare le prestazioni del carico di lavoro.

* **Dashboard personalizzabili:** Crea dashboard personalizzati su misura per esigenze e prospettive specifiche.

Gestione dei carichi di lavoro

Run:ai semplifica la gestione dei carichi di lavoro dell'intelligenza artificiale, tra cui:

* **Pianificazione:** automatizza la pianificazione e l'esecuzione dei lavori di formazione e inferenza.

* **Priorità:** Assegna priorità ai carichi di lavoro per garantire che le attività critiche vengano completate per prime.

* **Allocazione delle risorse:** Assegna le risorse (GPU, CPU, memoria) ai carichi di lavoro in base alle loro esigenze e priorità.

Politica di accesso alle risorse

Run:ai offre un motore flessibile di policy di accesso alle risorse che consente alle organizzazioni di definire e applicare regole che governano il modo in cui gli utenti possono accedere e utilizzare le risorse del cluster. Ciò consente:

* **Assegnazione equa della condivisione:** garantisce che le risorse siano assegnate equamente tra utenti e team.

* **Gestione delle quote:** imposta limiti sull'utilizzo delle risorse per evitare un consumo eccessivo e garantire un'allocazione efficiente.

* **Applicazione della priorità:** assegna la priorità all'accesso alle risorse in base ai ruoli utente o all'importanza del carico di lavoro.

Policy sui carichi di lavoro

Run:ai supporta la creazione di policy sui carichi di lavoro, definendo regole e linee guida per la gestione dei carichi di lavoro AI. Ciò consente alle organizzazioni di:

* **Standardizzare i flussi di lavoro:** stabilire flussi di lavoro coerenti e best practice per l'esecuzione di carichi di lavoro IA.

* **Automazione delle attività:** automatizza le operazioni comuni di gestione del carico di lavoro, come l'allocazione e la pianificazione delle risorse.

* **Migliora la sicurezza:** applica policy per garantire la conformità agli standard e alle normative sulla sicurezza.

Autorizzazione e controllo degli accessi

Run:ai utilizza robusti meccanismi di autorizzazione e controllo degli accessi per proteggere l'accesso a risorse e dati, tra cui:

* **Autorizzazioni granulari:* * Concedi autorizzazioni specifiche a utenti o gruppi, fornendo un controllo granulare sull'accesso alle risorse.

* **Controllo e registrazione:** monitora le azioni degli utenti e i modelli di accesso, fornendo un percorso di controllo per scopi di sicurezza e conformità.

* **Integrazione con gli strumenti di sicurezza esistenti:** Integra Run:ai con i sistemi di sicurezza esistenti per la gestione e il controllo centralizzati.

AI Workload Scheduler

AI Workload Scheduler di Run:ai è progettato specificamente per ottimizzare la gestione delle risorse per l'intero ciclo di vita dell'AI, consentendoti di:

* **Pianificazione dinamica:* * Assegna dinamicamente le risorse ai carichi di lavoro in base alle esigenze e alle priorità attuali.

* **Pooling GPU:** Consolida le risorse GPU in pool, consentendo un'allocazione flessibile a carichi di lavoro diversi.

* **Pianificazione prioritaria:** assicurati che alle attività critiche vengano assegnate per prime le risorse, ottimizzando il throughput complessivo del cluster AI.

Pool di nodi

Run:ai introduce il concetto di pool di nodi, consentendo alle organizzazioni di gestire facilmente cluster IA eterogenei. Questa funzionalità fornisce:

* **Configurazione del cluster:** definire quote, priorità e policy a livello di pool di nodi per gestire l'allocazione delle risorse.

* **Gestione delle risorse:** garantisci un'allocazione equa ed efficiente delle risorse all'interno del cluster, considerando fattori come il tipo di GPU, la memoria e i core della CPU.

* **Distribuzione del carico di lavoro:** Assegna i carichi di lavoro ai pool di nodi appropriati in base ai requisiti di risorse.

Container Orchestration

Run:ai si integra perfettamente con le piattaforme di orchestrazione dei container come Kubernetes, consentendo l'implementazione e la gestione di carichi di lavoro AI containerizzati distribuiti. Ciò fornisce:

* **Ridimensionamento automatizzato:** Aumenta o diminuisci i carichi di lavoro AI in modo fluido in base alla domanda.

* **Disponibilità elevata:** Assicurati che i carichi di lavoro IA rimangano disponibili anche in caso di guasto dei singoli nodi.

* **Implementazione semplificata:** Distribuisci e gestisci carichi di lavoro AI utilizzando immagini containerizzate, promuovendo portabilità e riproducibilità.

GPU Fractioning

La tecnologia GPU Fractioning di Run:ai ti consente di dividere una singola GPU in più frazioni, fornendo un modo conveniente per eseguire carichi di lavoro che richiedono solo una parte della GPU risorse. Questa funzionalità:

* **Aumenta l'efficienza in termini di costi:** consente di eseguire più carichi di lavoro sulla stessa infrastruttura condividendo le risorse GPU.

* **Semplifica la gestione delle risorse:** Semplifica l'allocazione delle risorse GPU a carichi di lavoro diversi con requisiti diversi.

* **Migliora l'utilizzo:** Massimizza l'utilizzo delle GPU, riducendo i tempi di inattività e aumentando l'efficienza.

Nodi GPU

Run:ai supporta un'ampia gamma di nodi GPU dei principali fornitori, tra cui NVIDIA, AMD e Intel. Ciò garantisce la compatibilità con una varietà di configurazioni hardware e consente alle organizzazioni di utilizzare l'infrastruttura esistente o selezionare le GPU più adatte alle proprie esigenze specifiche.

Nodi CPU

Oltre ai nodi GPU, Run :ai supporta anche i nodi CPU per attività che non richiedono l'accelerazione GPU. Ciò consente alle organizzazioni di sfruttare l'infrastruttura CPU esistente o di utilizzare risorse CPU più convenienti per attività specifiche.

Storage

Run:ai si integra con varie soluzioni di storage, tra cui NFS, GlusterFS, ceph e dischi locali. Questa flessibilità consente alle organizzazioni di scegliere una soluzione di archiviazione che meglio soddisfa i loro requisiti di prestazioni, scalabilità e costi.

Rete

Run:ai è progettato per funzionare in modo efficiente su reti a larghezza di banda elevata, consentendo la trasmissione efficiente di dati tra nodi e l’esecuzione di carichi di lavoro IA distribuiti. Run:ai può essere implementato anche in ambienti air-gap, dove non è disponibile connettività Internet, garantendo la sicurezza e l'isolamento dei dati sensibili.

Notebook on Demand

Notebook di Run:ai La funzionalità on Demand consente agli utenti di avviare spazi di lavoro preconfigurati con i loro strumenti e framework preferiti, tra cui Jupyter Notebook, PyCharm e VS Code. Questo:

* **Semplifica la configurazione:** Avvia rapidamente le aree di lavoro senza la necessità di installare manualmente le dipendenze.

* **Garantisce coerenza:** Fornisce ambienti coerenti tra team e progetti.

* **Migliora la collaborazione:** condividi e collabora facilmente sugli spazi di lavoro con i membri del team.

Formazione e messa a punto

Run:ai semplifica il processo di formazione e messa a punto dei modelli IA:

* **Coda di lavori batch:** Pianifica ed esegui batch lavori di training con un'unica riga di comando.

* **Formazione distribuita:** addestra in modo efficace i modelli su set di dati di grandi dimensioni su più GPU.

* **Ottimizzazione del modello:** ottimizza i parametri di allenamento e gli iperparametri per migliorare le prestazioni.

LLM privati

Run:ai consente agli utenti di distribuire e gestire i propri LLM privati, modelli personalizzati che possono essere utilizzati per applicazioni specifiche. Ciò consente:

* **Distribuzione del modello:** distribuisce modelli LLM per l'inferenza e genera risposte personalizzate.

* **Gestione dei modelli:** Archivia, versione e gestisci i modelli LLM per un facile accesso e aggiornamenti.

* **Privacy dei dati:** mantieni i dati degli utenti riservati e sicuri all'interno dell'infrastruttura dell'organizzazione.

Bundle NVIDIA e Run:ai

Run:ai e NVIDIA hanno collaborato per offrire una soluzione completamente integrata per i sistemi DGX, offrendo la soluzione full-stack più performante per i carichi di lavoro AI. Questo pacchetto:

* **Ottimizza le prestazioni DGX:** Sfrutta le funzionalità di Run:ai per massimizzare l'utilizzo e le prestazioni dell'hardware DGX.

* **Semplifica la gestione:** fornisce un'unica piattaforma per la gestione delle risorse DGX e dei carichi di lavoro AI.

* **Accelera lo sviluppo dell'intelligenza artificiale:** consente alle organizzazioni di accelerare le proprie iniziative di intelligenza artificiale con una soluzione coerente.

Implementa sulla tua infrastruttura; Nuvola. In sede. Air-Gapped.

Run:ai supporta un'ampia gamma di ambienti di distribuzione, offrendo opzioni flessibili per organizzazioni con diversi requisiti infrastrutturali. Ciò include:

* **Distribuzioni cloud:** Distribuisci Run:ai sui principali provider cloud, come AWS, Azure e Google Cloud, consentendoti di sfruttare i loro servizi e risorse.

* **Distribuzioni locali:** Distribuisci Run:ai sulla tua infrastruttura hardware, fornendo il controllo completo sul tuo ambiente AI.

* **Distribuzioni air-gapped:** Distribuisci Run:ai in ambienti isolati senza connettività Internet, garantendo la sicurezza e l'integrità dei tuoi dati.

Qualsiasi strumento e framework ML

Run:ai è progettato per funzionare con un'ampia gamma di strumenti e framework di machine learning, tra cui:

* **TensorFlow:** Run e gestire i carichi di lavoro TensorFlow in modo efficace.

* **PyTorch:** Distribuisci e ottimizza i modelli PyTorch per l'addestramento e l'inferenza.

* **JAX:** Utilizza JAX per calcoli IA ad alte prestazioni.

* **Keras:** Costruisci e addestra modelli Keras senza problemi.

* **Scikit-learn:** utilizza Scikit-learn per attività di machine learning.

* **XGBoost:** Sfrutta XGBoost per algoritmi di potenziamento del gradiente.

* **LightGBM:** Distribuisci LightGBM per un efficiente potenziamento del gradiente.

* **CatBoost:** Utilizza CatBoost per un potente potenziamento del gradiente.

Qualsiasi Kubernetes

Run:ai si integra perfettamente con Kubernetes, la principale piattaforma di orchestrazione dei container. Ciò garantisce la compatibilità con gli ambienti Kubernetes esistenti e consente alle organizzazioni di sfruttarne i vantaggi, tra cui:

* **Ridimensionamento automatizzato:** ridimensiona i carichi di lavoro AI in modo dinamico in base alla domanda.

* **Disponibilità elevata:** Assicurati che i carichi di lavoro IA rimangano disponibili anche in caso di guasto dei singoli nodi.

* **Implementazioni in container:** distribuisci carichi di lavoro AI come contenitori, promuovendo portabilità e riproducibilità.

Ovunque

Run:ai è progettato per essere distribuito ovunque, offrendo flessibilità alle organizzazioni con diverse esigenze infrastrutturali. Ciò include:

* **Data center:** Distribuisci Run:ai nei tuoi data center per il massimo controllo e sicurezza.

* **Fornitori cloud:** Distribuisci Run:ai sui principali fornitori cloud per scalabilità e flessibilità.

* **Dispositivi edge:** Distribuisci Run:ai sui dispositivi edge per applicazioni IA in tempo reale.

Qualsiasi infrastruttura

Run:ai supporta un'ampia gamma di componenti infrastrutturali, consentendoti di creare il tuo ambiente AI ideale:

* **GPU:** sfrutta le prestazioni elevate GPU dei principali fornitori, come NVIDIA, AMD e Intel.

* **CPU:** utilizza le CPU per attività che non richiedono l'accelerazione GPU.

* **ASIC:** Integra ASIC per attività specializzate, come l'inferenza del machine learning.

* **Archiviazione:** scegli le soluzioni di archiviazione che meglio soddisfano i tuoi requisiti di prestazioni, scalabilità e costi.

* **Rete:** Distribuisci Run:ai su reti a larghezza di banda elevata per una trasmissione efficiente dei dati e carichi di lavoro distribuiti.

FAQFAQ

// * **Cloud:** Run:ai può essere distribuito su qualsiasi principale provider cloud, inclusi AWS, Azure e GCP.

// * **On-Prem:** Run:ai può essere distribuito anche on-premise, consentendo alle organizzazioni di mantenere i propri dati e carichi di lavoro al sicuro all'interno dei propri data center.

// * **Air-gapped:** Run:ai può essere implementato anche in ambienti air-gapped, ovvero ambienti non connessi a Internet. Ciò consente alle organizzazioni di distribuire carichi di lavoro AI in ambienti in cui sono presenti severi requisiti di sicurezza.//

// * **Inferenza:** Run: ai può essere utilizzato per eseguire carichi di lavoro di inferenza su GPU, il che può aiutare a migliorare le prestazioni delle applicazioni AI.//

// * **Ricerca e sviluppo:** Run:ai può essere utilizzato per supportare le attività di ricerca e sviluppo fornendo una potente piattaforma per la gestione e l'implementazione dei carichi di lavoro AI.//

// * **Apprendimento profondo:** Run:ai può essere utilizzato per addestrare e implementare modelli di deep learning, che stanno diventando sempre più popolari per una vasta gamma di applicazioni.//

//

Per ulteriori informazioni, contatta il nostro team [email protected] Siamo felici di rispondere alle tue domande e aiutarti a ottenere iniziato con Run:ai.//

Traffico del Sito

Nessun Dato

Prodotti Alternativi

Cohesive

Scrittura di Blog e Articoli

Crea contenuti magici con il più potente editor di intelligenza artificiale

AI改写

Scrittura di Blog e Articoli

Benvenuto in Aigaixie, uno strumento per la creazione di contenuti basato sull'intelligenza artificiale

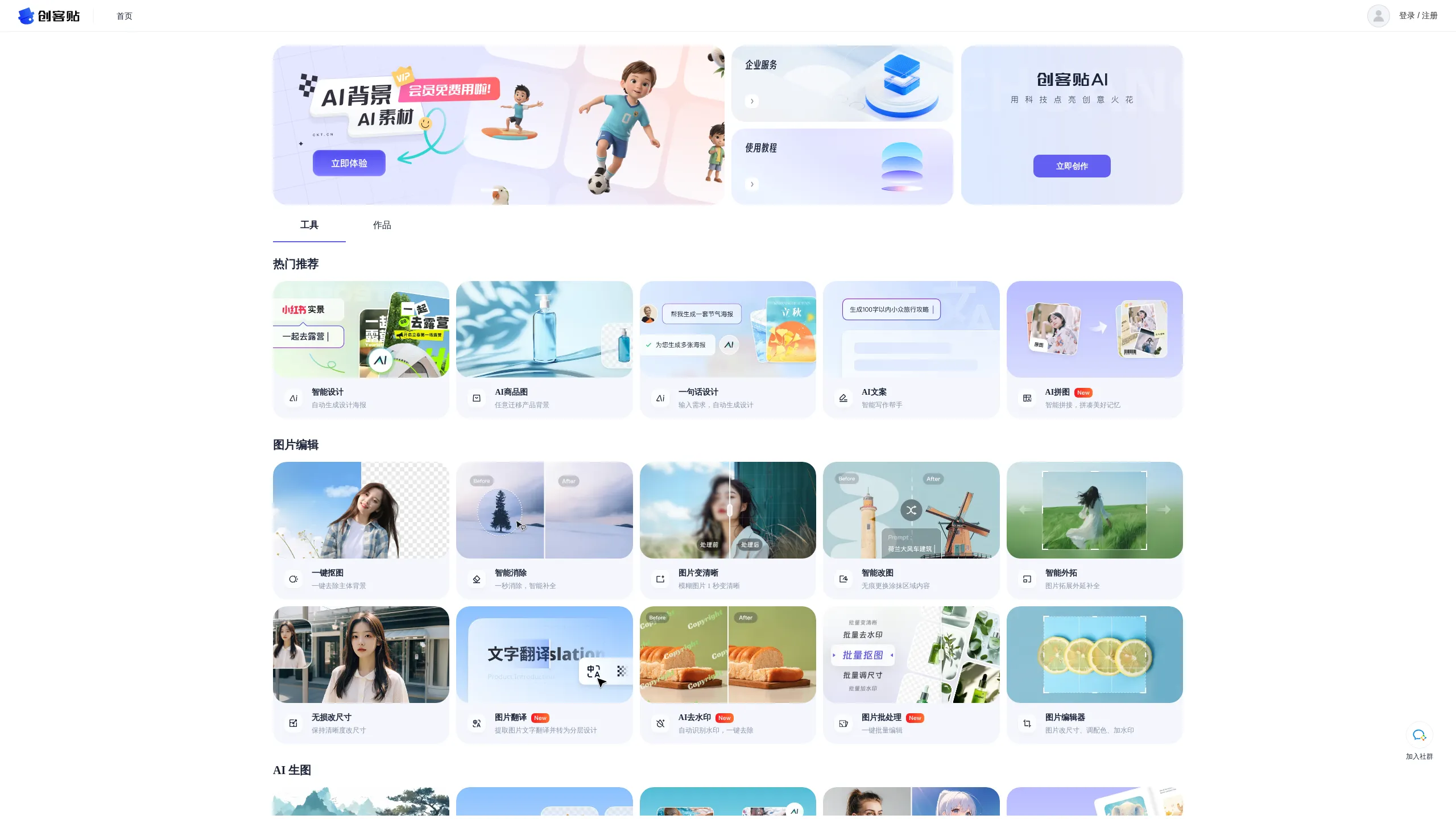

Alimama Creative

Assistenza al design

Alimama Creative Center - Potenzia la tua creatività di marketing

绘AI

Generazione di immagini

Ai Drawing

AI Art

Generazione di immagini

Piattaforma di creazione grafica AI

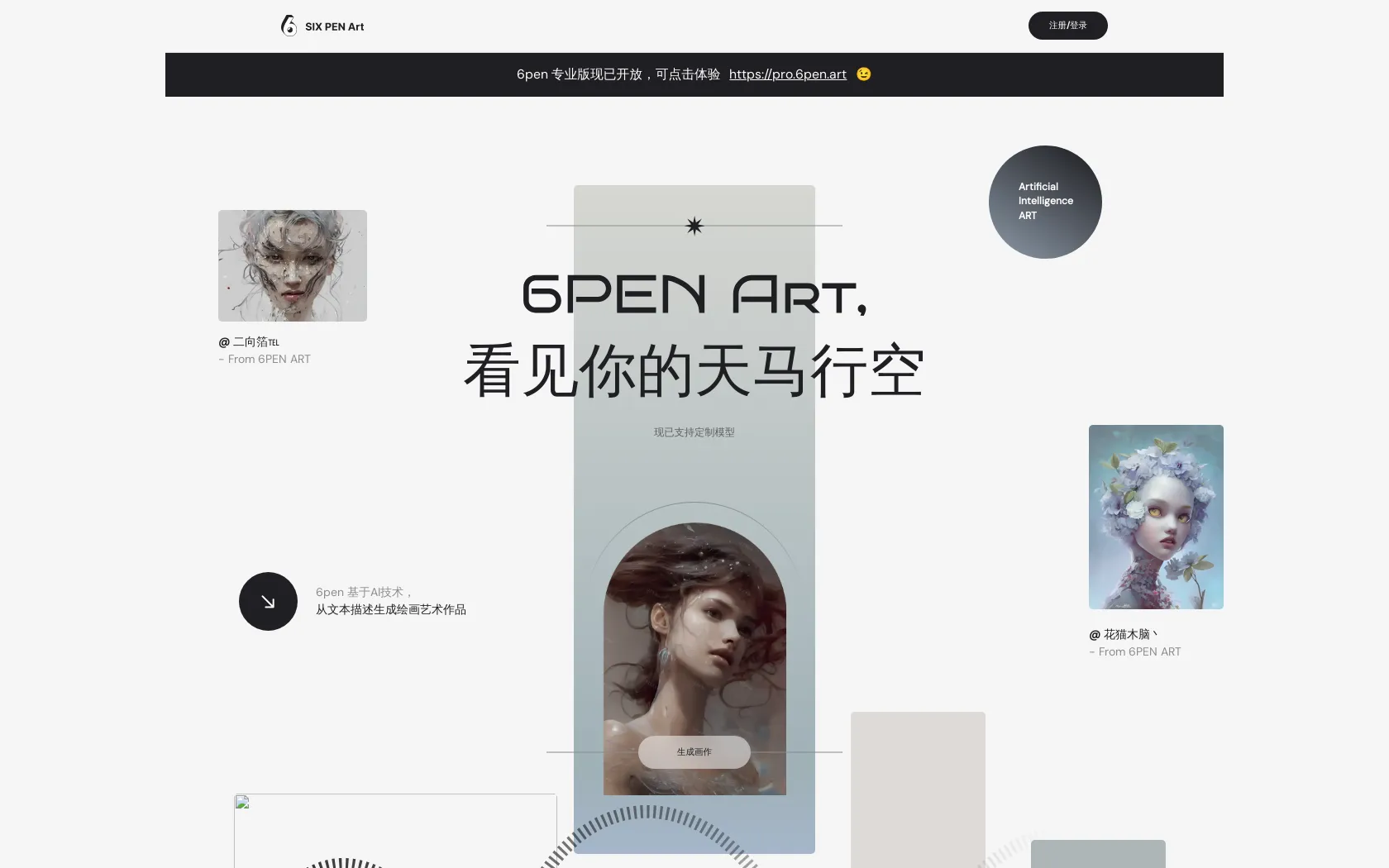

6pen Art

Generazione di immagini

Trasforma la tua immaginazione in arte