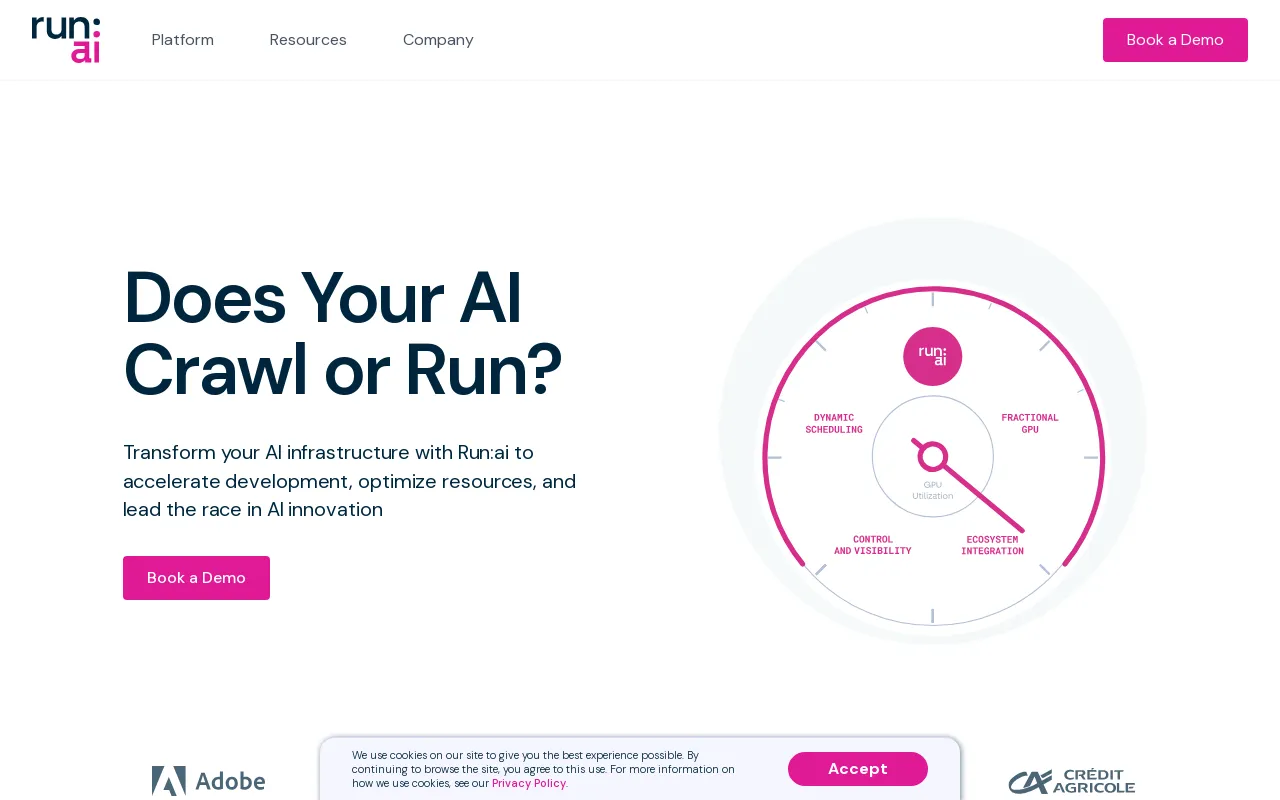

Détails de Run:ai

Informations sur le produit

Site Web

https://www.run.aiCatégorie

Chatbot conversationnelLocalisation

New York, New York, États-Unis Tel-Aviv, Israël

Description du produit

Exécuter :ai Dev

Accélérer le développement de l'IA et les délais de mise sur le marché

- Lancez des espaces de travail personnalisés avec vos outils et frameworks préférés.

- Mettez en file d'attente les tâches par lots et exécutez une formation distribuée avec une seule ligne de commande.

- Déployez et gérez vos modèles d'inférence à partir d'un seul endroit.

Écosystème

Améliorez la disponibilité du GPU et multipliez le retour sur investissement de votre IA

- Charges de travail

- Actifs

- Métriques

- Administrateur

- Authentification et autorisation

Exécuter :API ai

- Charges de travail

- Actifs

- Métriques

- Administrateur

- Authentification et autorisation

Exécuter : plan de contrôle ai

Déployez sur votre propre infrastructure ; Nuage. Sur site. Espace d'air.

- Gestion multicluster

- Tableaux de bord et rapports

- Gestion de la charge de travail

- Règle d'accès aux ressources

- Règle de charge de travail

- Autorisation et contrôle d'accès

Exécuter :ai Cluster Engine

Découvrez votre nouveau cluster d'IA ; Utilisé. Évolutif. Sous contrôle.

- Planificateur de charge de travail AI

- Regroupement de nœuds

- Orchestration des conteneurs

- Fractionnement GPU

- Nœuds GPU

- Nœuds CPU

- Stockage

- Réseau

CLI et GUI

Run:ai fournit une interface de ligne de commande (CLI) conviviale et une interface utilisateur graphique (GUI) complète pour gérer vos charges de travail et votre infrastructure d'IA. La CLI offre des fonctionnalités avancées de contrôle et de script, tandis que l'interface graphique offre une expérience visuelle intuitive pour surveiller, configurer et interagir avec la plate-forme.

Espaces de travail

Les espaces de travail sont des environnements isolés dans lesquels les praticiens de l'IA peuvent travailler sur leurs projets. Ces espaces de travail sont préconfigurés avec les outils, bibliothèques et dépendances nécessaires, simplifiant le processus de configuration et garantissant la cohérence entre les équipes. Les espaces de travail peuvent être personnalisés pour répondre aux exigences spécifiques du projet et peuvent être facilement clonés ou partagés avec des collaborateurs.

Outils

Run:ai fournit une suite d'outils conçus pour améliorer l'efficacité et la productivité de Développement de l'IA. Les outils offrent des fonctionnalités telles que l'intégration de Jupyter Notebook, la visualisation TensorBoard et le suivi des modèles. Ces outils rationalisent les flux de travail, simplifient l'analyse des données et améliorent la collaboration entre les membres de l'équipe.

Frameworks Open Source

Run:ai prend en charge un large éventail de frameworks d'IA open source populaires, notamment TensorFlow. , PyTorch, JAX et Keras. Cela permet aux développeurs d'exploiter leurs outils et bibliothèques préférés sans avoir besoin d'adapter leur base de code existante à une plate-forme spécialisée.

Catalogue LLM

Run:ai propose un catalogue LLM, une collection organisée de les grands modèles linguistiques (LLM) populaires et leurs configurations correspondantes. Ce catalogue facilite le déploiement et l'expérimentation de LLM de pointe, accélérant ainsi le développement d'applications d'IA qui exploitent des capacités avancées de traitement du langage.

Charges de travail

The Run : ai platform permet une gestion efficace de diverses charges de travail d'IA, notamment :

* **Formation :** Run:ai optimise les tâches de formation distribuées, vous permettant d'entraîner efficacement des modèles sur de grands ensembles de données sur plusieurs GPU.

* **Inférence :** Run:ai rationalise le déploiement et l'inférence de modèles, vous permettant de déployer des modèles pour des prédictions en temps réel ou un traitement par lots.

* **Fermes de notebooks :** Run:ai prend en charge la création et la gestion de fermes de notebooks évolutives, fournissant un environnement collaboratif pour l'exploration des données et le prototypage de modèles.

* **Projets de recherche :** Run:ai est conçu pour faciliter les activités de recherche, offrant une plate-forme d'expérimentation de nouveaux modèles, algorithmes et techniques.

Actifs

Run:ai permet aux utilisateurs de gérer et de partager des actifs d'IA, notamment :

* **Modèles :** Stockez et versionnez des modèles entraînés pour un accès et un déploiement faciles.

* **Ensembles de données :** Stockez et gérez de grands ensembles de données pour une utilisation efficace dans les tâches de formation.

* **Code :** Partagez et collaborez sur du code lié aux projets d'IA.

* **Expériences :** Suivez et comparez les résultats de différentes expériences d'IA.

Metrics

Run:ai fournit des fonctionnalités complètes de surveillance et de reporting, permettant aux utilisateurs de suivre les indicateurs clés liés à leurs charges de travail et à leur infrastructure d'IA. Cela inclut :

* **Utilisation du GPU :** Surveillez l'utilisation des GPU sur l'ensemble du cluster, garantissant une allocation efficace des ressources.

* **Performances de la charge de travail :** Suivez les performances des tâches de formation et d'inférence, en identifiant les goulots d'étranglement et les opportunités d'optimisation.

* **Consommation des ressources :** Surveillez l'utilisation du processeur, de la mémoire et du réseau, en fournissant des informations sur l'utilisation des ressources et les stratégies d'optimisation potentielles.

Admin

Run:ai propose des outils d'administration pour gérer la plateforme et ses utilisateurs, notamment :

* **Gestion des utilisateurs :** Contrôlez les droits d'accès et les autorisations des différents utilisateurs. ou des groupes.

* **Configuration du cluster :** Configurez les ressources matérielles et logicielles au sein du cluster AI.

* **Application des politiques :** Définissez et appliquez des politiques d'allocation des ressources pour garantir l'équité et l'efficacité.

Authentification et autorisation

Run:ai fournit des mécanismes d'authentification et d'autorisation sécurisés pour contrôler l'accès aux ressources et aux données sensibles. Cela inclut :

* **Authentification unique (SSO) :** Intégration aux fournisseurs d'identité existants pour une authentification transparente des utilisateurs.

* **Contrôle d'accès basé sur les rôles (RBAC) :** définissez des rôles avec des autorisations spécifiques, garantissant un contrôle granulaire sur l'accès aux ressources.

* **Authentification multifacteur (MFA) :** Améliorez la sécurité en exigeant plusieurs facteurs pour la connexion de l'utilisateur.

Gestion multi-cluster

Run:ai permet la gestion de plusieurs clusters d'IA à partir d'un plan de contrôle central. Cela permet aux organisations de :

* **Consolider les ressources :** Regrouper les ressources sur différents clusters, offrant ainsi une vue unifiée de la capacité disponible.

* **Standardisez les flux de travail :** Appliquez des politiques et des configurations cohérentes sur plusieurs clusters.

* **Optimiser l'utilisation :** Équilibrez la répartition de la charge de travail entre les clusters pour une allocation optimale des ressources.

Tableaux de bord et rapports

Run:ai fournit de puissants tableaux de bord et outils de reporting pour visualiser les indicateurs clés, suivre les performances de la charge de travail et obtenir des informations sur l'utilisation des ressources. Ces fonctionnalités incluent :

* **Surveillance en temps réel :** Suivez l'utilisation du GPU, la progression de la charge de travail et l'utilisation des ressources en temps réel.

* **Analyses historiques :** Analysez les données historiques pour identifier les tendances, optimiser l'allocation des ressources et améliorer les performances de la charge de travail.

* **Tableaux de bord personnalisables :** Créez des tableaux de bord personnalisés adaptés à des besoins et des perspectives spécifiques.

Gestion de la charge de travail

Run:ai simplifie la gestion des charges de travail d'IA, notamment :

* **Planification :** automatisez la planification et l'exécution des tâches de formation et d'inférence.

* **Priorisation :** attribuez des priorités aux charges de travail pour garantir que les tâches critiques sont terminées en premier.

* **Allocation de ressources :** allouez des ressources (GPU, CPU, mémoire) aux charges de travail en fonction de leurs besoins et priorités.

Politique d'accès aux ressources

Run:ai propose un moteur de politique d'accès aux ressources flexible qui permet aux organisations de définir et d'appliquer des règles régissant la manière dont les utilisateurs peuvent accéder et utiliser les ressources du cluster. Cela permet :

* **Allocation de partage équitable :** garantissez que les ressources sont allouées équitablement entre les utilisateurs et les équipes.

* **Gestion des quotas :** définissez des limites sur l'utilisation des ressources pour éviter la surconsommation et garantir une allocation efficace.

* **Application des priorités :** hiérarchisez l'accès aux ressources en fonction des rôles des utilisateurs ou de l'importance de la charge de travail.

Politique de charge de travail

Run:ai prend en charge la création de politiques de charge de travail, définissant des règles et des directives pour la gestion des charges de travail d'IA. Cela permet aux organisations de :

* **Standardiser les flux de travail :** Établir des flux de travail cohérents et des bonnes pratiques pour exécuter des charges de travail d'IA.

* **Automatisez les tâches :** automatisez les opérations courantes de gestion de la charge de travail, telles que l'allocation des ressources et la planification.

* **Améliorez la sécurité :** Appliquez des politiques pour garantir la conformité aux normes et réglementations de sécurité.

Autorisation et contrôle d'accès

Run:ai utilise des mécanismes d'autorisation et de contrôle d'accès robustes pour sécuriser l'accès aux ressources et aux données, notamment :

* **Autorisations précises :* * Accordez des autorisations spécifiques à des utilisateurs ou à des groupes, offrant un contrôle granulaire sur l'accès aux ressources.

* **Audit et journalisation :** Suivez les actions des utilisateurs et les modèles d'accès, fournissant ainsi une piste d'audit à des fins de sécurité et de conformité.

* **Intégration avec les outils de sécurité existants :** Intégrez Run:ai aux systèmes de sécurité existants pour une gestion et un contrôle centralisés.

AI Workload Scheduler

AI Workload Scheduler de Run:ai est spécialement conçu pour optimiser la gestion des ressources pendant tout le cycle de vie de l'IA, vous permettant de :

* **Planification dynamique :* * Allouez dynamiquement des ressources aux charges de travail en fonction des besoins et des priorités actuels.

* **Regroupement de GPU :** Consolidez les ressources GPU dans des pools, permettant une allocation flexible à diverses charges de travail.

* **Planification prioritaire :** Assurez-vous que les tâches critiques se voient attribuer des ressources en premier, optimisant ainsi le débit global du cluster IA.

Node Pooling

Run:ai introduit le concept de Node Pooling, permettant aux organisations de gérer facilement des clusters d'IA hétérogènes. Cette fonctionnalité fournit :

* **Configuration du cluster :** Définissez des quotas, des priorités et des politiques au niveau du pool de nœuds pour gérer l'allocation des ressources.

* **Gestion des ressources :** garantissez une allocation juste et efficace des ressources au sein du cluster, en tenant compte de facteurs tels que le type de GPU, la mémoire et les cœurs de processeur.

* **Répartition de la charge de travail :** allouez les charges de travail aux pools de nœuds appropriés en fonction de leurs besoins en ressources.

Container Orchestration

Run:ai s'intègre de manière transparente aux plates-formes d'orchestration de conteneurs telles que Kubernetes, permettant le déploiement et la gestion de charges de travail d'IA conteneurisées distribuées. Cela fournit :

* **Mise à l'échelle automatisée :** Augmentez ou diminuez les charges de travail d'IA de manière transparente en fonction de la demande.

* **Haute disponibilité :** Assurez-vous que les charges de travail d'IA restent disponibles même en cas de défaillance de nœuds individuels.

* **Déploiement simplifié :** Déployez et gérez des charges de travail d'IA à l'aide d'images conteneurisées, favorisant ainsi la portabilité et la reproductibilité.

Fractionnement GPU

La technologie de fractionnement GPU de Run:ai vous permet de diviser un seul GPU en plusieurs fractions, offrant ainsi un moyen rentable d'exécuter des charges de travail qui ne nécessitent qu'une partie de la puissance d'un GPU. ressources. Cette fonctionnalité :

* **Augmente la rentabilité :** Vous permet d'exécuter davantage de charges de travail sur la même infrastructure en partageant les ressources GPU.

* **Simplifie la gestion des ressources :** rationalise l'allocation des ressources GPU à diverses charges de travail avec des exigences variables.

* **Améliore l'utilisation :** Maximise l'utilisation des GPU, réduisant ainsi les temps d'inactivité et augmentant l'efficacité.

Nœuds GPU

Run:ai prend en charge une large gamme de nœuds GPU des principaux fournisseurs, notamment NVIDIA, AMD et Intel. Cela garantit la compatibilité avec une variété de configurations matérielles et permet aux organisations d'utiliser l'infrastructure existante ou de sélectionner les GPU les plus adaptés à leurs besoins spécifiques.

Nœuds CPU

En plus des nœuds GPU, exécutez :ai prend également en charge les nœuds CPU pour les tâches qui ne nécessitent pas d'accélération GPU. Cela permet aux organisations d'exploiter l'infrastructure CPU existante ou d'utiliser des ressources CPU plus rentables pour des tâches spécifiques.

Stockage

Run:ai s'intègre à diverses solutions de stockage, notamment NFS, GlusterFS, ceph. et les disques locaux. Cette flexibilité permet aux organisations de choisir la solution de stockage qui répond le mieux à leurs exigences en matière de performances, d'évolutivité et de coûts.

Réseau

Run:ai est conçu pour fonctionner efficacement sur les réseaux à large bande passante, permettant la transmission efficace des données entre les nœuds et l’exécution de charges de travail d’IA distribuées. Run:ai peut également être déployé dans des environnements isolés, où il n'y a pas de connectivité Internet, garantissant ainsi la sécurité et l'isolement des données sensibles.

Ordinateurs portables à la demande

Les ordinateurs portables de Run:ai La fonctionnalité à la demande permet aux utilisateurs de lancer des espaces de travail préconfigurés avec leurs outils et frameworks préférés, notamment Jupyter Notebook, PyCharm et VS Code. Ceci :

* **Simplifie la configuration :** Lancez rapidement des espaces de travail sans avoir besoin d'installer manuellement les dépendances.

* **Garantit la cohérence :** Fournit des environnements cohérents entre les équipes et les projets.

* **Améliore la collaboration :** Partagez et collaborez en toute transparence sur des espaces de travail avec les membres de l'équipe.

Formation et réglage fin

Run:ai simplifie le processus de formation et de réglage fin des modèles d'IA :

* **Tâches par lots en file d'attente :** Planifiez et exécutez des lots tâches de formation avec une seule ligne de commande.

* **Formation distribuée :** Entraînez efficacement des modèles sur de grands ensembles de données sur plusieurs GPU.

* **Optimisation du modèle :** optimisez les paramètres et les hyperparamètres d'entraînement pour améliorer les performances.

LLM privés

Run:ai permet aux utilisateurs de déployer et de gérer leurs propres LLM privés, des modèles formés sur mesure qui peuvent être utilisés pour des applications spécifiques. Cela permet :

* **Déploiement de modèles :** Déployez des modèles LLM pour l'inférence et générez des réponses personnalisées.

* **Gestion des modèles :** Stockez, versionnez et gérez les modèles LLM pour un accès et des mises à jour faciles.

* **Confidentialité des données :** Gardez les données des utilisateurs confidentielles et sécurisées au sein de l'infrastructure de l'organisation.

NVIDIA & Run:ai Bundle

Run:ai et NVIDIA se sont associés pour offrir une solution entièrement intégrée pour les systèmes DGX, offrant ainsi la solution full-stack la plus performante pour les charges de travail d'IA. Cet ensemble :

* **Optimise les performances DGX :** Tire parti des capacités de Run:ai pour maximiser l'utilisation et les performances du matériel DGX.

* **Simplifie la gestion :** Fournit une plate-forme unique pour gérer les ressources DGX et les charges de travail d'IA.

* **Accélére le développement de l'IA :** Permet aux organisations d'accélérer leurs initiatives en matière d'IA avec une solution cohérente.

Déployez sur votre propre infrastructure ; Nuage. Sur site. Air-Gapped.

Run:ai prend en charge un large éventail d'environnements de déploiement, offrant des options flexibles aux organisations ayant des exigences d'infrastructure différentes. Cela inclut :

* **Déploiements cloud :** Déployez Run:ai sur les principaux fournisseurs cloud, tels qu'AWS, Azure et Google Cloud, vous permettant d'exploiter leurs services et ressources.

* **Déploiements sur site :** Déployez Run:ai sur votre propre infrastructure matérielle, offrant un contrôle complet sur votre environnement d'IA.

* **Déploiements isolés :** Déployez Run:ai dans des environnements isolés sans connectivité Internet, garantissant ainsi la sécurité et l'intégrité de vos données.

Tous les outils et frameworks de ML

Run:ai est conçu pour fonctionner avec un large éventail d'outils et de frameworks d'apprentissage automatique, notamment :

* **TensorFlow :** Run et gérez efficacement les charges de travail TensorFlow.

* **PyTorch :** Déployez et optimisez les modèles PyTorch pour la formation et l'inférence.

* **JAX :** Utilisez JAX pour les calculs d'IA hautes performances.

* **Keras :** Créez et entraînez des modèles Keras de manière transparente.

* **Scikit-learn :** Utilisez Scikit-learn pour les tâches d'apprentissage automatique.

* **XGBoost :** Tirez parti de XGBoost pour les algorithmes d'amélioration des gradients.

* **LightGBM :** Déployez LightGBM pour une amplification efficace des dégradés.

* **CatBoost :** Utilisez CatBoost pour une amplification de gradient robuste.

Tous les Kubernetes

Run:ai s'intègre de manière transparente à Kubernetes, la principale plateforme d'orchestration de conteneurs. Cela garantit la compatibilité avec les environnements Kubernetes existants et permet aux organisations de tirer parti de ses avantages, notamment :

* **Mise à l'échelle automatisée :** Faites évoluer les charges de travail d'IA de manière dynamique en fonction de la demande.

* **Haute disponibilité :** Assurez-vous que les charges de travail d'IA restent disponibles même en cas de défaillance de nœuds individuels.

* **Déploiements conteneurisés :** Déployez des charges de travail d'IA sous forme de conteneurs, favorisant ainsi la portabilité et la reproductibilité.

Partout

Run:ai est conçu pour être déployé n'importe où, offrant ainsi une flexibilité aux organisations ayant des besoins en infrastructure divers. Cela inclut :

* **Centres de données :** Déployez Run:ai dans vos propres centres de données pour un contrôle et une sécurité maximum.

* **Fournisseurs cloud :** Déployez Run:ai sur les principaux fournisseurs cloud pour plus d'évolutivité et de flexibilité.

* **Appareils Edge :** Déployez Run:ai sur les appareils Edge pour les applications d'IA en temps réel.

Toute infrastructure

Run:ai prend en charge un large éventail de composants d'infrastructure, vous permettant de créer votre environnement d'IA idéal :

* **GPU :** Tirez parti des hautes performances GPU des principaux fournisseurs, tels que NVIDIA, AMD et Intel.

* **CPU :** Utilisez les processeurs pour les tâches qui ne nécessitent pas d'accélération GPU.

* **ASIC :** intégrez des ASIC pour des tâches spécialisées, telles que l'inférence d'apprentissage automatique.

* **Stockage :** Choisissez les solutions de stockage qui répondent le mieux à vos exigences en matière de performances, d'évolutivité et de coûts.

* **Mise en réseau :** Déployez Run:ai sur des réseaux à large bande passante pour une transmission de données efficace et des charges de travail distribuées.

FAQFAQ

// * **Cloud :** Run:ai peut être déployé sur n'importe quel fournisseur cloud majeur, notamment AWS, Azure. et GCP.

// * **Sur site :** Run:ai peut également être déployé sur site, ce qui permet aux organisations de sécuriser leurs données et leurs charges de travail au sein de leurs propres centres de données.

// * **Air-Gapped :** Run:ai peut également être déployé dans des environnements à air isolé, qui sont des environnements qui ne sont pas connectés à Internet. Cela permet aux organisations de déployer des charges de travail d'IA dans des environnements où il existe des exigences de sécurité strictes.//

// * **Inférence :** Exécuter : ai peut être utilisé pour exécuter des charges de travail d'inférence sur des GPU, ce qui peut contribuer à améliorer les performances des applications d'IA.//

// * **Recherche et développement :** Run:ai peut être utilisé pour soutenir les efforts de recherche et développement en fournissant une plate-forme puissante pour gérer et déployer des charges de travail d'IA.//

// * **Apprentissage profond :** Run:ai peut être utilisé pour former et déployer des modèles d'apprentissage profond, qui deviennent de plus en plus populaires pour un large éventail d'applications.//

//

Pour plus d'informations, veuillez contacter notre équipe [email protected] Nous serons heureux de répondre à vos questions et de vous aider à obtenir commencé avec Run:ai.//

Trafic du site web

Aucune donnée

Produits Alternatifs

绘AI

Génération d'images

Ai Drawing

AI Art

Génération d'images

AI Graphic Creation Platform

360 AI

Génération d'images

L'IA crée de superbes œuvres d'art

Stockimg AI

Génération d'images

Arrêtez de perdre du temps sur la production de contenu. Essayez-le gratuitement dès maintenant et gérez vos réseaux sociaux avec l'IA !

6pen Art

Génération d'images

Transformez votre imagination en art

Beautiful.ai

Présentation

Présentation d'un logiciel de présentation générative d'IA pour le lieu de travail