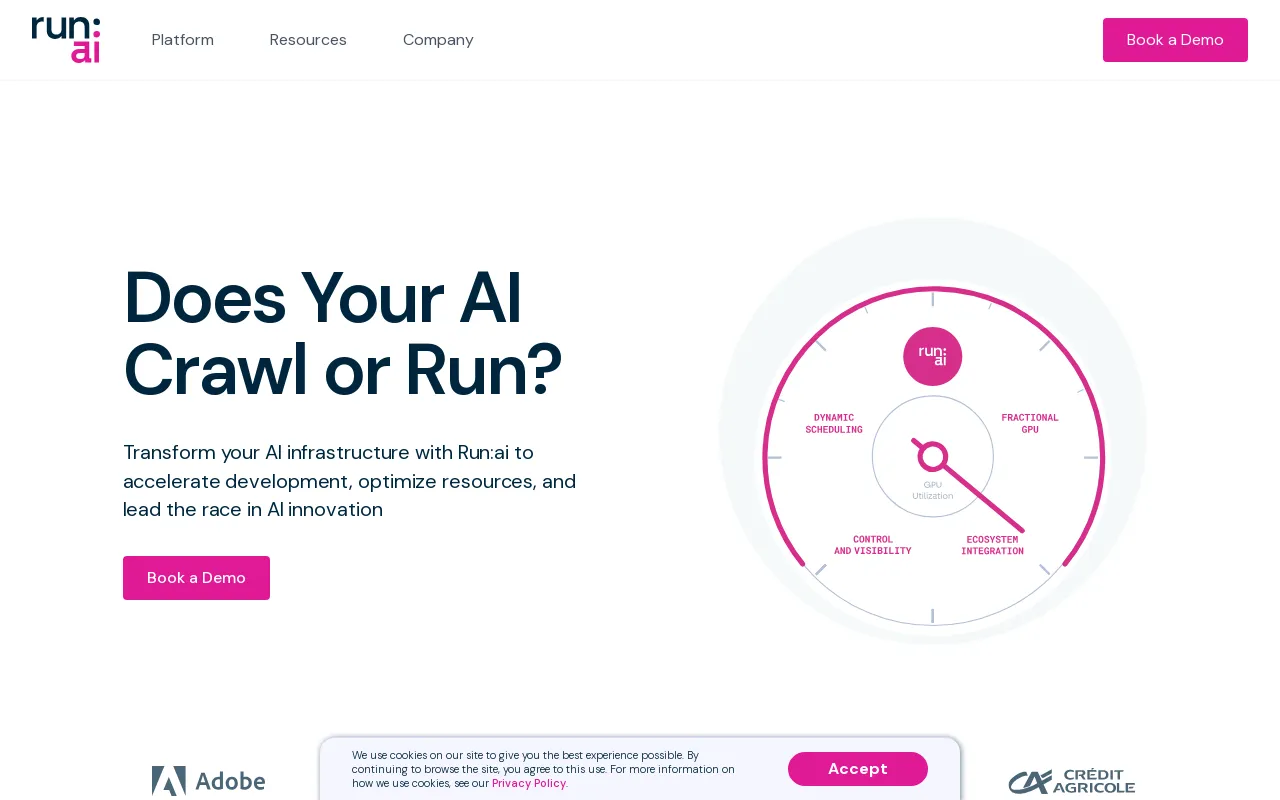

Detalles de Run:ai

Información del Producto

Sitio Web

https://www.run.aiCategoría

Chatbot conversacionalUbicación

Nueva York, Nueva York, Estados Unidos Israel

Descripción del Producto

Ejecutar:ai Dev

Acelerar el desarrollo de la IA y el tiempo de comercialización

- Inicie espacios de trabajo personalizados con sus herramientas y marcos favoritos.

- Pone en cola trabajos por lotes y ejecuta capacitación distribuida con una única línea de comando.

- Implemente y administre sus modelos de inferencia desde un solo lugar.

Ecosistema

Aumente la disponibilidad de la GPU y multiplique el retorno de su inversión en IA

- Cargas de trabajo

- Activos

- Métricas

- Administrador

- Autenticación y autorización

Ejecutar:ai API

- Cargas de trabajo

- Activos

- Métricas

- Administrador

- Autenticación y autorización

Ejecutar:avión de control

Implemente en su propia infraestructura; Nube. En las instalaciones. Con espacios de aire.

- Gestión de múltiples clústeres

- Paneles de control e informes

- Gestión de carga de trabajo

- Política de acceso a recursos

- Política de carga de trabajo

- Autorización y control de acceso

Ejecutar:ai Cluster Engine

Conozca su nuevo grupo de IA; Utilizado. Escalable. Bajo control.

- Programador de cargas de trabajo de IA

- Agrupación de nodos

- Orquestación de contenedores

- Fraccionamiento de GPU

- Nodos GPU

- Nodos de CPU

- Almacenamiento

- Red

CLI y GUI

Run:ai proporciona una interfaz de línea de comandos (CLI) fácil de usar y una interfaz gráfica de usuario (GUI) integral para administrar sus cargas de trabajo e infraestructura de IA. La CLI ofrece capacidades avanzadas de control y secuencias de comandos, mientras que la GUI proporciona una experiencia visual intuitiva para monitorear, configurar e interactuar con la plataforma.

Espacios de trabajo

Los espacios de trabajo son entornos aislados donde los profesionales de la IA pueden trabajar en sus proyectos. Estos espacios de trabajo están preconfigurados con las herramientas, bibliotecas y dependencias necesarias, lo que simplifica el proceso de configuración y garantiza la coherencia entre los equipos. Los espacios de trabajo se pueden personalizar para cumplir con los requisitos específicos del proyecto y se pueden clonar o compartir fácilmente con colaboradores.

Herramientas

Run:ai proporciona un conjunto de herramientas diseñadas para mejorar la eficiencia y la productividad de Desarrollo de IA. Las herramientas ofrecen funciones como la integración de Jupyter Notebook, visualización de TensorBoard y seguimiento de modelos. Estas herramientas agilizan los flujos de trabajo, simplifican el análisis de datos y mejoran la colaboración entre los miembros del equipo.

Marcos de código abierto

Run:ai admite una amplia gama de marcos de IA de código abierto populares, incluido TensorFlow. , PyTorch, JAX y Keras. Esto permite a los desarrolladores aprovechar sus herramientas y bibliotecas preferidas sin necesidad de adaptar su código base existente a una plataforma especializada.

Catálogo LLM

Run:ai ofrece un catálogo LLM, una colección seleccionada de Modelos de lenguaje grande (LLM) populares y sus configuraciones correspondientes. Este catálogo facilita la implementación y la experimentación con LLM de última generación, acelerando el desarrollo de aplicaciones de IA que aprovechan las capacidades avanzadas de procesamiento del lenguaje.

Cargas de trabajo

La ejecución: La plataforma ai permite una gestión eficaz de diversas cargas de trabajo de IA, que incluyen:

* **Capacitación:** Run:ai optimiza los trabajos de capacitación distribuidos, lo que le permite entrenar modelos de manera efectiva en grandes conjuntos de datos en múltiples GPU.

* **Inferencia:** Run:ai agiliza la implementación y la inferencia de modelos, lo que le permite implementar modelos para predicciones en tiempo real o procesamiento por lotes.

* **Granjas de portátiles:** Run:ai admite la creación y gestión de granjas de portátiles escalables, proporcionando un entorno colaborativo para la exploración de datos y la creación de prototipos de modelos.

* **Proyectos de investigación:** Run:ai está diseñado para facilitar las actividades de investigación, ofreciendo una plataforma para la experimentación con nuevos modelos, algoritmos y técnicas.

Activos

Run:ai permite a los usuarios administrar y compartir activos de IA, incluidos:

* **Modelos:** Almacene y versione modelos capacitados para facilitar el acceso y la implementación.

* **Conjuntos de datos:** Almacene y administre grandes conjuntos de datos para un uso eficiente en trabajos de capacitación.

* **Código:** Comparta y colabore en código relacionado con proyectos de IA.

* **Experimentos:** Realice un seguimiento y compare los resultados de diferentes experimentos de IA.

Métricas

Run:ai proporciona capacidades integrales de monitoreo e informes, lo que permite a los usuarios realizar un seguimiento de métricas clave relacionadas con sus cargas de trabajo e infraestructura de IA. Esto incluye:

* **Utilización de GPU:** Supervise la utilización de GPU en todo el clúster, lo que garantiza una asignación eficiente de recursos.

* **Rendimiento de la carga de trabajo:** Realice un seguimiento del rendimiento de los trabajos de capacitación e inferencia, identificando cuellos de botella y oportunidades de optimización.

* **Consumo de recursos:** Supervise el uso de CPU, memoria y red, proporcionando información sobre la utilización de recursos y posibles estrategias de optimización.

Admin

Run:ai ofrece herramientas administrativas para gestionar la plataforma y sus usuarios, que incluyen:

* **Gestión de usuarios:** Controla los derechos de acceso y permisos para diferentes usuarios o grupos.

* **Configuración del clúster:** Configure los recursos de hardware y software dentro del clúster de IA.

* **Aplicación de políticas:** Definir y hacer cumplir políticas de asignación de recursos para garantizar la equidad y la eficiencia.

Autenticación y autorización

Run:ai proporciona mecanismos seguros de autenticación y autorización para controlar el acceso a recursos y datos confidenciales. Esto incluye:

* **Inicio de sesión único (SSO):** Integración con proveedores de identidad existentes para una autenticación de usuario perfecta.

* **Control de acceso basado en roles (RBAC):** Defina roles con permisos específicos, garantizando un control granular sobre el acceso a los recursos.

* **Autenticación multifactor (MFA):** Mejore la seguridad al requerir múltiples factores para el inicio de sesión del usuario.

Gestión de múltiples clústeres

Run:ai permite la gestión de múltiples clústeres de IA desde un plano de control central. Esto permite a las organizaciones:

* **Consolidar recursos:** Agregar recursos en diferentes clústeres, proporcionando una vista unificada de la capacidad disponible.

* **Estandarice los flujos de trabajo:** Aplique políticas y configuraciones consistentes en múltiples clústeres.

* **Optimice la utilización:** Equilibre la distribución de la carga de trabajo entre los clústeres para una asignación óptima de los recursos.

Paneles de control e informes

Run:ai proporciona potentes paneles de control y herramientas de generación de informes para visualizar métricas clave, realizar un seguimiento del rendimiento de la carga de trabajo y obtener información sobre la utilización de recursos. Estas capacidades incluyen:

* **Monitoreo en tiempo real:** Realice un seguimiento de la utilización de GPU, el progreso de la carga de trabajo y el uso de recursos en tiempo real.

* **Análisis histórico:** Analice datos históricos para identificar tendencias, optimizar la asignación de recursos y mejorar el rendimiento de la carga de trabajo.

* **Paneles de control personalizables:** Cree paneles de control personalizados adaptados a necesidades y perspectivas específicas.

Gestión de cargas de trabajo

Run:ai simplifica la gestión de cargas de trabajo de IA, que incluyen:

* **Programación:** Automatiza la programación y ejecución de trabajos de capacitación e inferencia.

* **Priorización:** Asigne prioridades a las cargas de trabajo para garantizar que las tareas críticas se completen primero.

* **Asignación de recursos:** Asigne recursos (GPU, CPU, memoria) a las cargas de trabajo según sus necesidades y prioridades.

Política de acceso a recursos

Run:ai ofrece un motor de políticas de acceso a recursos flexible que permite a las organizaciones definir y hacer cumplir reglas que rigen cómo los usuarios pueden acceder y utilizar los recursos del clúster. Esto permite:

* **Asignación equitativa:** Asegúrese de que los recursos se asignen de manera justa entre los usuarios y equipos.

* **Gestión de cuotas:** Establezca límites en el uso de recursos para evitar el consumo excesivo y garantizar una asignación eficiente.

* **Aplicación de prioridades:** Priorice el acceso a los recursos según los roles de los usuarios o la importancia de la carga de trabajo.

Política de carga de trabajo

Run:ai admite la creación de políticas de carga de trabajo, definiendo reglas y directrices para gestionar cargas de trabajo de IA. Esto permite a las organizaciones:

* **Estandarizar los flujos de trabajo:** Establecer flujos de trabajo consistentes y mejores prácticas para ejecutar cargas de trabajo de IA.

* **Automatizar tareas:** Automatizar operaciones comunes de administración de cargas de trabajo, como la asignación y programación de recursos.

* **Mejore la seguridad:** Aplique políticas para garantizar el cumplimiento de los estándares y regulaciones de seguridad.

Autorización y control de acceso

Run:ai emplea mecanismos sólidos de autorización y control de acceso para asegurar el acceso a recursos y datos, que incluyen:

* **Permisos específicos:* * Otorgar permisos específicos a usuarios o grupos, proporcionando control granular sobre el acceso a los recursos.

* **Auditoría y registro:** Realice un seguimiento de las acciones de los usuarios y los patrones de acceso, proporcionando un seguimiento de auditoría con fines de seguridad y cumplimiento.

* **Integración con herramientas de seguridad existentes:** Integre Run:ai con los sistemas de seguridad existentes para una gestión y control centralizados.

Programador de carga de trabajo AI

El Programador de carga de trabajo AI de Run:ai está diseñado específicamente para optimizar la gestión de recursos para todo el ciclo de vida de la IA, lo que le permite:

* **Programación dinámica:* * Asigne dinámicamente recursos a cargas de trabajo según las necesidades y prioridades actuales.

* **Agrupación de GPU:** Consolide los recursos de GPU en grupos, lo que permite una asignación flexible a diversas cargas de trabajo.

* **Programación de prioridades:** Asegúrese de que a las tareas críticas se les asignen recursos primero, optimizando el rendimiento general del clúster de IA.

Node Pooling

Run:ai presenta el concepto de Node Pooling, que permite a las organizaciones gestionar clústeres heterogéneos de IA con facilidad. Esta característica proporciona:

* **Configuración de clúster:** Defina cuotas, prioridades y políticas en el nivel del grupo de nodos para administrar la asignación de recursos.

* **Administración de recursos:** Garantice una asignación justa y eficiente de recursos dentro del clúster, considerando factores como el tipo de GPU, la memoria y los núcleos de CPU.

* **Distribución de carga de trabajo:** Asigne cargas de trabajo a los grupos de nodos adecuados según sus requisitos de recursos.

Orquestación de contenedores

Run:ai se integra perfectamente con plataformas de orquestación de contenedores como Kubernetes, lo que permite la implementación y gestión de cargas de trabajo de IA distribuidas en contenedores. Esto proporciona:

* **Escalado automatizado:** Aumente o reduzca las cargas de trabajo de IA sin problemas según la demanda.

* **Alta disponibilidad:** Asegúrese de que las cargas de trabajo de IA permanezcan disponibles incluso si fallan los nodos individuales.

* **Implementación simplificada:** Implemente y administre cargas de trabajo de IA utilizando imágenes en contenedores, promoviendo la portabilidad y reproducibilidad.

Fraccionamiento de GPU

La tecnología de fraccionamiento de GPU de Run:ai le permite dividir una sola GPU en múltiples fracciones, lo que proporciona una forma rentable de ejecutar cargas de trabajo que requieren solo una parte de la GPU. recursos. Esta característica:

* **Aumenta la rentabilidad:** Le permite ejecutar más cargas de trabajo en la misma infraestructura al compartir recursos de GPU.

* **Simplifica la administración de recursos:** Agiliza la asignación de recursos de GPU a diversas cargas de trabajo con diferentes requisitos.

* **Mejora la utilización:** Maximiza la utilización de las GPU, reduciendo el tiempo de inactividad y aumentando la eficiencia.

Nodos GPU

Run:ai admite una amplia gama de nodos GPU de proveedores líderes, incluidos NVIDIA, AMD e Intel. Esto garantiza la compatibilidad con una variedad de configuraciones de hardware y permite a las organizaciones utilizar la infraestructura existente o seleccionar las GPU más adecuadas para sus necesidades específicas.

Nodos de CPU

Además de los nodos de GPU, Ejecute :ai también admite nodos de CPU para tareas que no requieren aceleración de GPU. Esto permite a las organizaciones aprovechar la infraestructura de CPU existente o utilizar recursos de CPU más rentables para tareas específicas.

Almacenamiento

Run:ai se integra con varias soluciones de almacenamiento, incluidas NFS, GlusterFS, ceph y discos locales. Esta flexibilidad permite a las organizaciones elegir la solución de almacenamiento que mejor se adapte a sus requisitos de rendimiento, escalabilidad y costos.

Network

Run:ai está diseñado para funcionar de manera eficiente en redes de gran ancho de banda. permitiendo la transmisión eficiente de datos entre nodos y la ejecución de cargas de trabajo de IA distribuidas. Run:ai también se puede implementar en entornos aislados, donde no hay conectividad a Internet, lo que garantiza la seguridad y el aislamiento de los datos confidenciales.

Notebooks on Demand

Notebooks de Run:ai La función on Demand permite a los usuarios iniciar espacios de trabajo preconfigurados con sus herramientas y marcos favoritos, incluidos Jupyter Notebook, PyCharm y VS Code. Esto:

* **Simplifica la configuración:** Inicie rápidamente espacios de trabajo sin la necesidad de instalar dependencias manualmente.

* **Garantiza la coherencia:** Proporciona entornos coherentes entre equipos y proyectos.

* **Mejora la colaboración:** Comparta y colabore en espacios de trabajo sin problemas con los miembros del equipo.

Entrenamiento y ajuste fino

Run:ai simplifica el proceso de entrenamiento y ajuste de modelos de IA:

* **Trabajos por lotes en cola:** Programe y ejecute lotes trabajos de entrenamiento con una sola línea de comando.

* **Entrenamiento distribuido:** Entrene modelos de manera efectiva en grandes conjuntos de datos en múltiples GPU.

* **Optimización del modelo:** Optimice los parámetros de entrenamiento e hiperparámetros para mejorar el rendimiento.

LLM privados

Run:ai permite a los usuarios implementar y administrar sus propios LLM privados, modelos entrenados a medida que se pueden utilizar para aplicaciones específicas. Esto permite:

* **Implementación de modelos:** Implementar modelos LLM para inferencia y generar respuestas personalizadas.

* **Gestión de modelos:** Almacene, versione y administre modelos LLM para facilitar el acceso y las actualizaciones.

* **Privacidad de datos:** Mantenga los datos de los usuarios confidenciales y seguros dentro de la infraestructura de la organización.

Paquete NVIDIA y Run:ai

Run:ai y NVIDIA se han asociado para ofrecer una solución totalmente integrada para sistemas DGX, entregando la solución full-stack de mayor rendimiento para cargas de trabajo de IA. Este paquete:

* **Optimiza el rendimiento de DGX:** Aprovecha las capacidades de Run:ai para maximizar la utilización y el rendimiento del hardware DGX.

* **Simplifica la administración:** Proporciona una plataforma única para administrar recursos DGX y cargas de trabajo de IA.

* **Acelera el desarrollo de la IA:** Permite a las organizaciones acelerar sus iniciativas de IA con una solución cohesiva.

Implemente en su propia infraestructura; Nube. En las instalaciones. Air-Gapped.

Run:ai admite una amplia gama de entornos de implementación y ofrece opciones flexibles para organizaciones con diferentes requisitos de infraestructura. Esto incluye:

* **Implementaciones en la nube:** Implemente Run:ai en los principales proveedores de la nube, como AWS, Azure y Google Cloud, lo que le permitirá aprovechar sus servicios y recursos.

* **Implementaciones locales:** Implemente Run:ai en su propia infraestructura de hardware, proporcionando control total sobre su entorno de IA.

* **Implementaciones aisladas:** Implemente Run:ai en entornos aislados sin conectividad a Internet, garantizando la seguridad e integridad de sus datos.

Cualquier herramienta y marco de aprendizaje automático

Run:ai está diseñado para funcionar con una amplia gama de marcos y herramientas de aprendizaje automático, que incluyen:

* **TensorFlow:** Ejecutar y gestionar las cargas de trabajo de TensorFlow de forma eficaz.

* **PyTorch:** Implemente y optimice modelos de PyTorch para entrenamiento e inferencia.

* **JAX:** Utilice JAX para cálculos de IA de alto rendimiento.

* **Keras:** Construya y entrene modelos Keras sin problemas.

* **Scikit-learn:** Utilice Scikit-learn para tareas de aprendizaje automático.

* **XGBoost:** Aproveche XGBoost para algoritmos de aumento de gradiente.

* **LightGBM:** Implemente LightGBM para aumentar el gradiente de manera eficiente.

* **CatBoost:** Utilice CatBoost para un aumento robusto del gradiente.

Cualquier Kubernetes

Run:ai se integra perfectamente con Kubernetes, la plataforma líder en orquestación de contenedores. Esto garantiza la compatibilidad con los entornos de Kubernetes existentes y permite a las organizaciones aprovechar sus beneficios, que incluyen:

* **Escalado automatizado:** Escale las cargas de trabajo de IA de forma dinámica según la demanda.

* **Alta disponibilidad:** Asegúrese de que las cargas de trabajo de IA permanezcan disponibles incluso si fallan los nodos individuales.

* **Implementaciones en contenedores:** Implemente cargas de trabajo de IA como contenedores, promoviendo la portabilidad y la reproducibilidad.

En cualquier lugar

Run:ai está diseñado para implementarse en cualquier lugar, brindando flexibilidad a organizaciones con diversas necesidades de infraestructura. Esto incluye:

* **Centros de datos:** Implemente Run:ai en sus propios centros de datos para obtener el máximo control y seguridad.

* **Proveedores de nube:** Implemente Run:ai en los principales proveedores de nube para lograr escalabilidad y flexibilidad.

* **Dispositivos perimetrales:** Implemente Run:ai en dispositivos perimetrales para aplicaciones de IA en tiempo real.

Cualquier infraestructura

Run:ai admite una amplia gama de componentes de infraestructura, lo que le permite crear su entorno de IA ideal:

* **GPU:** Aproveche el alto rendimiento GPU de proveedores líderes, como NVIDIA, AMD e Intel.

* **CPU:** Utilice CPU para tareas que no requieren aceleración de GPU.

* **ASIC:** Integre ASIC para tareas especializadas, como la inferencia de aprendizaje automático.

* **Almacenamiento:** Elija las soluciones de almacenamiento que mejor se adapten a sus requisitos de rendimiento, escalabilidad y costos.

* **Redes:** Implemente Run:ai en redes de gran ancho de banda para una transmisión de datos eficiente y cargas de trabajo distribuidas.

Preguntas FrecuentesPreguntas Frecuentes

// * **Cloud:** Run:ai se puede implementar en cualquier proveedor de nube importante, incluidos AWS y Azure. y GCP.

// * **On-Prem:** Run:ai también se puede implementar localmente, lo que permite a las organizaciones mantener sus datos y cargas de trabajo seguros dentro de sus propios centros de datos.

// * **Air-gapped:** Run:ai también se puede implementar en entornos air-gapped, que son entornos que no están conectados a Internet. Esto permite a las organizaciones implementar cargas de trabajo de IA en entornos donde existen estrictos requisitos de seguridad.//

// * **Inferencia:** Ejecutar: ai se puede utilizar para ejecutar cargas de trabajo de inferencia en GPU, lo que puede ayudar a mejorar el rendimiento de las aplicaciones de IA.//

// * **Investigación y desarrollo:** Run:ai se puede utilizar para respaldar los esfuerzos de investigación y desarrollo proporcionando una potente plataforma para gestionar e implementar cargas de trabajo de IA.//

// * **Aprendizaje profundo:** Run:ai se puede utilizar para entrenar e implementar modelos de aprendizaje profundo, que se están volviendo cada vez más populares para una amplia gama de aplicaciones.//

//

Para obtener más información, comuníquese con nuestro equipo [email protected] Estaremos encantados de responder sus preguntas y ayudarle a obtener comenzó con Ejecutar:ai.//

Tráfico del Sitio Web

Sin Datos

Productos Alternativos

Alimama Creative

Asistencia de diseño

Centro creativo de Alimama: potenciando su creatividad de marketing

绘AI

Generación de imágenes

Ai Drawing

Hotpot AI

Generación de imágenes

Despierta la creatividad y la productividad con IA

AI Art

Generación de imágenes

Plataforma de creación gráfica AI

6pen Art

Generación de imágenes

Convierte tu imaginación en arte

MoDao AI

Asistencia de diseño

Mockingbot AI: duplique su eficiencia en la creación de prototipos