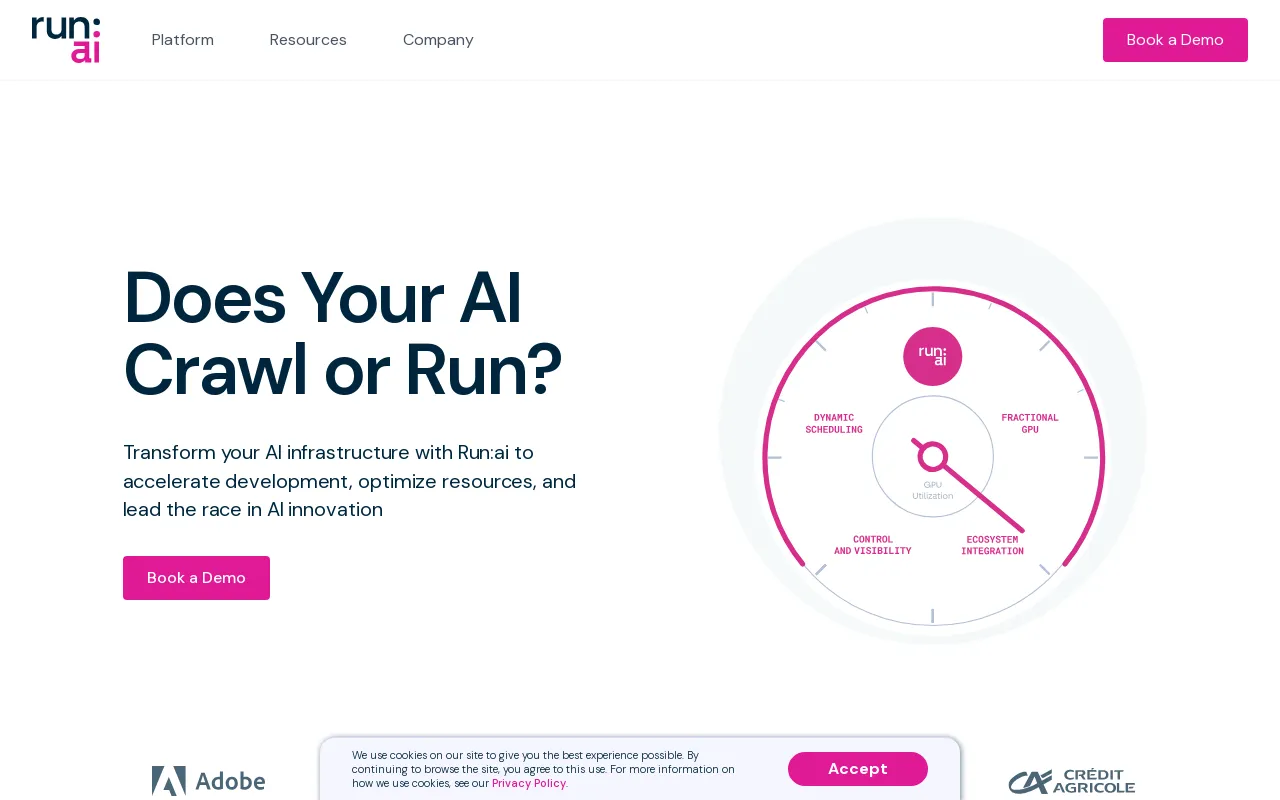

Run:ai Details

Produktinformation

Produktbeschreibung

Run:ai Dev

Beschleunigen Sie die KI-Entwicklung und die Markteinführungszeit

- Starten Sie benutzerdefinierte Arbeitsbereiche mit Ihren bevorzugten Tools und Frameworks.

- Stellen Sie Batch-Jobs in die Warteschlange und führen Sie verteilte Schulungen mit einer einzigen Befehlszeile aus.

- Stellen Sie Ihre Inferenzmodelle von einem Ort aus bereit und verwalten Sie sie.

Ökosystem

Steigern Sie die GPU-Verfügbarkeit und vervielfachen Sie die Rendite Ihrer KI-Investition

- Arbeitslasten

- Vermögenswerte

- Metriken

- Admin

- Authentifizierung und Autorisierung

Run:ai API

- Arbeitslasten

- Vermögenswerte

- Metriken

- Admin

- Authentifizierung und Autorisierung

Run:ai Control Plane

Bereitstellung auf Ihrer eigenen Infrastruktur; Wolke. On-Prem. Mit Luftspalt.

- Multi-Cluster-Management

- Dashboards und Berichte

- Workload-Management

- Ressourcenzugriffsrichtlinie

- Arbeitslastrichtlinie

- Autorisierung und Zugriffskontrolle

Run:ai Cluster Engine

Lernen Sie Ihren neuen KI-Cluster kennen; Ausgenutzt. Skalierbar. Unter Kontrolle.

- AI Workload Scheduler

- Knotenpooling

- Container-Orchestrierung

- GPU-Fraktionierung

- GPU-Knoten

- CPU-Knoten

- Speicher

- Netzwerk

CLI & GUI

Run:ai bietet eine benutzerfreundliche Befehlszeilenschnittstelle (CLI) und eine umfassende grafische Benutzeroberfläche (GUI) für die Verwaltung Ihrer KI-Workloads und Infrastruktur. Die CLI bietet erweiterte Steuerungs- und Skriptfunktionen, während die GUI ein intuitives visuelles Erlebnis für die Überwachung, Konfiguration und Interaktion mit der Plattform bietet.

Arbeitsbereiche

Arbeitsbereiche sind isolierte Umgebungen, in denen KI-Praktiker arbeiten können an ihren Projekten arbeiten. Diese Arbeitsbereiche sind mit den erforderlichen Tools, Bibliotheken und Abhängigkeiten vorkonfiguriert, was den Einrichtungsprozess vereinfacht und die Konsistenz zwischen den Teams gewährleistet. Arbeitsbereiche können an spezifische Projektanforderungen angepasst und einfach geklont oder mit Mitarbeitern geteilt werden.

Tools

Run:ai bietet eine Reihe von Tools, die die Effizienz und Produktivität von verbessern sollen KI-Entwicklung. Die Tools bieten Funktionen wie Jupyter Notebook-Integration, TensorBoard-Visualisierung und Modellverfolgung. Diese Tools rationalisieren Arbeitsabläufe, vereinfachen die Datenanalyse und verbessern die Zusammenarbeit zwischen Teammitgliedern.

Open-Source-Frameworks

Run:ai unterstützt eine breite Palette beliebter Open-Source-KI-Frameworks, einschließlich TensorFlow , PyTorch, JAX und Keras. Dadurch können Entwickler ihre bevorzugten Tools und Bibliotheken nutzen, ohne ihre vorhandene Codebasis an eine spezielle Plattform anpassen zu müssen.

LLM-Katalog

Run:ai bietet einen LLM-Katalog, eine kuratierte Sammlung von beliebte Large Language Models (LLMs) und ihre entsprechenden Konfigurationen. Dieser Katalog erleichtert die Bereitstellung und das Experimentieren mit hochmodernen LLMs und beschleunigt die Entwicklung von KI-Anwendungen, die erweiterte Sprachverarbeitungsfunktionen nutzen.

Arbeitslasten

The Run: Die AI-Plattform ermöglicht die effektive Verwaltung verschiedener KI-Workloads, einschließlich:

* **Training:** Run:ai optimiert verteilte Trainingsjobs und ermöglicht Ihnen das effektive Training von Modellen auf großen Datensätzen über mehrere GPUs hinweg.

* **Inferenz:** Run:ai optimiert die Modellbereitstellung und -inferenz und ermöglicht Ihnen die Bereitstellung von Modellen für Echtzeitvorhersagen oder Stapelverarbeitung.

* **Notebook-Farmen:** Run:ai unterstützt die Erstellung und Verwaltung skalierbarer Notebook-Farmen und bietet eine kollaborative Umgebung für Datenexploration und Modell-Prototyping.

* **Forschungsprojekte:** Run:ai soll Forschungsaktivitäten erleichtern und eine Plattform zum Experimentieren mit neuen Modellen, Algorithmen und Techniken bieten.

Assets

Run:ai ermöglicht Benutzern die Verwaltung und gemeinsame Nutzung von KI-Assets, einschließlich:

* **Modelle:** Speichern und versionieren Sie trainierte Modelle für einfachen Zugriff und Bereitstellung.

* **Datensätze:** Speichern und verwalten Sie große Datensätze für den effizienten Einsatz in Schulungsaufgaben.

* **Code:** Code im Zusammenhang mit KI-Projekten teilen und gemeinsam daran arbeiten.

* **Experimente:** Verfolgen und vergleichen Sie die Ergebnisse verschiedener KI-Experimente.

Metriken

Run:ai bietet umfassende Überwachungs- und Berichtsfunktionen, die es Benutzern ermöglichen, wichtige Metriken im Zusammenhang mit ihren KI-Workloads und ihrer Infrastruktur zu verfolgen. Dazu gehört:

* **GPU-Auslastung:** Überwachen Sie die Auslastung der GPUs im gesamten Cluster und stellen Sie so eine effiziente Ressourcenzuteilung sicher.

* **Workload-Leistung:** Verfolgen Sie die Leistung von Trainings- und Inferenzjobs und identifizieren Sie Engpässe und Optimierungsmöglichkeiten.

* **Ressourcenverbrauch:** Überwachen Sie die CPU-, Speicher- und Netzwerknutzung und liefern Sie Einblicke in die Ressourcennutzung und mögliche Optimierungsstrategien.

Admin

Run:ai bietet Verwaltungstools für die Verwaltung der Plattform und ihrer Benutzer, darunter:

* **Benutzerverwaltung:** Kontrollieren Sie Zugriffsrechte und Berechtigungen für verschiedene Benutzer oder Gruppen.

* **Cluster-Konfiguration:** Konfigurieren Sie die Hardware- und Softwareressourcen innerhalb des AI-Clusters.

* **Richtliniendurchsetzung:** Definieren und erzwingen Sie Richtlinien zur Ressourcenzuteilung, um Fairness und Effizienz sicherzustellen.

Authentifizierung und Autorisierung

Run:ai bietet sichere Authentifizierungs- und Autorisierungsmechanismen, um den Zugriff auf Ressourcen und vertrauliche Daten zu kontrollieren. Dazu gehört:

* **Single Sign-On (SSO):** Integration mit vorhandenen Identitätsanbietern für eine nahtlose Benutzerauthentifizierung.

* **Rollenbasierte Zugriffskontrolle (RBAC):** Definieren Sie Rollen mit spezifischen Berechtigungen und stellen Sie so eine detaillierte Kontrolle über den Zugriff auf Ressourcen sicher.

* **Multi-Faktor-Authentifizierung (MFA):** Erhöhen Sie die Sicherheit, indem Sie mehrere Faktoren für die Benutzeranmeldung erfordern.

Multi-Cluster-Management

Run:ai ermöglicht die Verwaltung mehrerer KI-Cluster von einer zentralen Steuerungsebene aus. Dies ermöglicht Unternehmen Folgendes:

* **Ressourcen konsolidieren:** Ressourcen über verschiedene Cluster hinweg zusammenfassen und so eine einheitliche Ansicht der verfügbaren Kapazität bereitstellen.

* **Workflows standardisieren:** Wenden Sie konsistente Richtlinien und Konfigurationen über mehrere Cluster hinweg an.

* **Optimieren Sie die Auslastung:** Gleichen Sie die Arbeitslastverteilung auf die Cluster aus, um eine optimale Ressourcenzuteilung zu erzielen.

Dashboards und Berichte

Run:ai bietet leistungsstarke Dashboards und Berichtstools, um wichtige Kennzahlen zu visualisieren, die Arbeitslastleistung zu verfolgen und Einblicke in die Ressourcennutzung zu gewinnen. Zu diesen Funktionen gehören:

* **Echtzeitüberwachung:** Verfolgen Sie die GPU-Auslastung, den Workload-Fortschritt und die Ressourcennutzung in Echtzeit.

* **Historische Analysen:** Analysieren Sie historische Daten, um Trends zu erkennen, die Ressourcenzuteilung zu optimieren und die Workload-Leistung zu verbessern.

* **Anpassbare Dashboards:** Erstellen Sie benutzerdefinierte Dashboards, die auf spezifische Bedürfnisse und Perspektiven zugeschnitten sind.

Workload-Management

Run:ai vereinfacht die Verwaltung von KI-Workloads, einschließlich:

* **Planung:** Automatisieren Sie die Planung und Ausführung von Trainings- und Inferenzjobs.

* **Priorisierung:** Weisen Sie Workloads Prioritäten zu, um sicherzustellen, dass kritische Aufgaben zuerst abgeschlossen werden.

* **Ressourcenzuweisung:** Weisen Sie Arbeitslasten Ressourcen (GPUs, CPUs, Speicher) entsprechend ihren Anforderungen und Prioritäten zu.

Ressourcenzugriffsrichtlinie

Run:ai bietet eine flexible Engine für Ressourcenzugriffsrichtlinien, mit der Organisationen Regeln definieren und durchsetzen können, die regeln, wie Benutzer auf Clusterressourcen zugreifen und diese nutzen können. Dies ermöglicht:

* **Fair-Share-Zuteilung:** Stellen Sie sicher, dass die Ressourcen fair zwischen Benutzern und Teams verteilt werden.

* **Kontingentverwaltung:** Legen Sie Grenzen für die Ressourcennutzung fest, um einen übermäßigen Verbrauch zu verhindern und eine effiziente Zuteilung sicherzustellen.

* **Prioritätsdurchsetzung:** Priorisieren Sie den Zugriff auf Ressourcen basierend auf Benutzerrollen oder Workload-Wichtigkeit.

Workload-Richtlinie

Run:ai unterstützt die Erstellung von Workload-Richtlinien und definiert Regeln und Richtlinien für die Verwaltung von KI-Workloads. Dadurch können Unternehmen:

* **Workflows standardisieren:** konsistente Workflows und Best Practices für die Ausführung von KI-Workloads etablieren.

* **Aufgaben automatisieren:** Automatisieren Sie allgemeine Workload-Management-Vorgänge wie Ressourcenzuweisung und -planung.

* **Verbesserung der Sicherheit:** Setzen Sie Richtlinien durch, um die Einhaltung von Sicherheitsstandards und -vorschriften sicherzustellen.

Autorisierung und Zugriffskontrolle

Run:ai verwendet robuste Autorisierungs- und Zugriffskontrollmechanismen, um den Zugriff auf Ressourcen und Daten zu sichern, einschließlich:

* **Fein abgestufte Berechtigungen:* * Gewähren Sie Benutzern oder Gruppen spezifische Berechtigungen und ermöglichen Sie so eine detaillierte Kontrolle über den Zugriff auf Ressourcen.

* **Überwachung und Protokollierung:** Verfolgen Sie Benutzeraktionen und Zugriffsmuster und stellen Sie einen Prüfpfad für Sicherheits- und Compliance-Zwecke bereit.

* **Integration mit vorhandenen Sicherheitstools:** Integrieren Sie Run:ai in vorhandene Sicherheitssysteme für eine zentrale Verwaltung und Kontrolle.

AI Workload Scheduler

Der AI Workload Scheduler von Run:ai wurde speziell zur Optimierung des Ressourcenmanagements für den gesamten KI-Lebenszyklus entwickelt und ermöglicht Ihnen Folgendes:

* **Dynamische Planung:* * Weisen Sie Arbeitslasten basierend auf aktuellen Anforderungen und Prioritäten dynamisch Ressourcen zu.

* **GPU-Pooling:** Konsolidieren Sie GPU-Ressourcen in Pools und ermöglichen Sie so eine flexible Zuweisung für verschiedene Arbeitslasten.

* **Prioritätsplanung:** Stellen Sie sicher, dass kritischen Aufgaben zuerst Ressourcen zugewiesen werden, wodurch der Gesamtdurchsatz des KI-Clusters optimiert wird.

Node Pooling

Run:ai führt das Konzept des Node Pooling ein und ermöglicht es Unternehmen, heterogene KI-Cluster problemlos zu verwalten. Diese Funktion bietet:

* **Cluster-Konfiguration:** Definieren Sie Kontingente, Prioritäten und Richtlinien auf Knotenpoolebene, um die Ressourcenzuteilung zu verwalten.

* **Ressourcenverwaltung:** Gewährleisten Sie eine faire und effiziente Zuweisung von Ressourcen innerhalb des Clusters unter Berücksichtigung von Faktoren wie GPU-Typ, Speicher und CPU-Kernen.

* **Workload-Verteilung:** Weisen Sie Workloads basierend auf ihren Ressourcenanforderungen den entsprechenden Node-Pools zu.

Container-Orchestrierung

Run:ai lässt sich nahtlos in Container-Orchestrierungsplattformen wie Kubernetes integrieren und ermöglicht die Bereitstellung und Verwaltung verteilter containerisierter KI-Workloads. Dies bietet:

* **Automatisierte Skalierung:** Skalieren Sie KI-Workloads je nach Bedarf nahtlos nach oben oder unten.

* **Hohe Verfügbarkeit:** Stellen Sie sicher, dass KI-Workloads auch dann verfügbar bleiben, wenn einzelne Knoten ausfallen.

* **Vereinfachte Bereitstellung:** Stellen Sie KI-Workloads mithilfe von Container-Images bereit und verwalten Sie sie, um Portabilität und Reproduzierbarkeit zu fördern.

GPU-Fraktionierung

Mit der GPU-Fraktionierungstechnologie von Run:ai können Sie eine einzelne GPU in mehrere Fraktionen aufteilen und so eine kostengünstige Möglichkeit zur Ausführung von Arbeitslasten bieten, die nur einen Teil der GPUs benötigen Ressourcen. Diese Funktion:

* **Steigert die Kosteneffizienz:** Ermöglicht die Ausführung von mehr Workloads auf derselben Infrastruktur durch die gemeinsame Nutzung von GPU-Ressourcen.

* **Vereinfacht die Ressourcenverwaltung:** Optimiert die Zuweisung von GPU-Ressourcen für verschiedene Arbeitslasten mit unterschiedlichen Anforderungen.

* **Verbessert die Auslastung:** Maximiert die Auslastung von GPUs, reduziert Leerlaufzeiten und erhöht die Effizienz.

GPU-Knoten

Run:ai unterstützt eine breite Palette von GPU-Knoten führender Anbieter, darunter NVIDIA, AMD und Intel. Dies stellt die Kompatibilität mit einer Vielzahl von Hardwarekonfigurationen sicher und ermöglicht es Unternehmen, die vorhandene Infrastruktur zu nutzen oder die am besten geeigneten GPUs für ihre spezifischen Anforderungen auszuwählen.

CPU-Knoten

Zusätzlich zu GPU-Knoten bietet Run :ai unterstützt auch CPU-Knoten für Aufgaben, die keine GPU-Beschleunigung erfordern. Dadurch können Unternehmen die vorhandene CPU-Infrastruktur nutzen oder kostengünstigere CPU-Ressourcen für bestimmte Aufgaben nutzen.

Speicher

Run:ai lässt sich in verschiedene Speicherlösungen integrieren, darunter NFS, GlusterFS und Ceph und lokale Festplatten. Diese Flexibilität ermöglicht es Unternehmen, eine Speicherlösung zu wählen, die ihren Leistungs-, Skalierbarkeits- und Kostenanforderungen am besten entspricht.

Netzwerk

Run:ai ist für den effizienten Einsatz in Netzwerken mit hoher Bandbreite konzipiert. Ermöglicht die effiziente Übertragung von Daten zwischen Knoten und die Ausführung verteilter KI-Workloads. Run:ai kann auch in Air-Gap-Umgebungen eingesetzt werden, in denen keine Internetverbindung besteht, um die Sicherheit und Isolierung sensibler Daten zu gewährleisten.

Notebooks on Demand

Run:ai's Notebooks Mit der On-Demand-Funktion können Benutzer vorkonfigurierte Arbeitsbereiche mit ihren bevorzugten Tools und Frameworks starten, darunter Jupyter Notebook, PyCharm und VS Code. Dies:

* **Vereinfacht die Einrichtung:** Starten Sie Arbeitsbereiche schnell, ohne Abhängigkeiten manuell installieren zu müssen.

* **Sorgt für Konsistenz:** Bietet konsistente Umgebungen für Teams und Projekte.

* **Verbessert die Zusammenarbeit:** Teilen Sie Arbeitsbereiche nahtlos mit Teammitgliedern und arbeiten Sie daran zusammen.

Training und Feinabstimmung

Run:ai vereinfacht den Prozess des Trainings und der Feinabstimmung von KI-Modellen:

* **Batch-Jobs in die Warteschlange stellen:** Batch-Jobs planen und ausführen Trainingsjobs mit einer einzigen Befehlszeile.

* **Verteiltes Training:** Trainieren Sie Modelle effektiv auf großen Datensätzen über mehrere GPUs hinweg.

* **Modelloptimierung:** Optimieren Sie Trainingsparameter und Hyperparameter für eine verbesserte Leistung.

Private LLMs

Run:ai ermöglicht Benutzern die Bereitstellung und Verwaltung ihrer eigenen privaten LLMs, individuell trainierter Modelle, die für bestimmte Anwendungen verwendet werden können. Dies ermöglicht:

* **Modellbereitstellung:** Stellen Sie LLM-Modelle zur Inferenz bereit und generieren Sie personalisierte Antworten.

* **Modellverwaltung:** Speichern, versionieren und verwalten Sie LLM-Modelle für einfachen Zugriff und Aktualisierungen.

* **Datenschutz:** Bewahren Sie Benutzerdaten innerhalb der Infrastruktur der Organisation vertraulich und sicher auf.

NVIDIA & Run:ai Bundle

Run:ai und NVIDIA haben sich zusammengetan, um eine vollständig integrierte Lösung für DGX Systems anzubieten und damit die leistungsstärkste Full-Stack-Lösung für KI-Workloads bereitzustellen. Dieses Paket:

* **Optimiert die DGX-Leistung:** Nutzt die Funktionen von Run:ai, um die Nutzung und Leistung der DGX-Hardware zu maximieren.

* **Vereinfacht die Verwaltung:** Bietet eine einzige Plattform für die Verwaltung von DGX-Ressourcen und KI-Workloads.

* **Beschleunigt die KI-Entwicklung:** Ermöglicht Unternehmen, ihre KI-Initiativen mit einer zusammenhängenden Lösung zu beschleunigen.

Bereitstellung auf Ihrer eigenen Infrastruktur; Wolke. On-Prem. Air-Gapped.

Run:ai unterstützt eine Vielzahl von Bereitstellungsumgebungen und bietet flexible Optionen für Organisationen mit unterschiedlichen Infrastrukturanforderungen. Dazu gehören:

* **Cloud-Bereitstellungen:** Stellen Sie Run:ai bei großen Cloud-Anbietern wie AWS, Azure und Google Cloud bereit, damit Sie deren Dienste und Ressourcen nutzen können.

* **On-Premises-Bereitstellungen:** Stellen Sie Run:ai auf Ihrer eigenen Hardware-Infrastruktur bereit und bieten Sie so die vollständige Kontrolle über Ihre KI-Umgebung.

* **Air-Gap-Bereitstellungen:** Stellen Sie Run:ai in isolierten Umgebungen ohne Internetverbindung bereit, um die Sicherheit und Integrität Ihrer Daten zu gewährleisten.

Jedes ML-Tool und Framework

Run:ai ist für die Zusammenarbeit mit einer Vielzahl von Tools und Frameworks für maschinelles Lernen konzipiert, darunter:

* **TensorFlow:** Run und TensorFlow-Workloads effektiv verwalten.

* **PyTorch:** Stellen Sie PyTorch-Modelle für Training und Inferenz bereit und optimieren Sie sie.

* **JAX:** Nutzen Sie JAX für leistungsstarke KI-Berechnungen.

* **Keras:** Erstellen und trainieren Sie Keras-Modelle nahtlos.

* **Scikit-learn:** Nutzen Sie Scikit-learn für maschinelle Lernaufgaben.

* **XGBoost:** Nutzen Sie XGBoost für Gradienten-Boosting-Algorithmen.

* **LightGBM:** Stellen Sie LightGBM für eine effiziente Gradientenverstärkung bereit.

* **CatBoost:** Nutzen Sie CatBoost für eine robuste Gradientenverstärkung.

Jedes Kubernetes

Run:ai lässt sich nahtlos in Kubernetes, die führende Container-Orchestrierungsplattform, integrieren. Dies stellt die Kompatibilität mit vorhandenen Kubernetes-Umgebungen sicher und ermöglicht es Unternehmen, die Vorteile zu nutzen, darunter:

* **Automatisierte Skalierung:** KI-Workloads dynamisch je nach Bedarf skalieren.

* **Hohe Verfügbarkeit:** Stellen Sie sicher, dass KI-Workloads auch dann verfügbar bleiben, wenn einzelne Knoten ausfallen.

* **Containerisierte Bereitstellungen:** Stellen Sie KI-Workloads als Container bereit und fördern Sie so die Portabilität und Reproduzierbarkeit.

Anywhere

Run:ai ist für den Einsatz überall konzipiert und bietet Flexibilität für Organisationen mit unterschiedlichen Infrastrukturanforderungen. Dazu gehört:

* **Rechenzentren:** Stellen Sie Run:ai in Ihren eigenen Rechenzentren bereit, um maximale Kontrolle und Sicherheit zu gewährleisten.

* **Cloud-Anbieter:** Stellen Sie Run:ai für Skalierbarkeit und Flexibilität bei großen Cloud-Anbietern bereit.

* **Edge-Geräte:** Stellen Sie Run:ai auf Edge-Geräten für Echtzeit-KI-Anwendungen bereit.

Jede Infrastruktur

Run:ai unterstützt eine breite Palette von Infrastrukturkomponenten, sodass Sie Ihre ideale KI-Umgebung aufbauen können:

* **GPUs:** Nutzen Sie hohe Leistung GPUs von führenden Anbietern wie NVIDIA, AMD und Intel.

* **CPUs:** Nutzen Sie CPUs für Aufgaben, die keine GPU-Beschleunigung erfordern.

* **ASICs:** Integrieren Sie ASICs für spezielle Aufgaben, z. B. Inferenz beim maschinellen Lernen.

* **Speicher:** Wählen Sie Speicherlösungen, die Ihren Anforderungen an Leistung, Skalierbarkeit und Kosten am besten entsprechen.

* **Netzwerk:** Stellen Sie Run:ai in Netzwerken mit hoher Bandbreite bereit, um eine effiziente Datenübertragung und verteilte Arbeitslasten zu gewährleisten.

FAQFAQ

// * **Cloud:** Run:ai kann auf jedem großen Cloud-Anbieter bereitgestellt werden, einschließlich AWS und Azure , und GCP.

// * **On-Prem:** Run:ai kann auch vor Ort bereitgestellt werden, was es Unternehmen ermöglicht, ihre Daten und Arbeitslasten in ihren eigenen Rechenzentren zu schützen.

// * **Air-Gapped:** Run:ai kann auch in Air-Gapped-Umgebungen eingesetzt werden, also Umgebungen, die nicht mit dem Internet verbunden sind. Dies ermöglicht es Organisationen, KI-Workloads in Umgebungen bereitzustellen, in denen strenge Sicherheitsanforderungen gelten.//

// * **Schlussfolgerung:** Ausführen: ai kann zum Ausführen von Inferenz-Workloads auf GPUs verwendet werden, was dazu beitragen kann, die Leistung von KI-Anwendungen zu verbessern.//

// * **Forschung und Entwicklung:** Run:ai kann zur Unterstützung von Forschungs- und Entwicklungsbemühungen verwendet werden durch die Bereitstellung einer leistungsstarken Plattform für die Verwaltung und Bereitstellung von KI-Workloads.//

// * **Deep Learning:** Run:ai kann zum Trainieren und Bereitstellen von Deep-Learning-Modellen verwendet werden, die bei einem breiten Spektrum immer beliebter werden von Anwendungen.//

//

Für weitere Informationen kontaktieren Sie bitte unser Team [email protected] Wir beantworten gerne Ihre Fragen und helfen Ihnen bei der Beschaffung begann mit Run:ai.//

Website-Traffic

Keine Daten

Alternative Produkte

绘AI

Bildgenerierung

Ai Drawing

AI Art

Bildgenerierung

AI-Grafikerstellungsplattform

360 AI

Bildgenerierung

KI schafft atemberaubende Kunstwerke

6pen Art

Bildgenerierung

Verwandeln Sie Ihre Fantasie in Kunst

AI Picasso

Bildgenerierung

Erstellen Sie fantastische Kunstwerke mit leistungsstarker KI!

Presentations AI

Präsentation

Der weltbeste KI-Präsentationsersteller