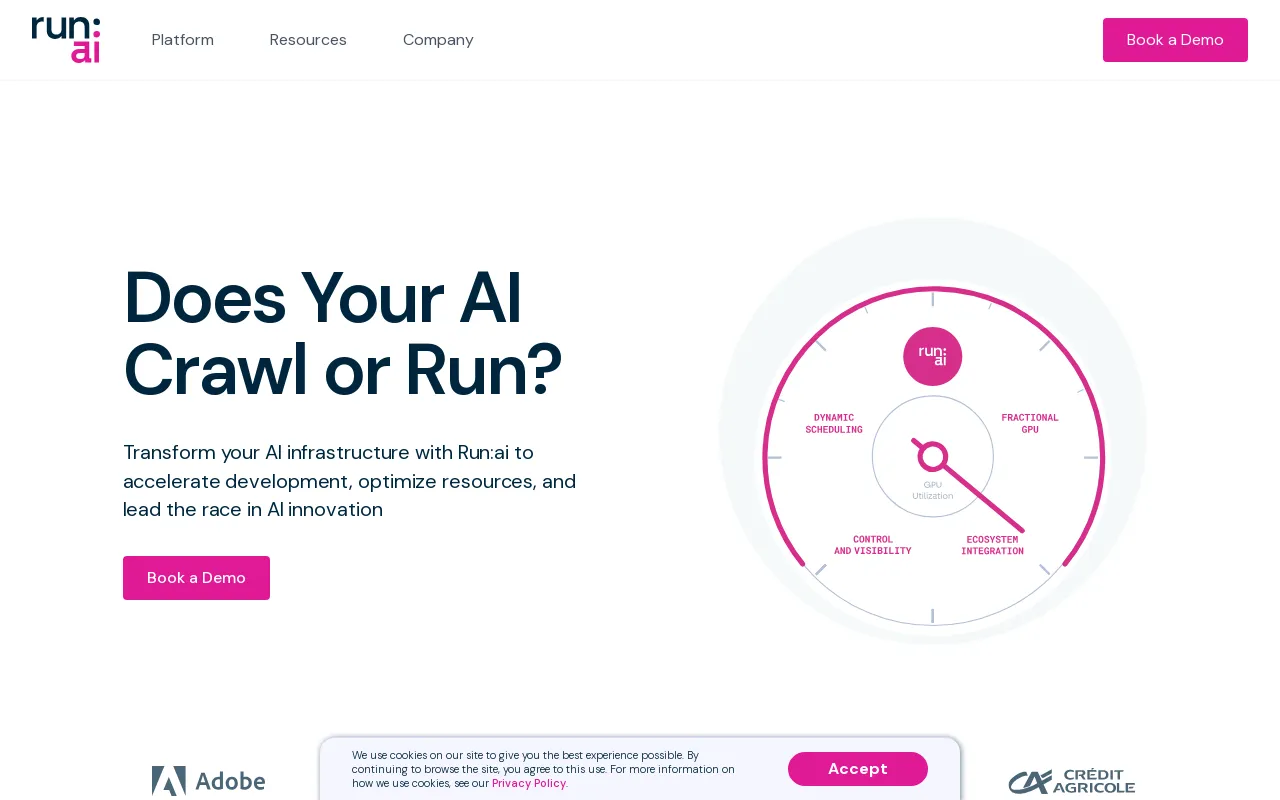

Run:ai Detaljer

Produktinformation

Produktbeskrivelse

Kør:ai Dev

Accelerer AI-udvikling og time-to-market

- Lancer tilpassede arbejdsområder med dine foretrukne værktøjer og rammer.

- Sæt batchjobs i kø, og kør distribueret træning med en enkelt kommandolinje.

- Implementer og administrer dine inferensmodeller fra ét sted.

Økosystem

Forøg GPU-tilgængeligheden, og multiplicer afkastet af din AI-investering

- Arbejdsbelastning

- Aktiver

- Metrics

- Administrator

- Godkendelse og godkendelse

Kør:ai API

- Arbejdsbelastning

- Aktiver

- Metrics

- Administrator

- Godkendelse og godkendelse

Kør:ai kontrolplan

Implementer på din egen infrastruktur; Sky. On-Prem. Air-Gapped.

- Multi-Cluster Management

- Dashboards og rapportering

- Workload Management

- Ressourceadgangspolitik

- Arbejdsbelastningspolitik

- Autorisation og adgangskontrol

Kør:ai Cluster Engine

Mød din nye AI-klynge; Udnyttet. Skalerbar. Under kontrol.

- AI Workload Scheduler

- Nodepooling

- Beholderorkestering

- GPU-fraktionering

- GPU-noder

- CPU-noder

- Opbevaring

- Netværk

CLI & GUI

Run:ai giver en brugervenlig kommandolinjegrænseflade (CLI) og en omfattende grafisk brugergrænseflade (GUI) til styring af dine AI-arbejdsbelastninger og infrastruktur. CLI tilbyder avancerede kontrol- og scriptfunktioner, mens GUI giver en intuitiv visuel oplevelse til overvågning, konfiguration og interaktion med platformen.

Arbejdsområder

Arbejdsområder er isolerede miljøer, hvor AI-udøvere kan arbejde på deres projekter. Disse arbejdsområder er prækonfigureret med de nødvendige værktøjer, biblioteker og afhængigheder, hvilket forenkler opsætningsprocessen og sikrer sammenhæng på tværs af teams. Arbejdsområder kan tilpasses til at imødekomme specifikke projektkrav og kan nemt klones eller deles med samarbejdspartnere.

Værktøjer

Run:ai leverer en række værktøjer designet til at øge effektiviteten og produktiviteten af AI udvikling. Værktøjerne tilbyder funktioner såsom Jupyter Notebook-integration, TensorBoard-visualisering og modelsporing. Disse værktøjer strømliner arbejdsgange, forenkler dataanalyse og forbedrer samarbejdet mellem teammedlemmer.

Open Source Frameworks

Run:ai understøtter en lang række populære open source AI-frameworks, herunder TensorFlow , PyTorch, JAX og Keras. Dette giver udviklere mulighed for at udnytte deres foretrukne værktøjer og biblioteker uden at skulle tilpasse deres eksisterende kodebase til en specialiseret platform.

LLM Catalog

Run:ai tilbyder et LLM Catalog, en kurateret samling af populære store sprogmodeller (LLM'er) og deres tilsvarende konfigurationer. Dette katalog gør det nemmere at implementere og eksperimentere med avancerede LLM'er, hvilket accelererer udviklingen af AI-applikationer, der udnytter avancerede sprogbehandlingsfunktioner.

Workloads

The Run: ai-platformen giver mulighed for effektiv styring af forskellige AI-arbejdsbelastninger, herunder:

* **Træning:** Run:ai optimerer distribuerede træningsjob, så du effektivt kan træne modeller på store datasæt på tværs af flere GPU'er.

* **Inferens:** Run:ai strømliner modelimplementering og inferens, så du kan implementere modeller til forudsigelser i realtid eller batchbehandling.

* **Notebook Farms:** Run:ai understøtter oprettelsen og styringen af skalerbare notebookfarme, hvilket giver et samarbejdsmiljø for dataudforskning og modelprototyping.

* **Forskningsprojekter:** Run:ai er designet til at lette forskningsaktiviteter og tilbyder en platform for eksperimentering med nye modeller, algoritmer og teknikker.

Aktiver

Run:ai giver brugerne mulighed for at administrere og dele AI-aktiver, herunder:

* **Modeller:** Store og versionstrænede modeller for nem adgang og implementering.

* **Datasæt:** Gem og administrer store datasæt til effektiv brug i træningsjob.

* **Kode:** Del og samarbejd om kode relateret til AI-projekter.

* **Eksperimenter:** Spor og sammenlign resultaterne af forskellige AI-eksperimenter.

Metrics

Run:ai leverer omfattende overvågnings- og rapporteringsfunktioner, der giver brugerne mulighed for at spore nøglemålinger relateret til deres AI-arbejdsbelastninger og infrastruktur. Dette omfatter:

* **GPU-udnyttelse:** Overvåg brugen af GPU'er på tværs af klyngen, hvilket sikrer effektiv ressourceallokering.

* **Ydeevne i arbejdsbelastning:** Spor udførelsen af trænings- og inferensjobs, identificer flaskehalse og muligheder for optimering.

* **Ressourceforbrug:** Overvåg CPU-, hukommelses- og netværksbrug og giver indsigt i ressourceudnyttelse og potentielle optimeringsstrategier.

Admin

Run:ai tilbyder administrative værktøjer til at administrere platformen og dens brugere, herunder:

* **Brugeradministration:** Kontroller adgangsrettigheder og tilladelser for forskellige brugere eller grupper.

* **Klyngekonfiguration:** Konfigurer hardware- og softwareressourcerne i AI-klyngen.

* **Politikhåndhævelse:** Definer og håndhæv ressourceallokeringspolitikker for at sikre retfærdighed og effektivitet.

Godkendelse og godkendelse

Run:ai giver sikre godkendelses- og autorisationsmekanismer til at kontrollere adgangen til ressourcer og følsomme data. Dette inkluderer:

* **Single sign-on (SSO):** Integrer med eksisterende identitetsudbydere for problemfri brugergodkendelse.

* **Rollebaseret adgangskontrol (RBAC):** Definer roller med specifikke tilladelser, hvilket sikrer detaljeret kontrol over adgang til ressourcer.

* **Multi-factor authentication (MFA):** Forbedre sikkerheden ved at kræve flere faktorer for brugerlogin.

Multi-Cluster Management

Run:ai muliggør styring af flere AI-klynger fra et centralt kontrolplan. Dette giver organisationer mulighed for at:

* **Konsolidere ressourcer:** Samle ressourcer på tværs af forskellige klynger, hvilket giver et samlet overblik over tilgængelig kapacitet.

* **Standardiser arbejdsgange:** Anvend konsekvente politikker og konfigurationer på tværs af flere klynger.

* **Optimer udnyttelsen:** Balancer fordelingen af arbejdsbyrden på tværs af klynger for optimal ressourceallokering.

Dashboards og rapportering

Run:ai leverer kraftfulde dashboards og rapporteringsværktøjer til at visualisere nøglemålinger, spore arbejdsbyrdes ydeevne og få indsigt i ressourceudnyttelse. Disse funktioner omfatter:

* **Overvågning i realtid:** Spor GPU-udnyttelse, arbejdsbelastningsfremskridt og ressourceforbrug i realtid.

* **Historisk analyse:** Analyser historiske data for at identificere tendenser, optimere ressourceallokering og forbedre arbejdsbyrdes ydeevne.

* **Tilpasbare dashboards:** Opret brugerdefinerede dashboards, der er skræddersyet til specifikke behov og perspektiver.

Workload Management

Run:ai forenkler styringen af AI-arbejdsbelastninger, herunder:

* **Planlægning:** Automatiser planlægning og udførelse af trænings- og inferensjobs.

* **Prioritering:** Tildel prioriteter til arbejdsbelastninger for at sikre, at kritiske opgaver udføres først.

* **Ressourceallokering:** Tildel ressourcer (GPU'er, CPU'er, hukommelse) til arbejdsbelastninger baseret på deres behov og prioriteter.

Ressourceadgangspolitik

Run:ai tilbyder en fleksibel ressourceadgangspolitikmotor, der giver organisationer mulighed for at definere og håndhæve regler for, hvordan brugere kan få adgang til og bruge klyngressourcer. Dette muliggør:

* **Fair-share allokering:** Sikre, at ressourcer fordeles retfærdigt mellem brugere og teams.

* **Kvotestyring:** Sæt grænser for ressourceforbrug for at forhindre overforbrug og sikre effektiv fordeling.

* **Prioritetshåndhævelse:** Prioriter adgang til ressourcer baseret på brugerroller eller vigtighed af arbejdsbyrden.

Arbejdsbelastningspolitik

Run:ai understøtter oprettelsen af arbejdsbelastningspolitikker, der definerer regler og retningslinjer for styring af AI-arbejdsbelastninger. Dette gør det muligt for organisationer at:

* **Standardisere arbejdsgange:** Etablere ensartede arbejdsgange og bedste praksis for at køre AI-arbejdsbelastninger.

* **Automatiser opgaver:** Automatiser almindelige arbejdsbelastningsstyringsoperationer, såsom ressourceallokering og planlægning.

* **Forbedre sikkerheden:** Håndhæv politikker for at sikre overholdelse af sikkerhedsstandarder og -forskrifter.

Autorisation og adgangskontrol

Run:ai anvender robuste autorisations- og adgangskontrolmekanismer til at sikre adgang til ressourcer og data, herunder:

* **Finkorede tilladelser:* * Giv specifikke tilladelser til brugere eller grupper, hvilket giver detaljeret kontrol over adgang til ressourcer.

* **Revision og logning:** Spor brugerhandlinger og adgangsmønstre og giver et revisionsspor til sikkerheds- og overholdelsesformål.

* **Integration med eksisterende sikkerhedsværktøjer:** Integrer Run:ai med eksisterende sikkerhedssystemer til centraliseret styring og kontrol.

AI Workload Scheduler

Run:ai's AI Workload Scheduler er specielt designet til at optimere ressourcestyring for hele AI-livscyklussen, så du kan:

* **Dynamisk planlægning:* * Dynamisk allokere ressourcer til arbejdsbelastninger baseret på aktuelle behov og prioriteter.

* **GPU-pooling:** Konsolider GPU-ressourcer i puljer, hvilket giver mulighed for fleksibel allokering til forskellige arbejdsbelastninger.

* **Prioritetsplanlægning:** Sørg for, at kritiske opgaver tildeles ressourcer først, og optimerer den overordnede gennemstrømning af AI-klyngen.

Node Pooling

Run:ai introducerer konceptet Node Pooling, der gør det muligt for organisationer at administrere heterogene AI-klynger med lethed. Denne funktion giver:

* **Klyngekonfiguration:** Definer kvoter, prioriteter og politikker på nodepuljeniveau for at administrere ressourceallokering.

* **Ressourcestyring:** Sikre retfærdig og effektiv allokering af ressourcer i klyngen under hensyntagen til faktorer som GPU-type, hukommelse og CPU-kerner.

* **Fordeling af arbejdsbelastning:** Tildel arbejdsbelastninger til passende nodepuljer baseret på deres ressourcekrav.

Container Orchestration

Run:ai integreres problemfrit med containerorkestreringsplatforme såsom Kubernetes, hvilket muliggør implementering og styring af distribuerede containeriserede AI-arbejdsbelastninger. Dette giver:

* **Automatisk skalering:** Skaler AI-arbejdsbelastninger op eller ned problemfrit baseret på efterspørgsel.

* **Høj tilgængelighed:** Sørg for, at AI-arbejdsbelastninger forbliver tilgængelige, selvom individuelle noder fejler.

* **Forenklet implementering:** Implementer og administrer AI-arbejdsbelastninger ved hjælp af containeriserede billeder, hvilket fremmer portabilitet og reproducerbarhed.

GPU Fractioning

Run:ai's GPU Fractioning-teknologi giver dig mulighed for at opdele en enkelt GPU i flere fraktioner, hvilket giver en omkostningseffektiv måde at køre arbejdsbelastninger, der kun kræver en del af en GPU'er ressourcer. Denne funktion:

* **Øger omkostningseffektiviteten:** Giver dig mulighed for at køre flere arbejdsbelastninger på den samme infrastruktur ved at dele GPU-ressourcer.

* **Forenkler ressourcestyring:** Strømliner tildelingen af GPU-ressourcer til forskellige arbejdsbelastninger med forskellige krav.

* **Forbedrer udnyttelsen:** Maksimerer udnyttelsen af GPU'er, reducerer inaktiv tid og øger effektiviteten.

GPU-noder

Run:ai understøtter en lang række GPU-noder fra førende leverandører, herunder NVIDIA, AMD og Intel. Dette sikrer kompatibilitet med en række hardwarekonfigurationer og giver organisationer mulighed for at bruge eksisterende infrastruktur eller vælge de bedst egnede GPU'er til deres specifikke behov.

CPU-noder

Ud over GPU-noder, Kør :ai understøtter også CPU-noder til opgaver, der ikke kræver GPU-acceleration. Dette giver organisationer mulighed for at udnytte eksisterende CPU-infrastruktur eller bruge mere omkostningseffektive CPU-ressourcer til specifikke opgaver.

Lagring

Run:ai integreres med forskellige lagerløsninger, herunder NFS, GlusterFS, ceph , og lokale diske. Denne fleksibilitet giver organisationer mulighed for at vælge en lagerløsning, der bedst opfylder deres krav til ydeevne, skalerbarhed og omkostninger.

Netværk

Run:ai er designet til at fungere effektivt på netværk med høj båndbredde, muliggør effektiv transmission af data mellem noder og udførelse af distribuerede AI-arbejdsbelastninger. Run:ai kan også implementeres i luftgappede miljøer, hvor der ikke er internetforbindelse, hvilket sikrer sikkerheden og isoleringen af følsomme data.

Notebooks on Demand

Run:ai's Notebooks on Demand-funktionen gør det muligt for brugere at starte prækonfigurerede arbejdsområder med deres foretrukne værktøjer og rammer, herunder Jupyter Notebook, PyCharm og VS Code. Dette:

* **Forenkler opsætningen:** Start arbejdsområder hurtigt uden at skulle installere afhængigheder manuelt.

* **Sikrer konsekvens:** Giver konsistente miljøer på tværs af teams og projekter.

* **Forbedrer samarbejdet:** Del og samarbejd problemfrit på arbejdsområder med teammedlemmer.

Træning og finjustering

Run:ai forenkler processen med træning og finjustering af AI-modeller:

* **Kø batchjob:** Planlæg og kør batch træningsjob med en enkelt kommandolinje.

* **Distribueret træning:** Træn effektivt modeller på store datasæt på tværs af flere GPU'er.

* **Modeloptimering:** Optimer træningsparametre og hyperparametre for forbedret ydeevne.

Private LLM'er

Run:ai giver brugerne mulighed for at implementere og administrere deres egne private LLM'er, specialuddannede modeller, der kan bruges til specifikke applikationer. Dette muliggør:

* **Modelimplementering:** Implementer LLM-modeller til slutninger og generer personlige svar.

* **Modelstyring:** Gem, versioner og administrer LLM-modeller for nem adgang og opdateringer.

* **Databeskyttelse:** Hold brugerdata fortrolige og sikre i organisationens infrastruktur.

NVIDIA & Run:ai Bundle

Run:ai og NVIDIA er gået sammen om at tilbyde en fuldt integreret løsning til DGX-systemer, der leverer den mest effektive fuldstack-løsning til AI-arbejdsbelastninger. Denne pakke:

* **Optimerer DGX-ydeevne:** Udnytter Run:ai's muligheder for at maksimere udnyttelsen og ydeevnen af DGX-hardware.

* **Forenkler administrationen:** Giver en enkelt platform til styring af DGX-ressourcer og AI-arbejdsbelastninger.

* **Accelererer AI-udvikling:** Giver organisationer mulighed for at accelerere deres AI-initiativer med en sammenhængende løsning.

Implementer på din egen infrastruktur; Sky. On-Prem. Air-Gapped.

Run:ai understøtter en bred vifte af implementeringsmiljøer og tilbyder fleksible muligheder for organisationer med forskellige infrastrukturkrav. Dette inkluderer:

* **Cloud-implementeringer:** Implementer Run:ai på store cloud-udbydere, såsom AWS, Azure og Google Cloud, så du kan udnytte deres tjenester og ressourcer.

* **Implementeringer på stedet:** Implementer Run:ai på din egen hardwareinfrastruktur, hvilket giver fuld kontrol over dit AI-miljø.

* **Air-gappede implementeringer:** Implementer Run:ai i isolerede miljøer uden internetforbindelse, hvilket sikrer dine datas sikkerhed og integritet.

Ethvert ML-værktøj og -rammeværk

Run:ai er designet til at fungere med en bred vifte af maskinlæringsværktøjer og rammer, herunder:

* **TensorFlow:** Run og administrere TensorFlow-arbejdsbelastninger effektivt.

* **PyTorch:** Implementer og optimer PyTorch-modeller til træning og inferens.

* **JAX:** Brug JAX til højtydende AI-beregninger.

* **Keras:** Byg og træne Keras-modeller problemfrit.

* **Scikit-learn:** Brug Scikit-learn til maskinlæringsopgaver.

* **XGBoost:** Udnyt XGBoost til gradientforstærkende algoritmer.

* **LightGBM:** Implementer LightGBM for effektiv gradientboosting.

* **CatBoost:** Brug CatBoost til robust gradientboosting.

Alle Kubernetes

Run:ai integreres problemfrit med Kubernetes, den førende containerorkestreringsplatform. Dette sikrer kompatibilitet med eksisterende Kubernetes-miljøer og giver organisationer mulighed for at udnytte fordelene, herunder:

* **Automatiseret skalering:** Skaler AI-arbejdsbelastninger dynamisk baseret på efterspørgsel.

* **Høj tilgængelighed:** Sørg for, at AI-arbejdsbelastninger forbliver tilgængelige, selvom individuelle noder fejler.

* **Containeriserede implementeringer:** Implementer AI-arbejdsbelastninger som containere, hvilket fremmer portabilitet og reproducerbarhed.

Anywhere

Run:ai er designet til at blive implementeret hvor som helst, hvilket giver fleksibilitet til organisationer med forskellige infrastrukturbehov. Dette inkluderer:

* **Datacentre:** Implementer Run:ai i dine egne datacentre for maksimal kontrol og sikkerhed.

* **Cloud-udbydere:** Implementer Run:ai på store cloud-udbydere for skalerbarhed og fleksibilitet.

* **Edge-enheder:** Implementer Run:ai på kant-enheder til AI-applikationer i realtid.

Enhver infrastruktur

Run:ai understøtter en bred vifte af infrastrukturkomponenter, så du kan bygge dit ideelle AI-miljø:

* **GPU'er:** Udnyt høj ydeevne GPU'er fra førende leverandører, såsom NVIDIA, AMD og Intel.

* **CPU'er:** Brug CPU'er til opgaver, der ikke kræver GPU-acceleration.

* **ASIC'er:** Integrer ASIC'er til specialiserede opgaver, såsom maskinlæringsinferens.

* **Lagring:** Vælg lagerløsninger, der bedst opfylder dine krav til ydeevne, skalerbarhed og omkostninger.

* **Netværk:** Implementer Run:ai på netværk med høj båndbredde for effektiv datatransmission og distribuerede arbejdsbelastninger.

FAQFAQ

// * **Cloud:** Run:ai kan implementeres på enhver større cloud-udbyder inklusive AWS, Azure , og GCP.

// * **On-Prem:** Run:ai kan også implementeres on-premise, hvilket giver organisationer mulighed for at holde deres data og arbejdsbelastninger sikre i deres egne datacentre.

// * **Air-Gapped:** Run:ai kan også implementeres i luftgappede miljøer, som er miljøer, der ikke er forbundet til internettet. Dette giver organisationer mulighed for at implementere AI-arbejdsbelastninger i miljøer, hvor der er strenge sikkerhedskrav.//

// * **Inferens:** Kør: ai kan bruges til at køre inferensarbejdsbelastninger på GPU'er, hvilket kan hjælpe med at forbedre ydeevnen af AI-applikationer.//

// * **Forskning og udvikling:** Run:ai kan bruges til at understøtte forsknings- og udviklingsindsatsen ved at levere en kraftfuld platform til styring og implementering af AI-arbejdsbelastninger.//

// * **Deep learning:** Run:ai kan bruges til at træne og implementere deep learning-modeller, som bliver mere og mere populære for en bred vifte af applikationer.//

//

For mere information, kontakt venligst vores team [email protected] Vi besvarer gerne dine spørgsmål og hjælper dig med at få startede med Run:ai.//

Webstedstrafik

Ingen data

Alternative produkter

绘AI

Billedgenerering

Ai Drawing

Hotpot AI

Billedgenerering

Sæt gang i kreativitet og produktivitet med AI

AI Art

Billedgenerering

AI Graphic Creation Platform

6pen Art

Billedgenerering

Gør din fantasi til kunst

Beautiful.ai

Præsentation

Introduktion af generativ AI-præsentationssoftware til arbejdspladsen

Presentations AI

Præsentation

Verdens bedste AI-præsentationsmaskine